🤖 시각적 질의응답(VQA) 시스템 구현: AI의 눈과 입을 만들어보자! 🧠👀

안녕하세요, 여러분! 오늘은 정말 흥미진진한 주제로 여러분과 함께 이야기를 나눠볼 거예요. 바로 시각적 질의응답(Visual Question Answering, VQA) 시스템에 대해서죠! 😎 이 주제, 뭔가 어려워 보이지만 걱정 마세요. 우리 함께 차근차근 파헤쳐볼 거니까요!

VQA 시스템이 뭐냐고요? 간단히 말해서, 컴퓨터가 이미지를 보고 그에 대한 질문에 답할 수 있게 만드는 거예요. 마치 여러분이 친구에게 사진을 보여주고 "이 사진에서 뭐가 보여?"라고 물어보는 것처럼요. 근데 이번엔 컴퓨터가 그 친구 역할을 하는 거죠! ㅋㅋㅋ

이 기술은 정말 대단해요. 생각해보세요. 컴퓨터가 이미지를 '이해'하고, 질문의 의미를 '파악'하고, 그에 맞는 '대답'을 할 수 있다니! 🤯 마치 SF 영화에서나 볼 법한 일이 현실이 되고 있는 거예요.

VQA 시스템은 다양한 분야에서 활용될 수 있어요. 예를 들어, 시각 장애인을 위한 보조 기술로 사용될 수 있죠. 또는 온라인 쇼핑에서 상품 이미지에 대한 질문에 자동으로 답변을 제공할 수도 있고요. 심지어 의료 분야에서 X-ray나 MRI 이미지를 분석하는 데에도 도움을 줄 수 있어요.

여러분, 혹시 재능넷이라는 사이트 아세요? 거기서도 이런 VQA 기술을 활용할 수 있을 것 같아요. 예를 들어, 사용자가 업로드한 작품 이미지에 대해 자동으로 설명을 생성하거나, 다른 사용자들의 질문에 답변을 제공하는 데 사용될 수 있겠죠. 이런 식으로 VQA 기술은 다양한 플랫폼에서 사용자 경험을 향상시킬 수 있어요.

자, 이제 본격적으로 VQA 시스템을 어떻게 구현하는지 알아볼까요? 준비되셨나요? 그럼 출발~! 🚀

🧩 VQA 시스템의 구성 요소

VQA 시스템을 만들려면 여러 가지 요소들이 필요해요. 마치 레고 블록을 조립하듯이, 이 요소들을 잘 조합해야 우리의 AI가 제대로 작동하겠죠? 그럼 어떤 요소들이 필요한지 살펴볼까요?

- 🖼️ 이미지 처리 모듈: 입력된 이미지를 이해하고 분석하는 부분

- 📝 자연어 처리 모듈: 질문을 이해하고 해석하는 부분

- 🧠 추론 엔진: 이미지 정보와 질문을 결합해 답변을 생성하는 부분

- 💾 데이터베이스: 학습에 필요한 이미지-질문-답변 데이터셋을 저장하는 부분

- 🎛️ 사용자 인터페이스: 사용자가 시스템과 상호작용할 수 있는 부분

이 요소들이 어떻게 작동하는지 좀 더 자세히 알아볼까요? 🤓

1. 이미지 처리 모듈 🖼️

이 모듈은 입력된 이미지를 컴퓨터가 이해할 수 있는 형태로 변환해요. 주로 합성곱 신경망(CNN, Convolutional Neural Network)을 사용하죠. CNN은 이미지에서 중요한 특징들을 추출해내는 데 탁월해요.

예를 들어, 고양이 사진을 입력했다고 해볼까요? CNN은 이 이미지에서 고양이의 귀, 눈, 수염 등의 특징을 인식하고, 이를 숫자로 된 벡터(특징 벡터라고 해요)로 변환해요. 이 벡터는 나중에 추론 엔진에서 사용되게 되죠.

CNN의 구조는 대략 이런 식이에요:

class CNN(nn.Module):

def __init__(self):

super(CNN, self).__init__()

self.conv1 = nn.Conv2d(3, 16, kernel_size=3, stride=1, padding=1)

self.conv2 = nn.Conv2d(16, 32, kernel_size=3, stride=1, padding=1)

self.fc = nn.Linear(32 * 56 * 56, 1000) # 예시 크기

def forward(self, x):

x = F.relu(self.conv1(x))

x = F.max_pool2d(x, 2)

x = F.relu(self.conv2(x))

x = F.max_pool2d(x, 2)

x = x.view(x.size(0), -1)

x = self.fc(x)

return x이 코드는 간단한 CNN의 예시에요. 실제로는 더 복잡한 구조를 가지겠지만, 기본적인 아이디어는 이렇답니다. 합성곱 층(Conv2d)과 풀링 층(max_pool2d)을 통해 이미지의 특징을 추출하고, 마지막에 완전 연결 층(fc)을 통해 최종 특징 벡터를 만들어내는 거죠.

2. 자연어 처리 모듈 📝

이 모듈은 사용자의 질문을 이해하고 처리하는 역할을 해요. 주로 순환 신경망(RNN, Recurrent Neural Network)이나 트랜스포머(Transformer) 모델을 사용하죠.

예를 들어, "고양이의 색깔은 무엇인가요?"라는 질문이 들어왔다고 해볼까요? 이 모듈은 질문을 단어 단위로 쪼개고, 각 단어를 숫자로 된 벡터(임베딩이라고 해요)로 변환해요. 그리고 이 벡터들을 순서대로 처리해서 질문 전체의 의미를 담은 벡터를 만들어내죠.

간단한 RNN 구조의 예시를 볼까요?

class RNN(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim):

super(RNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.rnn = nn.GRU(embedding_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, hidden_dim)

def forward(self, x):

x = self.embedding(x)

_, hidden = self.rnn(x)

out = self.fc(hidden.squeeze(0))

return out이 코드에서 embedding 층은 단어를 벡터로 변환하고, rnn 층은 이 벡터들을 순서대로 처리해요. 마지막 fc 층은 RNN의 최종 은닉 상태를 받아 질문 전체를 표현하는 벡터를 만들어내죠.

요즘엔 트랜스포머 모델이 더 많이 사용되는 추세예요. BERT나 GPT 같은 모델들이 대표적이죠. 이런 모델들은 더 복잡하지만, 긴 문장을 처리하는 데 더 뛰어난 성능을 보여줘요.

3. 추론 엔진 🧠

이 부분이 VQA 시스템의 핵심이에요! 추론 엔진은 이미지 처리 모듈에서 나온 이미지 특징과 자연어 처리 모듈에서 나온 질문 특징을 결합해서 답변을 생성해내죠.

주로 어텐션 메커니즘(Attention Mechanism)을 사용해요. 어텐션은 질문에 따라 이미지의 어떤 부분에 집중해야 할지를 결정하는 역할을 해요. 예를 들어, "고양이의 색깔은?"이라는 질문에 대해서는 고양이가 있는 부분에 집중하겠죠?

간단한 어텐션 메커니즘의 예시를 볼까요?

class Attention(nn.Module):

def __init__(self, image_dim, question_dim, hidden_dim):

super(Attention, self).__init__()

self.attention = nn.Linear(image_dim + question_dim, hidden_dim)

self.v = nn.Linear(hidden_dim, 1, bias=False)

def forward(self, image_features, question_features):

batch_size, num_regions, _ = image_features.size()

question_features = question_features.unsqueeze(1).repeat(1, num_regions, 1)

concat_features = torch.cat((image_features, question_features), dim=2)

attention = torch.tanh(self.attention(concat_features))

attention_weights = F.softmax(self.v(attention).squeeze(-1), dim=1)

weighted_features = (image_features * attention_weights.unsqueeze(-1)).sum(dim=1)

return weighted_features이 코드에서는 이미지 특징과 질문 특징을 결합하고, 이를 바탕으로 각 이미지 영역의 중요도(attention_weights)를 계산해요. 그리고 이 중요도를 이용해 이미지 특징의 가중 평균을 구하죠. 이렇게 하면 질문과 관련된 이미지 부분에 더 집중할 수 있어요.

추론 엔진의 최종 출력은 보통 답변 후보들에 대한 확률 분포 형태가 돼요. 예를 들어, "고양이의 색깔은?"이라는 질문에 대해 {흰색: 0.7, 검은색: 0.2, 갈색: 0.1} 같은 식으로 나오는 거죠. 가장 높은 확률을 가진 답변을 최종 답변으로 선택하게 되요.

4. 데이터베이스 💾

VQA 시스템을 학습시키려면 엄청난 양의 데이터가 필요해요. 이 데이터는 보통 (이미지, 질문, 답변) 형태의 트리플로 구성되죠. 예를 들면:

- 이미지: 고양이 사진

- 질문: "고양이의 색깔은?"

- 답변: "흰색"

이런 데이터셋을 만드는 건 정말 큰 작업이에요. 다행히 이미 공개된 데이터셋들이 있어요. VQA Dataset, COCO-QA, Visual7W 등이 대표적이죠. 이런 데이터셋을 사용하면 우리가 직접 데이터를 모으는 수고를 덜 수 있어요.

데이터를 효율적으로 관리하고 접근하기 위해 데이터베이스 시스템을 사용해요. SQL 기반의 관계형 데이터베이스나 MongoDB 같은 NoSQL 데이터베이스를 사용할 수 있죠. 예를 들어, MongoDB를 사용한다면 이런 식으로 데이터를 저장할 수 있어요:

{

"_id": ObjectId("5f50c31e8a43e42a1d2a5b1e"),

"image_path": "/path/to/cat_image.jpg",

"question": "고양이의 색깔은?",

"answer": "흰색",

"image_features": [0.1, 0.2, ..., 0.9], // CNN으로 추출한 특징 벡터

"question_features": [0.3, 0.4, ..., 0.7] // RNN으로 추출한 특징 벡터

}이렇게 저장해두면 학습 시에 빠르게 데이터를 불러올 수 있어요. 또, 이미지나 질문의 특징 벡터를 미리 추출해서 저장해두면 학습 속도를 더 높일 수 있죠.

5. 사용자 인터페이스 🎛️

마지막으로, 사용자가 시스템과 상호작용할 수 있는 인터페이스가 필요해요. 이건 웹 애플리케이션이 될 수도 있고, 모바일 앱이 될 수도 있죠. 재능넷 같은 플랫폼에 통합된다면, 기존 웹사이트나 앱에 VQA 기능을 추가하는 형태가 되겠네요.

간단한 웹 인터페이스의 예시를 볼까요? Flask를 사용한 파이썬 백엔드와 HTML/JavaScript 프론트엔드로 구성할 수 있어요:

from flask import Flask, request, jsonify

import torch

from PIL import Image

from model import VQAModel # 우리가 만든 VQA 모델

app = Flask(__name__)

model = VQAModel.load_from_checkpoint("path/to/checkpoint.ckpt")

@app.route('/predict', methods=['POST'])

def predict():

image = Image.open(request.files['image'])

question = request.form['question']

# 이미지와 질문을 모델 입력 형식으로 변환

image_tensor = preprocess_image(image)

question_tensor = preprocess_question(question)

# 모델로 예측

with torch.no_grad():

answer = model(image_tensor, question_tensor)

return jsonify({'answer': answer})

if __name__ == '__main__':

app.run(debug=True)이 코드는 '/predict' 엔드포인트를 만들어서 이미지와 질문을 받아 답변을 반환해요. 프론트엔드에서는 이 엔드포인트로 요청을 보내고 결과를 받아 화면에 표시하면 되죠.

사용자 인터페이스는 단순히 기능만 제공하는 게 아니라, 사용자 경험(UX)도 중요해요. 직관적이고 사용하기 쉬운 인터페이스를 만들어야 해요. 예를 들어, 드래그 앤 드롭으로 이미지를 업로드하거나, 음성 인식으로 질문을 입력할 수 있게 하는 등의 기능을 추가할 수 있죠.

자, 여기까지 VQA 시스템의 주요 구성 요소들을 살펴봤어요. 이 요소들이 어떻게 상호작용하는지 이해하셨나요? 😊 다음 섹션에서는 이 요소들을 어떻게 조합해서 실제 시스템을 구현하는지 알아볼 거예요. 준비되셨나요? Let's go! 🚀

🛠️ VQA 시스템 구현하기: 단계별 가이드

자, 이제 본격적으로 VQA 시스템을 구현해볼 거예요. 마치 레시피를 따라 요리를 하듯이, 단계별로 차근차근 만들어볼게요. 준비되셨나요? 그럼 시작해볼까요? 🥳

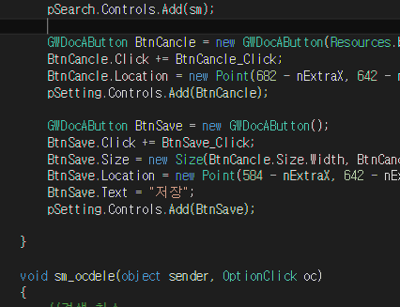

Step 1: 개발 환경 설정 🖥️

먼저 필요한 도구들을 준비해야 해요. 파이썬과 PyTorch를 주로 사용할 거예요. 아나콘다(Anaconda)를 사용하면 환경 설정이 더 쉬워요.

- 아나콘다 설치: 아나콘다 공식 사이트에서 다운로드하세요.

- 새로운 환경 생성:

conda create -n vqa_env python=3.8 conda activate vqa_env - 필요한 라이브러리 설치:

conda install pytorch torchvision cudatoolkit=10.2 -c pytorch pip install transformers pillow matplotlib nltk

이렇게 하면 기본적인 개발 환경이 준비돼요. 👍

Step 2: 데이터 준비 📊

VQA 시스템을 학습시키려면 대량의 데이터가 필요해요. 여기서는 VQA Dataset을 사용해볼게요.

- 데이터 다운로드:

wget https://s3.amazonaws.com/cvmlp/vqa/mscoco/vqa/v2_Questions_Train_mscoco.zip wget https://s3.amazonaws.com/cvmlp/vqa/mscoco/vqa/v2_Annotations_Train_mscoco.zip unzip v2_Questions_Train_mscoco.zip unzip v2_Annotations_Train_mscoco.zip - 데이터 전처리:

import json import os from PIL import Image import torch from torchvision import transforms from transformers import BertTokenizer def load_data(questions_file, annotations_file, image_dir): with open(questions_file, 'r') as f: questions = json.load(f)['questions'] with open(annotations_file, 'r') as f: annotations = json.load(f)['annotations'] data = [] for q, a in zip(questions, annotations): image_path = os.path.join(image_dir, f"COCO_train2014_{q['image_id']:012d}.jpg") data.append({ 'image_path': image_path, 'question': q['question'], 'answer': a['multiple_choice_answer'] }) return data data = load_data('v2_OpenEnded_mscoco_train2014_questions.json', 'v2_mscoco_train2014_annotations.json', 'train2014') # 이미지 전처리 transform = transforms.Compose([ transforms.Resize((224, 224)), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) ]) # 텍스트 전처리 tokenizer = BertTokenizer.from_pretrained('bert-base-uncased') def preprocess_data(item): image = Image.open(item['image_path']).convert('RGB') image = transform(image) question = tokenizer(item['question'], padding='max_length', max_length=20, truncation=True, return_tensors='pt') return { 'image': image, 'question': question['input_ids'].squeeze(0), 'answer': item['answer'] } preprocessed_data = [preprocess_data(item) for item in data]

이렇게 하면 데이터가 준비돼요. 이미지는 CNN에 맞게 크기를 조정하고 정규화했고, 질문은 BERT 토크나이저를 사용해 토큰화했어요. 👀

Step 3: 모델 구현 🧠

이제 VQA 모델을 구현해볼 거예요. CNN, BERT, 그리고 어텐션 메커니즘을 조합해서 만들어볼게요.

import torch

import torch.nn as nn

from torchvision.models import resnet50

from transformers import BertModel

class VQAModel(nn.Module):

def __init__(self, num_classes):

super(VQAModel, self).__init__()

# 이미지 인코더 (ResNet50)

self.image_encoder = resnet50(pretrained=True)

self.image_encoder.fc = nn.Identity() # 마지막 fully connected 층 제거

# 질문 인코더 (BERT)

self.question_encoder = BertModel.from_pretrained('bert-base-uncased')

# 어텐션 메커니즘

self.attention = nn.MultiheadAttention(embed_dim=768, num_heads=8)

# 분류기

self.classifier = nn.Sequential(

nn.Linear(768 * 2, 1024),

nn.ReLU(),

nn.Dropout(0.5),

nn.Linear(1024, num_classes)

)

def forward(self, image, question):

# 이미지 인코딩

image_features = self.image_encoder(image) # [batch_size, 2048]

image_features = image_features.unsqueeze(1) # [batch_size, 1, 2048]

# 질문 인코딩

question_features = self.question_encoder(question)[0] # [batch_size, seq_len, 768]

# 어텐션 적용

attn_output, _ = self.attention(question_features, image_features, image_features)

# 특징 결합

combined_features = torch.cat([attn_output.mean(dim=1), question_features.mean(dim=1)], dim=1)

# 분류

output = self.classifier(combined_features)

return output

model = VQAModel(num_classes=1000) # 답변 후보가 1000개라고 가정이 모델은 ResNet50을 사용해 이미지를 인코딩하고, BERT를 사용해 질문을 인코딩해요. 그리고 멀티헤드 어텐션을 사용해 이미지와 질문 정보를 결합하죠. 마지막으로 분류기를 통해 답변을 예측해요. 😎

Step 4: 학습 루프 구현 🏋️♀️

모델을 학습시킬 차례예요. PyTorch의 DataLoader를 사용해서 효율적으로 데이터를 불러오고, 학습 루프를 구현해볼게요.

from torch.utils.data import Dataset, DataLoader

import torch.optim as optim

class VQADataset(Dataset):

def __init__(self, data):

self.data = data

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

return self.data[idx]

# 데이터셋과 데이터로더 생성

dataset = VQADataset(preprocessed_data)

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

# 손실 함수와 옵티마이저 정의

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.0001)

# 학습 루프

num_epochs = 10

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model.to(device)

for epoch in range(num_epochs):

model.train()

total_loss = 0

for batch in dataloader:

images = batch['image'].to(device)

questions = batch['question'].to(device)

answers = batch['answer'].to(device)

optimizer.zero_grad()

outputs = model(images, questions)

loss = criterion(outputs, answers)

loss.backward()

optimizer.step()

total_loss += loss.item()

print(f"Epoch {epoch+1}/{num_epochs}, Loss: {total_loss/len(dataloader):.4f}")

# 모델 저장

torch.save(model.state_dict(), 'vqa_model.pth')이렇게 하면 모델이 학습돼요. 실제로는 더 많은 에폭(epoch)과 더 큰 데이터셋으로 학습해야 하지만, 기본적인 구조는 이런 식이에요. 💪

Step 5: 추론 및 평가 🔍

학습된 모델을 사용해 새로운 이미지와 질문에 대해 답변을 생성하고, 모델의 성능을 평가해볼 거예요.

import matplotlib.pyplot as plt

def predict(model, image_path, question):

model.eval()

image = Image.open(image_path).convert('RGB')

image = transform(image).unsqueeze(0).to(device)

question = tokenizer(question, padding='max_length', max_length=20, truncation=True, return_tensors='pt')['input_ids'].to(device)

with torch.no_grad():

output = model(image, question)

# 여기서는 간단히 가장 높은 확률의 클래스를 선택합니다.

# 실제로는 클래스 인덱스를 답변 텍스트로 매핑하는 과정이 필요합니다.

predicted_class = output.argmax().item()

return predicted_class

# 예시 이미지와 질문으로 테스트

test_image_path = 'path/to/test/image.jpg'

test_question = "What color is the cat?"

answer = predict(model, test_image_path, test_question)

print(f"Question: {test_question}")

print(f"Predicted answer: {answer}")

# 이미지 표시

plt.imshow(Image.open(test_image_path))

plt.axis('off')

plt.title(f"Q: {test_question}\nA: {answer}")

plt.show()

# 모델 평가

def evaluate(model, dataloader):

model.eval()

correct = 0

total = 0

with torch.no_grad():

for batch in dataloader:

images = batch['image'].to(device)

questions = batch['question'].to(device)

answers = batch['answer'].to(device)

outputs = model(images, questions)

_, predicted = torch.max(outputs.data, 1)

total += answers.size(0)

correct += (predicted == answers).sum().item()

accuracy = 100 * correct / total

print(f"Accuracy: {accuracy:.2f}%")

# 평가 데이터로더 생성 (실제로는 별도의 검증 세트를 사용해야 합니다)

eval_dataloader = DataLoader(dataset, batch_size=32, shuffle=False)

evaluate(model, eval_dataloader)이렇게 하면 모델의 추론 결과를 확인하고 전체적인 성능을 평가할 수 있어요. 실제 프로젝트에서는 별도의 검증 세트와 테스트 세트를 사용해야 한다는 점을 잊지 마세요! 📊

Step 6: 웹 인터페이스 구현 🌐

마지막으로, 사용자가 쉽게 사용할 수 있는 웹 인터페이스를 만들어볼게요. Flask를 사용해서 간단한 웹 서버를 구현하고, HTML과 JavaScript로 프론트엔드를 만들어볼 거예요.

# app.py

from flask import Flask, request, jsonify, render_template

import torch

from PIL import Image

from torchvision import transforms

from transformers import BertTokenizer

from model import VQAModel # 우리가 정의한 모델

app = Flask(__name__)

# 모델 로드

model = VQAModel(num_classes=1000)

model.load_state_dict(torch.load('vqa_model.pth'))

model.eval()

# 전처리 함수들

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

@app.route('/')

def home():

return render_template('index.html')

@app.route('/predict', methods=['POST'])

def predict():

if 'image' not in request.files:

return jsonify({'error': 'No image provided'}), 400

image = Image.open(request.files['image']).convert('RGB')

question = request.form['question']

# 이미지와 질문 전처리

image = transform(image).unsqueeze(0)

question = tokenizer(question, padding='max_length', max_length=20, truncation=True, return_tensors='pt')['input_ids']

# 예측

with torch.no_grad():

output = model(image, question)

predicted_class = output.argmax().item()

# 여기서는 클래스 인덱스를 반환하지만, 실제로는 이를 답변 텍스트로 변환해야 합니다.

return jsonify({'answer': predicted_class})

if __name__ == '__main__':

app.run(debug=True)그리고 HTML 템플릿을 만들어볼게요:

<!-- templates/index.html -->

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>VQA Demo</title>

<style>

body { font-family: Arial, sans-serif; max-width: 800px; margin: 0 auto; padding: 20px; }

#imagePreview { max-width: 100%; margin-top: 20px; }

</style>

</head>

<body>

<h1>Visual Question Answering Demo</h1>

<form id="vqaForm">

<input type="file" id="imageInput" accept="image/*" required>

<br><br>

<input type="text" id="questionInput" placeholder="Ask a question about the image" required>

<br><br>

<button type="submit">Get Answer</button>

</form>

<img id="imagePreview">

<p id="result"></p>

<script>

document.getElementById('vqaForm').addEventListener('submit', async (e) => {

e.preventDefault();

const formData = new FormData();

formData.append('image', document.getElementById('imageInput').files[0]);

formData.append('question', document.getElementById('questionInput').value);

const response = await fetch('/predict', {

method: 'POST',

body: formData

});

const data = await response.json();

document.getElementById('result').textContent = `Answer: ${data.answer}`;

});

document.getElementById('imageInput').addEventListener('change', (e) => {

const file = e.target.files[0];

const reader = new FileReader();

reader.onload = (e) => {

document.getElementById('imagePreview').src = e.target.result;

};

reader.readAsDataURL(file);

});

</script>

</body>

</html>이렇게 하면 사용자가 이미지를 업로드하고 질문을 입력할 수 있는 간단한 웹 인터페이스가 완성돼요. Flask 서버를 실행하고 브라우저에서 접속하면 VQA 시스템을 직접 사용해볼 수 있어요! 🎉

자, 여기까지 VQA 시스템의 전체적인 구현 과정을 살펴봤어요. 물론 이건 기본적인 구현이고, 실제로 고성능의 시스템을 만들려면 더 많은 작업이 필요해요. 예를 들어:

- 더 큰 데이터셋으로 학습하기

- 모델 아키텍처 개선하기 (예: 더 강력한 백본 네트워크 사용)

- 하이퍼파라미터 튜닝

- 앙상블 기법 적용

- 데이터 증강 기법 사용

- 다국어 지원

하지만 이 기본 구현을 통해 VQA 시스템의 핵심 개념과 구조를 이해하실 수 있을 거예요. 여러분의 프로젝트에 맞게 이를 확장하고 개선해 나가면 돼요. 화이팅! 💪😄

🚀 VQA 시스템의 미래와 응용 분야

자, 이제 우리가 만든 VQA 시스템이 어떤 분야에서 활용될 수 있을지, 그리고 앞으로 어떻게 발전할지 살펴볼까요? 🤔

1. 교육 분야 📚

VQA 시스템은 교육 분야에서 혁신적인 도구가 될 수 있어요.

- 학생들이 교과서나 학습 자료의 이미지에 대해 질문하면 즉시 답변을 받을 수 있어요.

- 시각적 학습 자료의 이해도를 높이는 데 도움이 될 거예요.

- 예를 들어, 생물학 수업에서 세포 구조 이미지에 대해 질문하면 각 부분의 기능을 설명해줄 수 있죠.

2. 의료 분야 🏥

의료 영상 분석에 VQA 시스템을 적용하면 정말 큰 도움이 될 거예요.

- X-ray, MRI, CT 스캔 등의 의료 영상에 대해 의사들이 질문을 할 수 있어요.

- 예를 들어, "이 MRI 영상에서 종양의 크기는 얼마인가요?" 같은 질문에 답할 수 있죠.

- 이를 통해 진단 속도를 높이고 정확도를 개선할 수 있을 거예요.

3. 전자상거래 🛒

온라인 쇼핑 경험을 더욱 풍부하게 만들 수 있어요.

- 고객이 제품 이미지를 보고 "이 옷의 소재는 뭔가요?" 또는 "이 가구는 어떤 스타일인가요?" 같은 질문을 할 수 있어요.

- 제품 설명을 읽지 않고도 필요한 정보를 빠르게 얻을 수 있죠.

- 이는 구매 결정을 돕고 고객 만족도를 높일 수 있어요.

4. 보안 및 감시 시스템 🔒

CCTV 영상 분석에 VQA 시스템을 적용할 수 있어요.

- "이 영상에서 수상한 행동을 하는 사람이 있나요?" 같은 질문에 답할 수 있어요.

- 대량의 영상 데이터를 효율적으로 분석하는 데 도움이 될 거예요.

- 단, 프라이버시 문제에 주의해야 해요.

5. 접근성 개선 ♿

시각 장애인을 위한 도구로 활용될 수 있어요.

- 주변 환경을 촬영하고 "내 앞에 무엇이 있나요?" 같은 질문을 할 수 있어요.

- 이미지나 문서의 내용을 설명해주는 역할을 할 수 있죠.

- 이를 통해 시각 장애인의 일상생활과 정보 접근성을 크게 개선할 수 있어요.

이런 응용 분야들을 생각하면 정말 흥미진진하지 않나요? 😃 그런데 VQA 기술이 더욱 발전하려면 어떤 과제들을 해결해야 할까요?

- 다국어 지원: 전 세계 사용자들을 위해 다양한 언어로 질문하고 답변할 수 있어야 해요.

- 추론 능력 향상: 단순한 사실 확인을 넘어, 이미지에 대한 깊이 있는 추론이 가능해야 해요.

- 실시간 처리: 대용량 영상 스트림에서 실시간으로 질의응답이 가능해야 해요.

- 설명 가능성: AI가 왜 그런 답변을 했는지 설명할 수 있어야 해요.

- 멀티모달 통합: 이미지뿐만 아니라 비디오, 오디오 등 다양한 형태의 데이터를 함께 처리할 수 있어야 해요.

이런 과제들을 해결해 나가면서 VQA 시스템은 점점 더 강력해지고 우리 일상 깊숙이 자리 잡게 될 거예요. 여러분도 이 흥미진진한 여정에 동참하고 싶지 않나요? 🚀

VQA 기술은 AI와 인간의 상호작용을 한 단계 더 발전시킬 수 있는 잠재력을 가지고 있어요. 우리가 만든 이 작은 프로젝트가 어쩌면 미래의 큰 혁신으로 이어질 수도 있죠. 여러분의 상상력과 창의력으로 이 기술을 더욱 발전시켜 나가길 기대해요! 💖