스프링 배치로 대용량 데이터 처리하기 🚀

현대 기업 환경에서 대용량 데이터 처리는 필수적인 요소가 되었습니다. 특히 Java 기반의 엔터프라이즈 애플리케이션 개발에서 스프링 배치(Spring Batch)는 강력한 도구로 자리 잡았죠. 이 글에서는 스프링 배치를 활용하여 대용량 데이터를 효율적으로 처리하는 방법에 대해 상세히 알아보겠습니다. 🧐

스프링 배치는 대량의 데이터 처리, 자동화된 복잡한 처리 등을 위한 강력한 프레임워크입니다. 재능넷과 같은 플랫폼에서도 사용자 데이터 분석, 주기적인 리포트 생성 등에 이러한 기술이 활용될 수 있죠. 그럼 지금부터 스프링 배치의 세계로 깊이 들어가 보겠습니다! 🏊♂️

1. 스프링 배치 소개 📚

스프링 배치는 엔터프라이즈 시스템의 일상적인 운영에 필수적인 강력한 배치 처리 프레임워크입니다. 대량의 데이터 처리, 트랜잭션 관리, 작업 재시작 기능, 단계별 처리 등 다양한 기능을 제공합니다.

주요 특징은 다음과 같습니다:

- 확장성: 대용량 데이터 처리에 최적화

- 안정성: 트랜잭션 관리 및 오류 복구 기능

- 유연성: 다양한 데이터 소스 및 처리 방식 지원

- 모니터링: 작업 진행 상황 추적 및 로깅

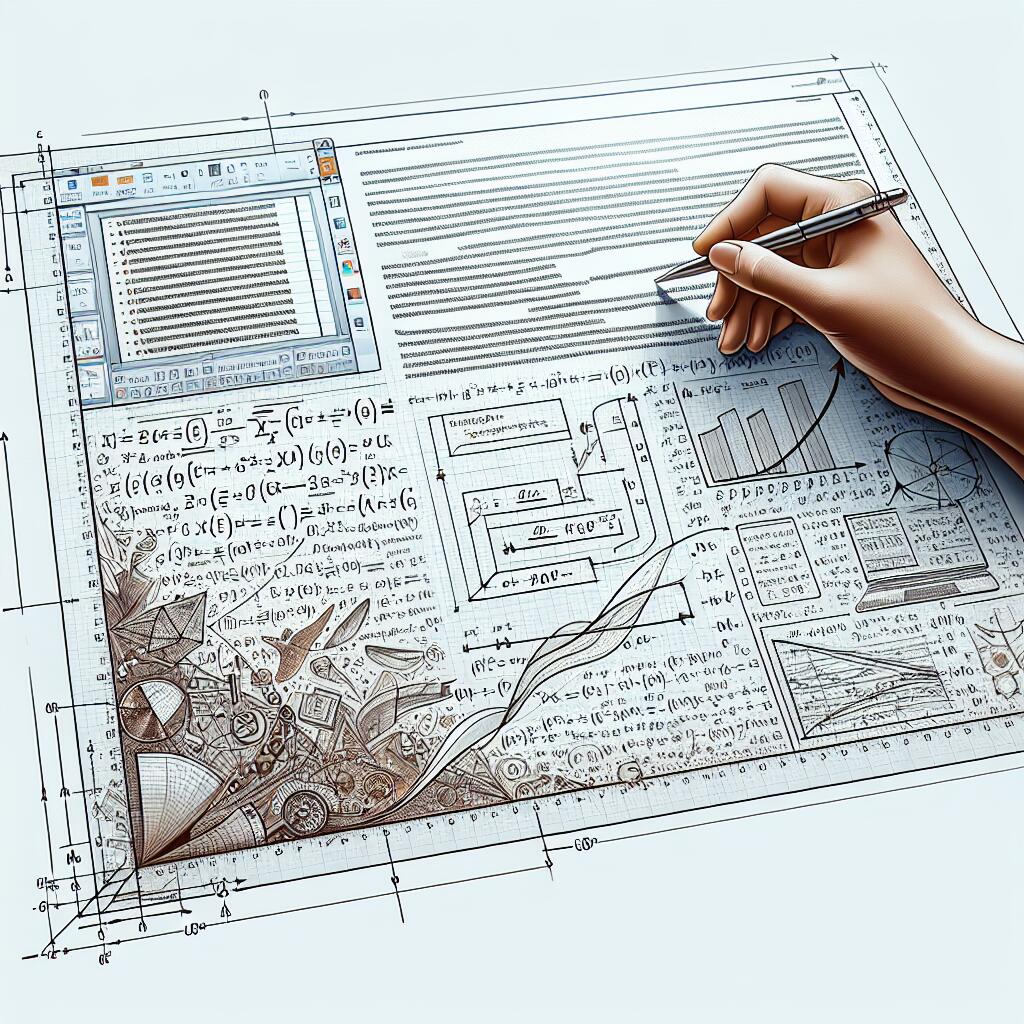

스프링 배치의 아키텍처는 크게 세 가지 주요 컴포넌트로 구성됩니다:

1. JobRepository: 배치 처리 정보를 저장하고 관리

2. JobLauncher: 배치 Job을 실행

3. Job: 배치 처리의 전체 프로세스를 정의

이러한 구조를 통해 스프링 배치는 복잡한 대용량 데이터 처리 작업을 효율적으로 관리할 수 있습니다. 😊

위 다이어그램은 스프링 배치의 기본 아키텍처를 보여줍니다. 각 컴포넌트는 서로 유기적으로 연결되어 효율적인 배치 처리를 가능하게 합니다. 🔗

2. 스프링 배치 설정하기 ⚙️

스프링 배치를 프로젝트에 설정하는 것은 생각보다 간단합니다. Maven이나 Gradle과 같은 빌드 도구를 사용하여 의존성을 추가하고, 몇 가지 기본 설정만 하면 됩니다.

먼저, Maven을 사용하는 경우 pom.xml 파일에 다음 의존성을 추가합니다:

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-batch</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-jpa</artifactId>

</dependency>

<dependency>

<groupId>com.h2database</groupId>

<artifactId>h2</artifactId>

<scope>runtime</scope>

</dependency>Gradle을 사용하는 경우 build.gradle 파일에 다음과 같이 추가합니다:

dependencies {

implementation 'org.springframework.boot:spring-boot-starter-batch'

implementation 'org.springframework.boot:spring-boot-starter-data-jpa'

runtimeOnly 'com.h2database:h2'

}

다음으로, 스프링 배치 설정을 위한 Java 설정 클래스를 만듭니다:

@Configuration

@EnableBatchProcessing

public class BatchConfig {

@Autowired

public JobBuilderFactory jobBuilderFactory;

@Autowired

public StepBuilderFactory stepBuilderFactory;

// Job 및 Step 설정

}@EnableBatchProcessing 어노테이션은 스프링 배치 기능을 활성화하고, 필요한 빈들을 자동으로 등록합니다. 🔧

마지막으로, application.properties 또는 application.yml 파일에 데이터베이스 설정을 추가합니다:

spring.datasource.url=jdbc:h2:mem:testdb

spring.datasource.driverClassName=org.h2.Driver

spring.datasource.username=sa

spring.datasource.password=

spring.jpa.database-platform=org.hibernate.dialect.H2Dialect

spring.batch.job.enabled=false # 애플리케이션 시작 시 모든 배치 작업 자동 실행 방지이렇게 기본 설정을 마치면, 스프링 배치를 사용할 준비가 완료됩니다! 🎉

💡 Tip: 실제 프로덕션 환경에서는 H2 대신 MySQL, PostgreSQL 등의 데이터베이스를 사용하는 것이 좋습니다. 또한, 보안을 위해 데이터베이스 접속 정보는 환경 변수나 외부 설정 파일로 관리하는 것이 바람직합니다.

이제 기본적인 설정이 완료되었으니, 본격적으로 배치 Job을 만들어 볼까요? 다음 섹션에서 자세히 알아보겠습니다! 👀

3. 배치 Job 구현하기 🛠️

스프링 배치에서 Job은 배치 처리의 전체 흐름을 정의합니다. Job은 하나 이상의 Step으로 구성되며, 각 Step은 실제 처리 로직을 포함합니다. 대용량 데이터 처리를 위한 간단한 예제를 통해 Job 구현 방법을 살펴보겠습니다.

먼저, 처리할 데이터를 위한 모델 클래스를 정의합니다:

public class User {

private Long id;

private String name;

private String email;

// 생성자, getter, setter 생략

}

다음으로, ItemReader, ItemProcessor, ItemWriter를 구현합니다:

@Configuration

public class UserBatchConfig {

@Autowired

private DataSource dataSource;

@Bean

public JdbcCursorItemReader<User> reader() {

return new JdbcCursorItemReaderBuilder<User>()

.name("userReader")

.dataSource(dataSource)

.sql("SELECT id, name, email FROM users")

.rowMapper(new BeanPropertyRowMapper<>(User.class))

.build();

}

@Bean

public ItemProcessor<User, User> processor() {

return user -> {

user.setEmail(user.getEmail().toUpperCase());

return user;

};

}

@Bean

public JdbcBatchItemWriter<User> writer() {

return new JdbcBatchItemWriterBuilder<User>()

.dataSource(dataSource)

.sql("UPDATE users SET email = :email WHERE id = :id")

.beanMapped()

.build();

}

}위 코드에서는 데이터베이스에서 사용자 정보를 읽어와 이메일 주소를 대문자로 변경한 후 다시 데이터베이스에 저장하는 간단한 배치 처리를 구현했습니다. 🔄

이제 Job과 Step을 정의합니다:

@Configuration

public class UserBatchJob {

@Autowired

private JobBuilderFactory jobBuilderFactory;

@Autowired

private StepBuilderFactory stepBuilderFactory;

@Autowired

private ItemReader<User> reader;

@Autowired

private ItemProcessor<User, User> processor;

@Autowired

private ItemWriter<User> writer;

@Bean

public Job updateUserJob() {

return jobBuilderFactory.get("updateUserJob")

.start(step1())

.build();

}

@Bean

public Step step1() {

return stepBuilderFactory.get("step1")

.<User, User>chunk(100)

.reader(reader)

.processor(processor)

.writer(writer)

.build();

}

}이 Job 설정에서는 하나의 Step을 가진 Job을 정의했습니다. Step은 chunk 기반으로 처리되며, 한 번에 100개의 아이템을 처리합니다. 🔢

🔍 Chunk 처리란?

Chunk 처리는 대량의 데이터를 일정 단위로 나누어 처리하는 방식입니다. 이를 통해 메모리 사용량을 제어하고, 오류 발생 시 해당 Chunk만 롤백할 수 있어 효율적인 대용량 데이터 처리가 가능합니다.

이제 배치 Job을 실행하는 방법을 알아보겠습니다:

@SpringBootApplication

@EnableBatchProcessing

public class BatchApplication implements CommandLineRunner {

@Autowired

private JobLauncher jobLauncher;

@Autowired

private Job updateUserJob;

public static void main(String[] args) {

SpringApplication.run(BatchApplication.class, args);

}

@Override

public void run(String... args) throws Exception {

JobParameters jobParameters = new JobParametersBuilder()

.addLong("time", System.currentTimeMillis())

.toJobParameters();

jobLauncher.run(updateUserJob, jobParameters);

}

}이 코드는 애플리케이션 시작 시 배치 Job을 실행합니다. JobParameters를 사용하여 각 실행마다 고유한 파라미터를 전달할 수 있습니다. ⏱️

지금까지 기본적인 배치 Job 구현 방법을 살펴보았습니다. 하지만 실제 대용량 데이터 처리에서는 더 복잡한 시나리오와 최적화가 필요합니다. 다음 섹션에서는 대용량 데이터 처리를 위한 고급 기법들을 알아보겠습니다! 🚀

위 다이어그램은 스프링 배치 Job의 기본 흐름을 보여줍니다. ItemReader, ItemProcessor, ItemWriter가 Chunk 단위로 처리되는 과정을 시각화했습니다. 이해하기 쉽죠? 😊

4. 대용량 데이터 처리를 위한 최적화 기법 🚀

대용량 데이터를 효율적으로 처리하기 위해서는 단순히 기본적인 배치 Job 구현만으로는 부족할 수 있습니다. 여기서는 스프링 배치를 사용하여 대용량 데이터를 처리할 때 활용할 수 있는 다양한 최적화 기법들을 살펴보겠습니다.

4.1 페이징 기법 활용 📚

대량의 데이터를 한 번에 메모리에 로드하는 것은 비효율적이며 때로는 불가능할 수 있습니다. 이럴 때 페이징 기법을 사용하면 효과적입니다.

@Bean

public JdbcPagingItemReader<User> pagingItemReader() {

return new JdbcPagingItemReaderBuilder<User>()

.name("pagingItemReader")

.dataSource(dataSource)

.queryProvider(createQueryProvider())

.pageSize(1000)

.rowMapper(new BeanPropertyRowMapper<>(User.class))

.build();

}

private PagingQueryProvider createQueryProvider() throws Exception {

SqlPagingQueryProviderFactoryBean factory = new SqlPagingQueryProviderFactoryBean();

factory.setDataSource(dataSource);

factory.setSelectClause("SELECT id, name, email");

factory.setFromClause("FROM users");

factory.setSortKey("id");

return factory.getObject();

}이 예제에서는 JdbcPagingItemReader를 사용하여 1000개 단위로 데이터를 읽어옵니다. 이를 통해 메모리 사용량을 제어하고 대량의 데이터를 효율적으로 처리할 수 있습니다. 📊

4.2 멀티스레드 Step 구현 🧵

단일 스레드로 처리하는 것보다 멀티스레드를 활용하면 처리 속도를 크게 향상시킬 수 있습니다.

@Bean

public Step multiThreadStep() {

return stepBuilderFactory.get("multiThreadStep")

.<User, User>chunk(100)

.reader(pagingItemReader())

.processor(processor())

.writer(writer())

.taskExecutor(taskExecutor())

.build();

}

@Bean

public TaskExecutor taskExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(5);

executor.setMaxPoolSize(10);

executor.setQueueCapacity(25);

return executor;

}이 설정은 5-10개의 스레드를 사용하여 Step을 병렬로 처리합니다. 단, 멀티스레드 환경에서는 데이터 정합성에 주의해야 합니다. 🔄

4.3 파티셔닝 활용 🧩

파티셔닝은 데이터를 여러 파티션으로 나누어 병렬 처리하는 기법입니다. 특히 대용량 데이터를 처리할 때 유용합니다.

@Bean

public Step partitionStep() {

return stepBuilderFactory.get("partitionStep")

.partitioner("slaveStep", partitioner())

.step(slaveStep())

.gridSize(10)

.taskExecutor(taskExecutor())

.build();

}

@Bean

public Partitioner partitioner() {

return new Partitioner() {

@Override

public Map<String, ExecutionContext> partition(int gridSize) {

Map<String, ExecutionContext> result = new HashMap<>();

for (int i = 0; i < gridSize; i++) {

ExecutionContext context = new ExecutionContext();

context.putLong("minValue", i * 1000);

context.putLong("maxValue", (i + 1) * 1000);

result.put("partition" + i, context);

}

return result;

}

};

}

@Bean

public Step slaveStep() {

return stepBuilderFactory.get("slaveStep")

.<User, User>chunk(100)

.reader(itemReader(null, null))

.processor(processor())

.writer(writer())

.build();

}

@Bean

@StepScope

public ItemReader<User> itemReader(

@Value("#{stepExecutionContext[minValue]}") Long minValue,

@Value("#{stepExecutionContext[maxValue]}") Long maxValue) {

return new JdbcCursorItemReaderBuilder<User>()

.name("userReader")

.dataSource(dataSource)

.sql("SELECT id, name, email FROM users WHERE id BETWEEN ? AND ?")

.preparedStatementSetter(

new ArgumentPreparedStatementSetter(new Object[]{minValue, maxValue})

)

.rowMapper(new BeanPropertyRowMapper<>(User.class))

.build();

}이 예제에서는 데이터를 10개의 파티션으로 나누어 병렬 처리합니다. 각 파티션은 독립적으로 처리되므로 대용량 데이터 처리 성능을 크게 향상시킬 수 있습니다. 🚀

⚠️ 주의사항: 파티셔닝을 사용할 때는 데이터의 특성을 고려해야 합니다. 예를 들어, 데이터의 분포가 고르지 않다면 일부 파티션에 작업이 몰릴 수 있으므로 적절한 파티셔닝 전략을 세워야 합니다.

4.4 성능 모니터링 및 튜닝 📊

대용량 데이터 처리에서는 성능 모니터링과 지속적인 튜닝이 중요합니다. 스프링 배치는 다양한 메트릭을 제공하여 성능을 모니터링할 수 있게 해줍니다.

@Bean

public JobExecutionListener jobExecutionListener() {

return new JobExecutionListener() {

@Override

public void beforeJob(JobExecution jobExecution) {

System.out.println("Job started at: " + new Date());

}

@Override

public void afterJob(JobExecution jobExecution) {

System.out.println("Job finished at: " + new Date());

System.out.println("Job status: " + jobExecution.getStatus());

System.out.println("Job duration: " + (jobExecution.getEndTime().getTime() - jobExecution.getStartTime().getTime()) + "ms");

}

};

}

@Bean

public Job monitoredJob() {

return jobBuilderFactory.get("monitoredJob")

.start(step1())

.listener(jobExecutionListener())

.build();

}이 리스너를 통해 Job의 시작 시간, 종료 시간, 실행 시간, 상태 등을 모니터링할 수 있습니다. 이러한 정보를 바탕으로 성능 병목 지점을 파악하고 최적화할 수 있습니다. 📈

지금까지 살펴본 최적화 기법들을 적절히 조합하여 사용하면, 대용량 데이터 처리 성능을 크게 향상시킬 수 있습니다. 재능넷과 같은 플랫폼에서도 이러한 기술을 활용하여 사용자 데이터 분석, 추천 시스템 구축 등 다양한 대용량 데이터 처리 작업을 효율적으로 수행할 수 있을 것입니다. 💪

다음 섹션에서는 실제 프로젝트에서 스프링 배치를 활용한 사례와 주의사항에 대해 알아보겠습니다. 계속해서 흥미진진한 스프링 배치의 세계로 함께 가볼까요? 🚀

5. 실제 프로젝트 적용 사례 및 주의사항 🏭

지금까지 스프링 배치의 기본 개념과 대용량 데이터 처리를 위한 최적화 기법들을 살펴보았습니다. 이제 실제 프로젝트에서 스프링 배치를 어떻게 활용할 수 있는지, 그리고 주의해야 할 점은 무엇인지 알아보겠습니다.

5.1 실제 적용 사례 📊

1. 일일 매출 집계 시스템

대규모 전자상거래 플랫폼에서는 매일 밤 전날의 매출 데이터를 집계하여 리포트를 생성해야 합니다. 이때 스프링 배치를 활용하면 효과적입니다.

@Configuration

public class DailySalesReportJobConfig {

@Autowired

private JobBuilderFactory jobBuilderFactory;

@Autowired

private StepBuilderFactory stepBuilderFactory;

@Bean

public Job dailySalesReportJob() {

return jobBuilderFactory.get("dailySalesReportJob")

.start(collectSalesData())

.next(generateReport())

.build();

}

@Bean

public Step collectSalesData() {

return stepBuilderFactory.get("collectSalesData")

.<Sale, SalesSummary>chunk(1000)

.reader(saleItemReader())

.processor(saleItemProcessor())

.writer(salesSummaryWriter())

.build();

}

@Bean

public Step generateReport() {

return stepBuilderFactory.get("generateReport")

.tasklet(reportGenerationTasklet())

.build();

}

// reader, processor, writer, tasklet 구현 생략

}이 예제에서는 판매 데이터를 수집하고 요약하는 step과 최종 리포트를 생성하는 step으로 구성된 Job을 정의했습니다. 🛒

2. 대용량 이메일 발송 시스템

수백만 명의 사용자에게 개인화된 이메일을 발송해야 하는 경우, 스프링 배치의 파티셔닝 기능을 활용할 수 있습니다.

@Configuration

public class BulkEmailJobConfig {

@Autowired

private JobBuilderFactory jobBuilderFactory;

@Autowired

private StepBuilderFactory stepBuilderFactory;

@Bean

public Job bulkEmailJob() {

return jobBuilderFactory.get("bulkEmailJob")

.start(masterStep())

.build();

}

@Bean

public Step masterStep() {

return stepBuilderFactory.get("masterStep")

.partitioner("workerStep", userPartitioner())

.step(workerStep())

.gridSize(10)

.taskExecutor(taskExecutor())

.build();

}

@Bean

public Step workerStep() {

return stepBuilderFactory.get("workerStep")

.<User, Email>chunk(100)

.reader(userItemReader(null, null))

.processor(emailProcessor())

.writer(emailSender())

.build();

}

// partitioner, reader, processor, writer 구현 생략

}이 구성에서는 사용자 데이터를 10개의 파티션으로 나누어 병렬로 이메일을 생성하고 발송합니다. 이를 통해 대량의 이메일을 빠르게 처리할 수 있습니다. 📧

5.2 주의사항 및 베스트 프랙티스 ⚠️

1. 트랜잭션 관리

대용량 데이터 처리 시 트랜잭션 범위를 적절히 설정하는 것이 중요합니다. 너무 큰 트랜잭션은 데이터베이스 리소스를 과도하게 사용할 수 있으며, 너무 작은 트랜잭션은 성능 저하를 초래할 수 있습니다.

@Bean

public Step transactionManagedStep() {

return stepBuilderFactory.get("transactionManagedStep")

.<User, User>chunk(100) // 적절한 chunk 크기 설정

.reader(reader())

.processor(processor())

.writer(writer())

.faultTolerant()

.retryLimit(3)

.retry(DeadlockLoserDataAccessException.class)

.build();

}2. 에러 처리 및 재시도 로직

대용량 처리 중 발생할 수 있는 다양한 에러 상황에 대비해야 합니다. 스프링 배치는 재시도, 건너뛰기 등의 기능을 제공합니다.

@Bean

public Step errorHandlingStep() {

return stepBuilderFactory.get("errorHandlingStep")

.<User, User>chunk(100)

.reader(reader())

.processor(processor())

.writer(writer())

.faultTolerant()

.retryLimit(3)

.retry(TemporaryNetworkException.class)

.skip(InvalidDataException.class)

.skipLimit(10)

.build();

}3. 리소스 관리

대용량 데이터 처리 시 메모리, CPU, 데이터베이스 연결 등의 리소스 사용을 모니터링하고 최적화해야 합니다.

@Bean

public DataSource dataSource() {

HikariConfig config = new HikariConfig();

config.setJdbcUrl("jdbc:mysql://localhost:3306/batchdb");

config.setUsername("user");

config.setPassword("password");

config.setMaximumPoolSize(20); // 적절한 커넥션 풀 크기 설정

return new HikariDataSource(config);

}4. 테스트 및 모니터링

대용량 데이터 처리 작업은 반드시 철저한 테스트를 거쳐야 하며, 운영 환경에서도 지속적인 모니터링이 필요합니다.

@Configuration

@EnableBatchProcessing

public class BatchMonitoringConfig {

@Bean

public JobExecutionListener monitoringListener() {

return new JobExecutionListener() {

@Override

public void beforeJob(JobExecution jobExecution) {

// 작업 시작 로깅

}

@Override

public void afterJob(JobExecution jobExecution) {

// 작업 완료 후 메트릭 수집 및 알림

if (jobExecution.getStatus() == BatchStatus.COMPLETED) {

// 성공 메트릭 기록

} else {

// 실패 알림 발송

}

}

};

}

}💡 Tip: 실제 운영 환경과 유사한 대용량 데이터로 테스트를 진행하는 것이 중요합니다. 또한, 점진적으로 데이터 양을 늘려가며 성능을 측정하고 최적화하는 것이 좋습니다.

이러한 사례와 주의사항들을 고려하여 스프링 배치를 구현한다면, 재능넷과 같은 플랫폼에서도 안정적이고 효율적인 대용량 데이터 처리 시스템을 구축할 수 있을 것입니다. 사용자 데이터 분석, 주기적인 시스템 정비, 대규모 알림 발송 등 다양한 시나리오에 스프링 배치를 적용해 보세요! 🚀

스프링 배치를 활용한 대용량 데이터 처리는 끊임없는 최적화와 모니터링이 필요한 도전적인 작업입니다. 하지만 이를 통해 얻을 수 있는 시스템의 안정성과 확장성은 그 노력을 충분히 보상할 것입니다. 여러분의 프로젝트에서 스프링 배치를 어떻게 활용하고 계신가요? 새로운 도전을 시작해보세요! 💪

6. 결론 및 향후 전망 🔮

지금까지 스프링 배치를 활용한 대용량 데이터 처리에 대해 깊이 있게 살펴보았습니다. 이제 우리가 배운 내용을 정리하고, 스프링 배치의 미래에 대해 생각해 보겠습니다.

6.1 핵심 요약 📌

- 스프링 배치는 대용량 데이터 처리를 위한 강력하고 유연한 프레임워크입니다.

- Job과 Step을 통해 복잡한 배치 프로세스를 구조화할 수 있습니다.

- 청크 기반 처리, 페이징, 멀티스레딩, 파티셔닝 등의 기술을 활용하여 성능을 최적화할 수 있습니다.

- 실제 프로젝트에서는 트랜잭션 관리, 에러 처리, 리소스 관리 등에 주의를 기울여야 합니다.

- 지속적인 모니터링과 테스트가 안정적인 배치 시스템 운영의 핵심입니다.

6.2 스프링 배치의 미래 🚀

스프링 배치는 계속해서 발전하고 있으며, 앞으로도 다음과 같은 방향으로 진화할 것으로 예상됩니다:

- 클라우드 네이티브 지원 강화: 쿠버네티스, 도커 등의 컨테이너 기술과의 통합이 더욱 강화될 것입니다.

- 실시간 처리와의 융합: 배치 처리와 실시간 처리의 경계가 흐려지면서, 하이브리드 형태의 데이터 처리 패턴이 등장할 수 있습니다.

- AI/ML 통합: 대용량 데이터 처리와 인공지능/머신러닝 모델 훈련 및 추론 과정의 통합이 가속화될 것입니다.

- 더 나은 모니터링 및 observability: 복잡한 배치 작업의 모니터링과 문제 해결을 위한 도구들이 더욱 발전할 것입니다.

- 서버리스 아키텍처 지원: AWS Lambda나 Azure Functions 같은 서버리스 환경에서의 배치 처리 지원이 강화될 수 있습니다.

🌟 미래를 위한 준비: 빅데이터, 클라우드 컴퓨팅, AI 등의 기술 트렌드를 주시하며, 이들과 스프링 배치를 어떻게 결합할 수 있을지 고민해보는 것이 좋습니다. 새로운 기술에 대한 학습과 실험을 두려워하지 마세요!

6.3 마무리 생각 💭

스프링 배치는 대용량 데이터 처리를 위한 강력한 도구이지만, 그 자체로 만능 해결책은 아닙니다. 각 프로젝트의 특성과 요구사항을 잘 이해하고, 적절한 기술을 선택하여 조화롭게 사용하는 것이 중요합니다.

재능넷과 같은 플랫폼에서 스프링 배치를 활용한다면, 사용자 데이터 분석, 추천 시스템 개선, 정기적인 리포트 생성 등 다양한 영역에서 큰 가치를 창출할 수 있을 것입니다. 하지만 동시에, 실시간 처리가 필요한 영역에서는 다른 기술과의 조화로운 사용을 고려해야 합니다.

기술은 끊임없이 발전하고 있습니다. 스프링 배치를 마스터하는 것도 중요하지만, 더 넓은 시야에서 데이터 처리 기술의 흐름을 이해하고 준비하는 것이 미래를 위한 현명한 선택일 것입니다.

여러분의 프로젝트에서 스프링 배치를 어떻게 활용하고 계신가요? 어떤 도전과 성공을 경험하셨나요? 여러분의 경험과 통찰이 다른 개발자들에게도 큰 도움이 될 수 있습니다. 함께 배우고 성장하는 개발 커뮤니티를 만들어 나가는 것, 그것이 바로 우리 모두의 미래를 밝히는 길일 것입니다. 🌟

스프링 배치와 함께하는 여러분의 개발 여정에 무한한 발전과 성공이 있기를 바랍니다! 화이팅! 💪😊