대화형 데이터 분석: Jupyter Notebook과 Google Colab 활용 🚀

데이터 분석과 머신러닝 분야에서 대화형 개발 환경의 중요성이 날로 커지고 있습니다. 특히 Jupyter Notebook과 Google Colab은 이러한 트렌드를 선도하는 핵심 도구로 자리잡았죠. 이 글에서는 이 두 플랫폼을 활용한 대화형 데이터 분석의 세계로 여러분을 안내하겠습니다.

데이터 사이언티스트, 연구원, 학생들에게 필수적인 이 도구들은 코드 실행, 시각화, 문서화를 하나의 환경에서 가능케 합니다. 마치 재능넷에서 다양한 재능이 한 곳에 모이듯, Jupyter와 Colab은 데이터 분석에 필요한 모든 요소를 한데 모아놓았다고 할 수 있죠.

이 글을 통해 여러분은 Jupyter Notebook과 Google Colab의 기본 사용법부터 고급 기능까지 상세히 알아볼 수 있습니다. 실제 프로젝트에 적용할 수 있는 실용적인 팁과 함께, 최신 트렌드를 반영한 고급 기법들도 소개할 예정입니다.

자, 그럼 대화형 데이터 분석의 흥미진진한 세계로 함께 떠나볼까요? 🌟

1. Jupyter Notebook 소개 📘

Jupyter Notebook은 오픈 소스 웹 애플리케이션으로, 실시간 코드 실행, 시각화, 마크다운 문서 작성 등을 지원하는 대화형 개발 환경입니다. 'Jupyter'라는 이름은 Julia, Python, R이라는 세 가지 핵심 프로그래밍 언어의 앞 글자를 따서 만들어졌습니다.

1.1 Jupyter Notebook의 특징

- 대화형 실행: 코드를 셀 단위로 실행하고 즉시 결과를 확인할 수 있습니다.

- 다양한 언어 지원: Python, R, Julia 등 40개 이상의 프로그래밍 언어를 지원합니다.

- Rich Output: 텍스트뿐만 아니라 이미지, 비디오, LaTeX 수식 등 다양한 형태의 출력을 지원합니다.

- 마크다운 지원: 문서화와 설명을 위한 마크다운 셀을 제공합니다.

- 확장성: 다양한 플러그인과 확장 기능을 통해 기능을 확장할 수 있습니다.

1.2 Jupyter Notebook의 구조

Jupyter Notebook은 크게 두 가지 유형의 셀로 구성됩니다:

- 코드 셀: 실행 가능한 코드를 입력하고 결과를 출력하는 셀입니다.

- 마크다운 셀: 설명, 문서화, 수식 등을 작성할 수 있는 셀입니다.

이러한 구조는 코드와 설명을 번갈아가며 작성할 수 있게 해주어, 데이터 분석 과정을 스토리텔링 형식으로 구성할 수 있게 해줍니다.

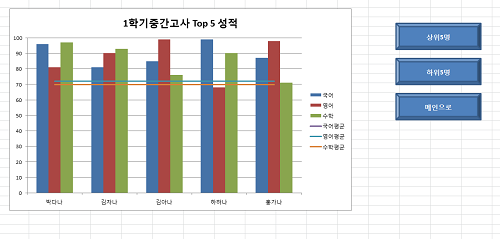

위 그림은 Jupyter Notebook의 기본 구조를 보여줍니다. 마크다운 셀과 코드 셀이 번갈아 나타나는 것을 볼 수 있죠. 이러한 구조는 데이터 분석 과정을 단계별로 명확하게 설명하고 실행할 수 있게 해줍니다.

1.3 Jupyter Notebook의 장점

Jupyter Notebook은 데이터 사이언스 분야에서 널리 사용되는 이유가 있습니다. 주요 장점들을 살펴보겠습니다:

- 즉각적인 피드백: 코드를 실행하고 즉시 결과를 확인할 수 있어 빠른 실험과 디버깅이 가능합니다.

- 시각화 용이성: 그래프, 차트 등을 쉽게 생성하고 바로 확인할 수 있습니다.

- 공유와 협업: 노트북 파일(.ipynb)을 쉽게 공유하고 협업할 수 있습니다.

- 재현 가능한 연구: 코드와 결과, 설명이 한 곳에 있어 연구 재현성을 높일 수 있습니다.

- 교육 도구로서의 가치: 단계별 학습과 실습을 위한 훌륭한 도구입니다.

이러한 장점들 덕분에 Jupyter Notebook은 데이터 분석, 머신러닝, 과학 연구 등 다양한 분야에서 필수 도구로 자리잡았습니다. 마치 재능넷에서 다양한 재능이 만나 시너지를 내듯, Jupyter Notebook에서는 코드, 설명, 시각화가 만나 강력한 분석 도구를 만들어냅니다.

1.4 Jupyter Notebook 설치하기

Jupyter Notebook을 사용하기 위해서는 먼저 설치가 필요합니다. 설치 과정은 다음과 같습니다:

- Python 설치: Jupyter는 Python 기반이므로, 먼저 Python을 설치해야 합니다.

- pip 사용: Python의 패키지 관리자인 pip를 사용해 Jupyter를 설치합니다.

- 명령어 실행: 터미널이나 명령 프롬프트에서 다음 명령어를 실행합니다.

pip install jupyter설치가 완료되면, 다음 명령어로 Jupyter Notebook을 실행할 수 있습니다:

jupyter notebook이 명령어를 실행하면 기본 웹 브라우저에서 Jupyter Notebook 인터페이스가 열립니다.

1.5 Jupyter Notebook 인터페이스 살펴보기

Jupyter Notebook을 실행하면 다음과 같은 인터페이스를 만나게 됩니다:

주요 구성 요소는 다음과 같습니다:

- 메뉴 바: 파일 생성, 열기, 저장 등의 기본 기능을 제공합니다.

- 툴바: 셀 실행, 중지, 재시작 등의 기능을 빠르게 접근할 수 있습니다.

- 노트북 영역: 실제 코드와 마크다운을 작성하고 결과를 확인하는 공간입니다.

이러한 직관적인 인터페이스 덕분에 사용자들은 복잡한 설정 없이도 바로 데이터 분석 작업을 시작할 수 있습니다. 마치 재능넷에서 다양한 재능을 쉽게 찾고 활용할 수 있듯이, Jupyter Notebook에서도 필요한 기능을 쉽게 찾아 사용할 수 있죠.

다음 섹션에서는 Jupyter Notebook을 실제로 어떻게 사용하는지, 그리고 데이터 분석에 어떻게 활용할 수 있는지 더 자세히 알아보겠습니다. 🚀

2. Jupyter Notebook 활용하기 🛠️

Jupyter Notebook의 기본적인 사용법을 익혔다면, 이제 실제 데이터 분석 작업에 어떻게 활용할 수 있는지 알아보겠습니다. 이 섹션에서는 Jupyter Notebook을 사용한 데이터 분석의 전체 과정을 단계별로 살펴볼 것입니다.

2.1 데이터 불러오기

데이터 분석의 첫 단계는 데이터를 불러오는 것입니다. Jupyter Notebook에서는 다양한 형식의 데이터를 쉽게 불러올 수 있습니다.

import pandas as pd

# CSV 파일 불러오기

df = pd.read_csv('data.csv')

# 엑셀 파일 불러오기

df_excel = pd.read_excel('data.xlsx')

# JSON 파일 불러오기

df_json = pd.read_json('data.json')

# 데이터 미리보기

print(df.head())

위 코드는 pandas 라이브러리를 사용해 CSV, Excel, JSON 형식의 데이터를 불러오는 방법을 보여줍니다. head() 함수를 사용하면 데이터의 처음 몇 행을 미리 볼 수 있어, 데이터 구조를 빠르게 파악할 수 있습니다.

2.2 데이터 전처리

데이터를 불러왔다면, 다음은 데이터 전처리 단계입니다. 이 단계에서는 결측치 처리, 이상치 제거, 데이터 타입 변환 등의 작업을 수행합니다.

# 결측치 확인

print(df.isnull().sum())

# 결측치 제거

df_clean = df.dropna()

# 특정 열의 데이터 타입 변환

df['date'] = pd.to_datetime(df['date'])

# 이상치 제거 (예: z-score 방법)

from scipy import stats

df_clean = df[(np.abs(stats.zscore(df['column_name'])) < 3)]

이러한 전처리 과정은 데이터의 품질을 높이고, 이후의 분석 과정에서 오류를 줄이는 데 중요합니다.

2.3 데이터 탐색적 분석 (EDA)

전처리된 데이터를 바탕으로 탐색적 데이터 분석을 수행합니다. 이 단계에서는 데이터의 기본 통계량을 확인하고, 다양한 시각화 기법을 활용합니다.

import matplotlib.pyplot as plt

import seaborn as sns

# 기본 통계량 확인

print(df.describe())

# 히스토그램 그리기

plt.figure(figsize=(10, 6))

df['column_name'].hist()

plt.title('Histogram of Column Name')

plt.show()

# 상관관계 히트맵

plt.figure(figsize=(12, 10))

sns.heatmap(df.corr(), annot=True, cmap='coolwarm')

plt.title('Correlation Heatmap')

plt.show()

이러한 EDA 과정을 통해 데이터의 분포, 변수 간의 관계, 이상치 등을 시각적으로 파악할 수 있습니다.

위의 그래프는 데이터 시각화의 한 예시를 보여줍니다. 실제 분석에서는 이보다 더 복잡하고 다양한 그래프를 사용하여 데이터의 특성을 파악합니다.

2.4 데이터 모델링

EDA를 통해 데이터의 특성을 파악했다면, 이제 실제 모델을 만들고 학습시킬 차례입니다. Jupyter Notebook에서는 scikit-learn, TensorFlow 등의 라이브러리를 사용해 다양한 머신러닝, 딥러닝 모델을 구현할 수 있습니다.

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error, r2_score

# 데이터 분할

X = df[['feature1', 'feature2', 'feature3']]

y = df['target']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 모델 학습

model = LinearRegression()

model.fit(X_train, y_train)

# 예측 및 평가

y_pred = model.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

r2 = r2_score(y_test, y_pred)

print(f'Mean Squared Error: {mse}')

print(f'R-squared Score: {r2}')

이 예시에서는 간단한 선형 회귀 모델을 구현했지만, 실제로는 문제의 특성에 따라 다양한 모델을 시도하고 비교하는 과정이 필요합니다.

2.5 결과 해석 및 보고서 작성

모델링 결과를 얻었다면, 이를 해석하고 보고서로 정리하는 단계가 필요합니다. Jupyter Notebook의 마크다운 기능을 활용하면 코드, 결과, 해석을 한 문서에 깔끔하게 정리할 수 있습니다.

# 마크다운 셀

## 분석 결과 요약

우리의 선형 회귀 모델은 다음과 같은 성능을 보였습니다:

- Mean Squared Error: {mse}

- R-squared Score: {r2}

이 결과는 모델이 데이터의 {r2*100}%를 설명할 수 있음을 의미합니다.

주요 특성의 중요도는 다음과 같습니다:

1. Feature1: {model.coef_[0]}

2. Feature2: {model.coef_[1]}

3. Feature3: {model.coef_[2]}

향후 개선 방향:

1. 더 많은 데이터 수집

2. 비선형 관계 탐색

3. 다른 알고리즘 시도 (예: Random Forest, Gradient Boosting)

이러한 방식으로 분석 과정과 결과를 체계적으로 정리할 수 있습니다. 마치 재능넷에서 프로젝트의 진행 상황을 명확하게 보고하듯이, Jupyter Notebook을 통해 데이터 분석 프로젝트의 전 과정을 투명하고 이해하기 쉽게 문서화할 수 있습니다.

2.6 협업과 공유

Jupyter Notebook의 또 다른 강점은 쉬운 공유와 협업 기능입니다. .ipynb 파일을 동료와 공유하거나, GitHub 같은 플랫폼에 업로드하여 버전 관리를 할 수 있습니다.

또한, JupyterHub나 Google Colab과 같은 플랫폼을 활용하면 클라우드 환경에서 실시간으로 협업할 수도 있습니다. 이는 마치 재능넷에서 다양한 전문가들이 온라인에서 만나 협업하는 것과 유사한 경험을 제공합니다.

2.7 고급 기능 활용

Jupyter Notebook은 기본 기능 외에도 다양한 고급 기능과 확장 프로그램을 제공합니다:

- 매직 명령어:

%timeit,%matplotlib inline등의 특별한 명령어로 작업 효율을 높일 수 있습니다. - 위젯: 대화형 UI 요소를 추가하여 사용자 입력을 받거나 동적 시각화를 구현할 수 있습니다.

- 확장 프로그램: 코드 자동 완성, 목차 생성 등 다양한 기능을 추가할 수 있습니다.

# 매직 명령어 예시

%timeit sum(range(1000000))

# 위젯 사용 예시

from ipywidgets import interact

import matplotlib.pyplot as plt

@interact(n=(10, 100))

def plot_squares(n):

plt.plot(range(n), [i**2 for i in range(n)])

plt.title(f'Square numbers up to {n}')

plt.show()

이러한 고급 기능들을 활용하면 더욱 효율적이고 인터랙티브한 데이터 분석 환경을 구축할 수 있습니다.

Jupyter Notebook을 활용한 데이터 분석은 단순히 코드를 실행하는 것 이상의 의미를 가집니다. 데이터 탐색부터 결과 해석까지의 전 과정을 하나의 문서에 담아 스토리텔링 형식으로 구성할 수 있어, 분석 과정의 투명성과 재현성을 높일 수 있습니다.

다음 섹션에서는 Jupyter Notebook의 클라우드 버전이라고 할 수 있는 Google Colab에 대해 알아보겠습니다. Google Colab은 Jupyter Notebook의 장점을 그대로 가져가면서도, 클라우드 환경의 이점을 추가로 제공합니다. 🚀

3. Google Colab 소개 🌐

Google Colab(Colaboratory의 줄임말)은 구글이 제공하는 클라우드 기반의 Jupyter Notebook 환경입니다. 데이터 과학자, 머신러닝 엔지니어, 학생들 사이에서 빠르게 인기를 얻고 있는 이 플랫폼은 Jupyter Notebook의 모든 장점을 가지면서도 추가적인 이점을 제공합니다.

3.1 Google Colab의 특징

Google Colab은 다음과 같은 주요 특징을 가지고 있습니다:

- 무료 클라우드 서비스: 별도의 설치 없이 웹 브라우저에서 바로 사용할 수 있습니다.

- GPU 및 TPU 지원: 무료로 고성능 컴퓨팅 리소스를 사용할 수 있어 딥러닝 모델 학습에 적합합니다.

- 구글 드라이브 연동: 구글 드라이브와 쉽게 연동되어 데이터 저장 및 공유가 용이합니다.

- 협업 기능: 실시간으로 여러 사용자가 동시에 작업할 수 있습니다.

- 사전 설치된 라이브러리: 데이터 과학, 머신러닝에 필요한 주요 라이브러리가 미리 설치되어 있습니다.

3.2 Google Colab 시작하기

Google Colab을 시작하는 방법은 매우 간단합니다:

- Google 계정으로 로그인합니다.

- 브라우저에서 https://colab.research.google.com에 접속합니다.

- '새 노트' 버튼을 클릭하여 새로운 노트북을 생성합니다.

이렇게 간단한 과정만으로 바로 코딩을 시작할 수 있습니다. 마치 재능넷에서 클릭 몇 번으로 원하는 서비스를 찾을 수 있는 것처럼, Google Colab도 사용자 친화적인 인터페이스를 제공합니다.

위 그림은 Google Colab의 기본 인터페이스를 간단히 표현한 것입니다. 코드 셀과 텍스트 셀이 번갈아 나타나며, 오른쪽 상단의 색깔 원은 각각 RAM, 디스크, GPU 사용량을 나타냅니다.

3.3 Google Colab의 주요 기능

Google Colab은 Jupyter Notebook의 기능을 대부분 지원하면서도, 몇 가지 특별한 기능을 추가로 제공합니다:

3.3.1 하드웨어 가속기 사용

Google Colab에서는 무료로 GPU와 TPU를 사용할 수 있습니다. 이는 딥러닝 모델 학습 시 큰 장점이 됩니다.

# GPU 사용 설정

!nvidia-smi

# TPU 사용 설정

import os

os.environ['COLAB_TPU_ADDR'] = 'grpc://' + os.environ['COLAB_TPU_ADDR']

import tensorflow as tf

print(tf.config.list_physical_devices('TPU'))

3.3.2 구글 드라이브 연동

구글 드라이브와 쉽게 연동하여 데이터를 불러오거나 저장할 수 있습니다.

from google.colab import drive

drive.mount('/content/drive')

# 구글 드라이브의 파일 읽기

import pandas as pd

df = pd.read_csv('/content/drive/My Drive/data.csv')

3.3.3 GitHub 연동

GitHub 저장소의 코드를 직접 Colab으로 불러와 실행할 수 있습니다.

!git clone https://github.com/username/repository.git

3.3.4 패키지 설치

필요한 패키지를 쉽게 설치할 수 있습니다.

!pip install package_name

3.4 Google Colab vs Jupyter Notebook

Google Colab과 Jupyter Notebook은 많은 공통점을 가지고 있지만, 몇 가지 중요한 차이점도 있습니다:

| 특징 | Google Colab | Jupyter Notebook |

|---|---|---|

| 설치 | 불필요 (웹 기반) | 로컬 설치 필요 |

| 하드웨어 자원 | 무료 GPU/TPU 제공 | 로컬 하드웨어 사용 |

| 저장 및 공유 | 구글 드라이브 연동, 쉬운 공유 | 로컬 저장, 수동 공유 |

| 사용자 정의 | 제한적 | 높은 자유도 |

3.5 Google Colab 활용 팁

Google Colab을 더욱 효과적으로 사용하기 위한 몇 가지 팁을 소개합니다:

- 세션 연결 유지: Colab은 일정 시간 동안 활동이 없으면 연결이 끊깁니다. 이를 방지하기 위해 브라우저 콘솔에서 다음 코드를 실행할 수 있습니다:

function ClickConnect(){ console.log("Working"); document.querySelector("colab-connect-button").click() } setInterval(ClickConnect,60000) - 커스텀 라이브러리 사용: 필요한 라이브러리를 매번 설치하지 않고, 시작 시 자동으로 설치되도록 설정할 수 있습니다.

- 데이터 캐싱: 대용량 데이터를 반복적으로 불러올 때는 캐싱을 활용하여 속도를 높일 수 있습니다.

- 버전 관리: GitHub와 연동하여 코드의 버전 관리를 할 수 있습니다.

3.6 Google Colab의 한계

Google Colab의 장점이 많지만, 몇 가지 한계점도 있습니다:

- 세션 시간 제한: 무료 버전의 경우 세션 시간에 제한이 있어 장시간 실행되는 작업에는 적합하지 않을 수 있습니다.

- 불안정한 연결: 인터넷 연결이 불안정할 경우 작업이 중단될 수 있습니다.

- 데이터 보안: 중요한 데이터를 다룰 때는 보안에 주의해야 합니다.

- 사용자 정의의 한계: 로컬 환경에 비해 사용자 정의 옵션이 제한적입니다.

이러한 한계점에도 불구하고, Google Colab은 특히 학습과 가벼운 프로젝트에 매우 유용한 도구입니다. 마치 재능넷에서 다양한 서비스를 쉽게 이용할 수 있듯이, Google Colab을 통해 누구나 쉽게 데이터 과학과 머신러닝을 경험할 수 있습니다.

3.7 실제 사용 사례

Google Colab은 다양한 분야에서 활용되고 있습니다. 몇 가지 실제 사용 사례를 살펴보겠습니다:

- 이미지 분류 모델 학습: GPU를 활용하여 대규모 이미지 데이터셋으로 딥러닝 모델을 학습시킬 수 있습니다.

- 자연어 처리: BERT, GPT 등의 대규모 언어 모델을 fine-tuning하거나 테스트할 수 있습니다.

- 데이터 시각화: 대용량 데이터셋을 불러와 Matplotlib, Seaborn, Plotly 등을 사용해 다양한 시각화를 수행할 수 있습니다.

- 협업 프로젝트: 팀원들과 실시간으로 코드를 공유하고 수정하며 프로젝트를 진행할 수 있습니다.

이처럼 Google Colab은 데이터 과학과 머신러닝 분야에서 강력한 도구로 자리잡고 있습니다. 무료로 제공되는 고성능 컴퓨팅 자원과 사용자 친화적인 인터페이스 덕분에, 전문가부터 초보자까지 폭넓게 활용되고 있습니다.

다음 섹션에서는 Jupyter Notebook과 Google Colab을 실제 데이터 분석 프로젝트에 어떻게 적용할 수 있는지, 구체적인 예시를 통해 살펴보겠습니다. 이를 통해 이 도구들이 어떻게 데이터 과학 워크플로우를 개선하고 효율성을 높이는지 더 자세히 이해할 수 있을 것입니다. 🚀

4. 실제 프로젝트 적용 예시 🛠️

이제 Jupyter Notebook과 Google Colab을 실제 데이터 분석 프로젝트에 어떻게 적용할 수 있는지 구체적인 예시를 통해 알아보겠습니다. 이 예시에서는 가상의 전자상거래 데이터를 사용하여 고객 세그먼테이션을 수행하는 과정을 단계별로 살펴볼 것입니다.

4.1 프로젝트 개요

목표: 고객 구매 데이터를 분석하여 고객을 여러 세그먼트로 나누고, 각 세그먼트의 특성을 파악합니다.

사용 도구: Google Colab (GPU 런타임 사용)

주요 단계:

- 데이터 로드 및 전처리

- 탐색적 데이터 분석 (EDA)

- 특성 엔지니어링

- 고객 세그먼테이션 모델링 (K-means 클러스터링)

- 결과 시각화 및 해석

4.2 프로젝트 구현

4.2.1 필요한 라이브러리 임포트 및 데이터 로드

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

from sklearn.preprocessing import StandardScaler

from sklearn.cluster import KMeans

from google.colab import drive

# Google Drive 마운트

drive.mount('/content/drive')

# 데이터 로드

df = pd.read_csv('/content/drive/My Drive/ecommerce_data.csv')

print(df.head())

4.2.2 데이터 전처리

# 결측치 확인 및 처리

print(df.isnull().sum())

df = df.dropna()

# 중복 제거

df = df.drop_duplicates()

# 이상치 처리

Q1 = df['Purchase_Amount'].quantile(0.25)

Q3 = df['Purchase_Amount'].quantile(0.75)

IQR = Q3 - Q1

df = df[(df['Purchase_Amount'] >= (Q1 - 1.5 * IQR)) & (df['Purchase_Amount'] <= (Q3 + 1.5 * IQR))]

4.2.3 탐색적 데이터 분석 (EDA)

# 기술 통계량 확인

print(df.describe())

# 상관관계 분석

plt.figure(figsize=(10, 8))

sns.heatmap(df.corr(), annot=True, cmap='coolwarm')

plt.title('Correlation Heatmap')

plt.show()

# 구매 금액 분포

plt.figure(figsize=(10, 6))

sns.histplot(df['Purchase_Amount'], kde=True)

plt.title('Distribution of Purchase Amount')

plt.show()

4.2.4 특성 엔지니어링

# RFM (Recency, Frequency, Monetary) 분석을 위한 특성 생성

df['Recency'] = (pd.to_datetime('2023-06-01') - pd.to_datetime(df['Last_Purchase_Date'])).dt.days

df['Frequency'] = df['Purchase_Frequency']

df['Monetary'] = df['Purchase_Amount']

# 특성 스케일링

scaler = StandardScaler()

rfm_scaled = scaler.fit_transform(df[['Recency', 'Frequency', 'Monetary']])

4.2.5 고객 세그먼테이션 모델링

# K-means 클러스터링

kmeans = KMeans(n_clusters=4, random_state=42)

df['Cluster'] = kmeans.fit_predict(rfm_scaled)

# 클러스터 중심점 확인

cluster_centers = scaler.inverse_transform(kmeans.cluster_centers_)

cluster_centers_df = pd.DataFrame(cluster_centers, columns=['Recency', 'Frequency', 'Monetary'])

print(cluster_centers_df)

4.2.6 결과 시각화 및 해석

# 3D 산점도로 클러스터 시각화

from mpl_toolkits.mplot3d import Axes3D

fig = plt.figure(figsize=(10, 8))

ax = fig.add_subplot(111, projection='3d')

scatter = ax.scatter(df['Recency'], df['Frequency'], df['Monetary'], c=df['Cluster'], cmap='viridis')

ax.set_xlabel('Recency')

ax.set_ylabel('Frequency')

ax.set_zlabel('Monetary')

plt.title('Customer Segments')

plt.colorbar(scatter)

plt.show()

# 클러스터별 특성 분석

for i in range(4):

print(f"\nCluster {i} characteristics:")

print(df[df['Cluster'] == i][['Recency', 'Frequency', 'Monetary']].describe())

4.3 결과 해석

이 프로젝트를 통해 우리는 고객을 4개의 세그먼트로 나누었습니다. 각 세그먼트의 특성을 간단히 해석해보면:

- 세그먼트 0: 최근에 구매했지만 구매 빈도와 금액이 낮은 고객들 (신규 고객)

- 세그먼트 1: 구매 빈도는 높지만 최근성이 떨어지는 고객들 (이탈 위험 고객)

- 세그먼트 2: 구매 빈도와 금액이 높고 최근에도 구매한 고객들 (VIP 고객)

- 세그먼트 3: 구매 빈도와 금액이 낮고 최근성도 떨어지는 고객들 (비활성 고객)

이러한 세그먼테이션 결과를 바탕으로, 마케팅 팀은 각 세그먼트에 맞는 전략을 수립할 수 있습니다. 예를 들어, 세그먼트 1의 고객들에게는 재구매를 유도하는 프로모션을, 세그먼트 2의 고객들에게는 VIP 혜택을 제공하는 등의 전략을 세울 수 있습니다.

4.4 프로젝트 회고

이 프로젝트를 통해 우리는 Google Colab의 강력한 기능을 활용하여 복잡한 데이터 분석 작업을 수행했습니다. GPU 런타임을 사용함으로써 대용량 데이터에 대한 클러스터링 작업을 빠르게 처리할 수 있었고, 구글 드라이브와의 연동을 통해 데이터를 쉽게 불러올 수 있었습니다.

Jupyter Notebook 스타일의 대화형 환경은 데이터 탐색과 시각화를 단계별로 수행하고 즉시 결과를 확인할 수 있게 해주어, 분석 과정을 더욱 효율적으로 만들었습니다. 또한, 마크다운 셀을 활용하여 각 단계의 설명을 추가함으로써, 프로젝트의 흐름을 명확히 문서화할 수 있었습니다.

이러한 방식의 데이터 분석은 마치 재능넷에서 다양한 전문가들이 각자의 재능을 모아 하나의 프로젝트를 완성하는 것과 유사합니다. 데이터 로딩, 전처리, 시각화, 모델링 등 각 단계가 유기적으로 연결되어 최종 결과물을 만들어내는 과정이 바로 그것입니다.

이 프로젝트는 Jupyter Notebook과 Google Colab이 어떻게 실제 비즈니스 문제 해결에 적용될 수 있는지를 보여주는 좋은 예시가 됩니다. 이러한 도구들은 데이터 사이언티스트들이 더 빠르고 효율적으로 인사이트를 도출하고, 그 결과를 팀원들과 쉽게 공유할 수 있게 해줍니다.

다음 섹션에서는 Jupyter Notebook과 Google Colab을 사용할 때의 best practices와 주의해야 할 점들에 대해 알아보겠습니다. 이를 통해 여러분은 이 강력한 도구들을 더욱 효과적으로 활용할 수 있을 것입니다. 🚀

5. Best Practices 및 주의사항 🛡️

Jupyter Notebook과 Google Colab은 강력한 도구이지만, 효과적으로 사용하기 위해서는 몇 가지 best practices와 주의사항을 알아둘 필요가 있습니다. 이 섹션에서는 이러한 팁들을 자세히 살펴보겠습니다.

5.1 코드 구조화 및 모듈화

노트북 환경에서도 코드의 구조화와 모듈화는 중요합니다:

- 함수 사용: 반복되는 코드는 함수로 만들어 재사용성을 높입니다.

- 클래스 활용: 관련 기능을 클래스로 묶어 객체지향적 설계를 합니다.

- 모듈 분리: 큰 프로젝트의 경우, 기능별로 모듈을 분리하고 임포트하여 사용합니다.

# 좋은 예시

def preprocess_data(df):

df = df.dropna()

df = df.drop_duplicates()

# 더 많은 전처리 단계...

return df

preprocessed_df = preprocess_data(df)

5.2 메모리 관리

특히 대용량 데이터를 다룰 때 메모리 관리는 중요합니다:

- 불필요한 변수 삭제: del 키워드를 사용하여 더 이상 필요없는 대용량 변수를 삭제합니다.

- 제너레이터 활용: 대용량 데이터를 한 번에 메모리에 로드하지 않고, 제너레이터를 사용하여 필요할 때마다 로드합니다.

- 데이터 타입 최적화: 가능한 경우 더 작은 데이터 타입을 사용합니다 (예: float64 대신 float32).

# 메모리 사용량 확인

import psutil

print(f"Memory Usage: {psutil.virtual_memory().percent}%")

# 불필요한 변수 삭제

del large_dataframe

5.3 버전 관리

노트북 환경에서도 버전 관리는 중요합니다:

- Git 사용: 노트북 파일도 Git으로 버전 관리를 할 수 있습니다.

- 명확한 커밋 메시지: 각 변경사항에 대해 명확한 커밋 메시지를 작성합니다.

- nbdime 활용: Jupyter Notebook 전용 diff 도구인 nbdime을 사용하여 변경사항을 효과적으로 관리합니다.

5.4 재현 가능성 확보

분석 결과의 재현 가능성을 높이기 위해:

- 랜덤 시드 고정: 랜덤성이 있는 작업의 경우 시드를 고정합니다.

- 환경 정보 기록: 사용한 라이브러리의 버전 정보를 기록합니다.

- 데이터 버전 관리: 사용한 데이터의 버전을 명확히 기록합니다.

import numpy as np

import tensorflow as tf

# 랜덤 시드 고정

np.random.seed(42)

tf.random.set_seed(42)

# 환경 정보 기록

!pip freeze > requirements.txt

5.5 보안 주의사항

특히 Google Colab을 사용할 때는 보안에 주의해야 합니다:

- 민감한 정보 보호: API 키, 비밀번호 등을 노트북에 직접 입력하지 않습니다.

- 환경 변수 사용: 민감한 정보는 환경 변수로 관리합니다.

- 공유 시 주의: 노트북을 공유할 때 민감한 정보가 포함되지 않았는지 확인합니다.

import os

# 환경 변수에서 API 키 가져오기

api_key = os.environ.get('MY_API_KEY')

5.6 효율적인 리소스 사용

특히 Google Colab의 무료 리소스를 효율적으로 사용하기 위해:

- 세션 연결 유지: 장시간 실행되는 작업의 경우 세션 연결이 끊기지 않도록 주의합니다.

- GPU 사용 최적화: GPU가 필요한 작업에만 GPU를 할당합니다.

- 리소스 모니터링: 주기적으로 리소스 사용량을 체크합니다.

# GPU 사용 가능 여부 확인

import tensorflow as tf

print("GPU Available: ", tf.test.is_gpu_available())

# 리소스 사용량 모니터링

!nvidia-smi

5.7 문서화 및 주석

코드의 가독성과 유지보수성을 높이기 위해:

- 마크다운 활용: 각 섹션의 목적과 주요 단계를 마크다운 셀로 설명합니다.

- 적절한 주석: 복잡한 코드나 중요한 로직에는 주석을 추가합니다.

- 결과 해석 추가: 분석 결과에 대한 해석을 추가하여 인사이트를 명확히 합니다.

# 마크다운 셀

## 데이터 전처리

이 섹션에서는 결측치 처리, 이상치 제거, 특성 스케일링을 수행합니다.

# 코드 셀

# 결측치 처리

df = df.dropna()

# 이상치 제거 (IQR 방법 사용)

Q1 = df['column'].quantile(0.25)

Q3 = df['column'].quantile(0.75)

IQR = Q3 - Q1

df = df[(df['column'] >= (Q1 - 1.5 * IQR)) & (df['column'] <= (Q3 + 1.5 * IQR))]

# 특성 스케일링

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

df_scaled = scaler.fit_transform(df)

# 마크다운 셀

## 결과 해석

스케일링 후 데이터의 분포가 정규화되었음을 확인할 수 있습니다. 이는 후속 모델링 단계에서 각 특성의 영향력을 균등하게 만들어줄 것입니다.

5.8 협업 시 주의사항

팀 프로젝트에서 Jupyter Notebook이나 Google Colab을 사용할 때:

- 명확한 네이

- 명확한 네이밍 규칙: 변수, 함수, 클래스 등에 일관된 네이밍 규칙을 적용합니다.

- 작업 분담: 큰 노트북을 여러 개의 작은 노트북으로 나누어 작업을 분담합니다.

- 코드 리뷰: 정기적으로 팀원들과 코드 리뷰를 진행합니다.

- 문서화: 프로젝트의 전체 구조와 각 노트북의 역할을 명확히 문서화합니다.

5.9 성능 최적화

대규모 데이터셋을 다룰 때 성능 최적화는 중요합니다:

- 벡터화 연산: 가능한 경우 for 루프 대신 벡터화된 연산을 사용합니다.

- 캐싱: 반복적으로 사용되는 계산 결과는 캐싱하여 재사용합니다.

- 병렬 처리: 멀티프로세싱을 활용하여 병렬 처리를 구현합니다.

import numpy as np

from functools import lru_cache

# 벡터화 연산 예시

def vector_operation(x):

return np.sum(x ** 2)

# 캐싱 예시

@lru_cache(maxsize=None)

def expensive_computation(x):

# 복잡한 계산...

return result

# 병렬 처리 예시

from multiprocessing import Pool

def process_chunk(chunk):

# 데이터 처리 로직...

return result

with Pool() as p:

results = p.map(process_chunk, data_chunks)

5.10 에러 처리 및 디버깅

노트북 환경에서의 효과적인 에러 처리와 디버깅을 위해:

- 예외 처리: 적절한 try-except 구문을 사용하여 예외를 처리합니다.

- 로깅: 중요한 단계마다 로그를 남겨 디버깅을 용이하게 합니다.

- 단위 테스트: 주요 함수에 대한 단위 테스트를 작성합니다.

import logging

# 로깅 설정

logging.basicConfig(level=logging.INFO)

try:

# 복잡한 연산 수행

result = complex_operation()

logging.info(f"Operation completed. Result: {result}")

except Exception as e:

logging.error(f"An error occurred: {str(e)}")

# 단위 테스트 예시

import unittest

class TestDataProcessing(unittest.TestCase):

def test_preprocess_data(self):

input_data = pd.DataFrame({'A': [1, 2, None, 4]})

expected_output = pd.DataFrame({'A': [1, 2, 4]})

self.assertTrue(preprocess_data(input_data).equals(expected_output))

if __name__ == '__main__':

unittest.main()

5.11 확장성 고려

프로젝트가 성장함에 따라 확장성을 고려해야 합니다:

- 모듈화: 기능별로 코드를 모듈화하여 재사용성을 높입니다.

- 설정 파일 사용: 하드코딩된 값 대신 설정 파일을 사용합니다.

- 스케일아웃 고려: 대규모 데이터 처리를 위해 분산 처리 방식을 고려합니다.

# config.yaml

data_path: '/path/to/data'

model_params:

n_estimators: 100

max_depth: 5

# Python 코드

import yaml

with open('config.yaml', 'r') as file:

config = yaml.safe_load(file)

data = load_data(config['data_path'])

model = train_model(data, **config['model_params'])

5.12 지속적인 학습과 개선

데이터 과학 분야는 빠르게 발전하고 있으므로, 지속적인 학습과 개선이 필요합니다:

- 최신 트렌드 파악: 새로운 라이브러리, 기술, 방법론을 지속적으로 학습합니다.

- 커뮤니티 참여: 데이터 과학 커뮤니티에 참여하여 지식을 공유하고 습득합니다.

- 프로젝트 회고: 각 프로젝트 완료 후 회고를 통해 개선점을 파악합니다.

이러한 best practices와 주의사항들을 염두에 두고 Jupyter Notebook과 Google Colab을 사용한다면, 여러분은 더욱 효율적이고 효과적으로 데이터 분석 프로젝트를 수행할 수 있을 것입니다. 마치 재능넷에서 다양한 전문가들의 조언을 종합하여 최상의 결과를 얻는 것처럼, 이러한 practices를 통해 여러분의 데이터 사이언스 프로젝트도 한 단계 더 발전할 수 있을 것입니다.

다음 섹션에서는 Jupyter Notebook과 Google Colab의 미래 전망과 발전 방향에 대해 살펴보겠습니다. 데이터 과학 분야의 빠른 발전 속에서 이 도구들이 어떻게 진화해 나갈지, 그리고 우리는 어떻게 대비해야 할지에 대해 논의해 보겠습니다. 🚀

6. 미래 전망 및 발전 방향 🔮

Jupyter Notebook과 Google Colab은 데이터 과학 분야에서 이미 중요한 위치를 차지하고 있지만, 기술의 발전과 사용자 요구의 변화에 따라 계속해서 진화하고 있습니다. 이 섹션에서는 이러한 도구들의 미래 전망과 발전 방향에 대해 살펴보겠습니다.

6.1 클라우드 네이티브 환경으로의 전환

클라우드 컴퓨팅의 발전과 함께, Jupyter Notebook과 Google Colab도 더욱 클라우드 네이티브한 환경으로 발전할 것으로 예상됩니다:

- 서버리스 아키텍처: 사용자가 인프라를 관리할 필요 없이 코드 실행에만 집중할 수 있는 환경이 제공될 것입니다.

- 자동 스케일링: 작업 부하에 따라 자동으로 리소스를 조절하는 기능이 강화될 것입니다.

- 글로벌 협업: 전 세계 어디서나 실시간으로 협업할 수 있는 기능이 더욱 발전할 것입니다.

6.2 인공지능과의 통합

인공지능 기술의 발전은 Jupyter Notebook과 Google Colab에도 큰 영향을 미칠 것입니다:

- AI 기반 코드 제안: 사용자의 코딩 패턴을 학습하여 적절한 코드를 제안하는 기능이 강화될 것입니다.

- 자동화된 데이터 분석: 기초적인 데이터 분석과 시각화를 AI가 자동으로 수행하는 기능이 추가될 수 있습니다.

- 자연어 처리 기반 인터페이스: 자연어로 명령을 내리면 AI가 이를 해석하여 코드로 변환하는 기능이 개발될 수 있습니다.

6.3 확장된 시각화 및 대화형 기능

데이터 시각화와 대화형 기능은 더욱 강화될 것으로 예상됩니다:

- 3D 및 VR/AR 시각화: 복잡한 데이터를 3D나 VR/AR 환경에서 시각화하는 기능이 추가될 수 있습니다.

- 실시간 협업 시각화: 여러 사용자가 동시에 같은 시각화를 조작하고 분석할 수 있는 기능이 발전할 것입니다.

- 고급 대화형 위젯: 더욱 복잡하고 세밀한 조작이 가능한 대화형 위젯이 개발될 것입니다.

6.4 보안 및 규정 준수 강화

데이터의 중요성이 커짐에 따라 보안과 규정 준수에 대한 요구도 높아질 것입니다:

- 엔드-투-엔드 암호화: 노트북의 내용과 데이터를 완전히 암호화하는 기능이 표준이 될 수 있습니다.

- 세밀한 접근 제어: 노트북의 특정 셀이나 데이터에 대한 접근 권한을 더욱 세밀하게 제어할 수 있게 될 것입니다.

- 규정 준수 자동화: GDPR, CCPA 등 데이터 관련 규정을 자동으로 준수할 수 있도록 지원하는 기능이 추가될 수 있습니다.

6.5 확장된 하드웨어 지원

다양한 하드웨어에 대한 지원이 확대될 것으로 예상됩니다:

- 양자 컴퓨팅 지원: 양자 컴퓨팅 알고리즘을 실행하고 시뮬레이션할 수 있는 환경이 제공될 수 있습니다.

- 엣지 컴퓨팅 통합: IoT 디바이스나 엣지 서버와 직접 연동하여 데이터를 처리하고 분석할 수 있는 기능이 추가될 수 있습니다.

- 특수 목적 가속기 지원: AI 가속기 등 특수 목적의 하드웨어를 더욱 효과적으로 활용할 수 있는 기능이 개발될 것입니다.

6.6 교육 및 학습 도구로서의 발전

Jupyter Notebook과 Google Colab은 교육 분야에서도 더욱 중요한 역할을 할 것으로 예상됩니다:

- 대화형 학습 경로: 사용자의 수준과 관심사에 따라 맞춤형 학습 경로를 제공하는 기능이 개발될 수 있습니다.

- 실시간 피드백: 학습자의 코드를 실시간으로 분석하여 개선점을 제안하는 기능이 강화될 것입니다.

- 가상 실습 환경: 복잡한 데이터 과학 프로젝트를 안전하게 실습할 수 있는 가상 환경이 제공될 수 있습니다.

6.7 생태계 확장

Jupyter Notebook과 Google Colab을 중심으로 한 생태계가 더욱 확장될 것으로 예상됩니다:

- 서드파티 통합 강화: 더 많은 외부 서비스와 도구들이 쉽게 통합될 수 있는 환경이 제공될 것입니다.

- 마켓플레이스 발전: 사용자들이 만든 노트북, 확장 프로그램, 데이터셋 등을 쉽게 공유하고 거래할 수 있는 마켓플레이스가 발전할 수 있습니다.

- 산업별 특화 솔루션: 금융, 의료, 제조 등 특정 산업에 특화된 노트북 템플릿과 도구들이 개발될 것입니다.

6.8 윤리적 AI 개발 지원

AI 윤리에 대한 관심이 높아짐에 따라, 이를 지원하는 기능들이 추가될 수 있습니다:

- 편향성 검사 도구: 데이터셋이나 모델의 편향성을 자동으로 검사하고 보고하는 기능이 추가될 수 있습니다.

- 설명 가능한 AI 지원: 복잡한 모델의 결정 과정을 시각화하고 설명하는 도구가 통합될 수 있습니다.

- 윤리적 가이드라인 체크리스트: AI 프로젝트의 윤리적 측면을 체크하고 가이드하는 기능이 제공될 수 있습니다.

6.9 사용자 경험의 혁신

사용자 경험 측면에서도 큰 혁신이 있을 것으로 예상됩니다:

- 음성 인터페이스: 음성 명령으로 코드를 작성하고 실행할 수 있는 기능이 추가될 수 있습니다.

- 제스처 기반 조작: VR/AR 환경에서 제스처를 통해 데이터를 조작하고 분석할 수 있는 인터페이스가 개발될 수 있습니다.

- 개인화된 UI: 사용자의 습관과 선호도를 학습하여 자동으로 최적화되는 사용자 인터페이스가 제공될 수 있습니다.

이러한 미래 전망은 Jupyter Notebook과 Google Colab이 단순한 코드 실행 환경을 넘어, 데이터 과학과 AI 개발의 중심 플랫폼으로 발전해 나갈 것임을 보여줍니다. 이는 마치 재능넷이 다양한 분야의 전문가들을 연결하는 플랫폼으로 발전해 나가는 것과 유사한 진화 과정이라고 볼 수 있습니다.

이러한 발전은 데이터 과학자와 AI 개발자들에게 더욱 강력하고 효율적인 도구를 제공할 것이지만, 동시에 새로운 도전과제도 가져올 것입니다. 빠르게 변화하는 기술에 적응하고, 새로운 기능을 효과적으로 활용하며, 동시에 데이터의 안전과 윤리적 사용을 보장하는 것이 중요한 과제가 될 것입니다.

따라서 우리는 이러한 변화에 대비하여 지속적으로 학습하고, 새로운 기술을 실험하며, 동시에 데이터 과학의 근본적인 원칙과 윤리를 견지해 나가야 할 것입니다. Jupyter Notebook과 Google Colab의 미래는 밝지만, 그 잠재력을 최대한 활용하는 것은 결국 우리 사용자들의 몫입니다.

이제 우리는 대화형 데이터 분석 도구의 현재와 미래에 대해 폭넓게 살펴보았습니다. 다음 섹션에서는 이 모든 내용을 종합하여 결론을 내리고, Jupyter Notebook과 Google Colab을 효과적으로 활용하기 위한 최종적인 조언을 제시하겠습니다. 🚀

7. 결론 및 최종 조언 🎓

지금까지 우리는 Jupyter Notebook과 Google Colab이라는 강력한 대화형 데이터 분석 도구에 대해 깊이 있게 살펴보았습니다. 이 도구들은 데이터 과학과 머신러닝 분야에 혁명을 일으켰다고 해도 과언이 아닙니다. 코드 실행, 데이터 시각화, 문서화를 하나의 환경에서 가능케 함으로써, 이들은 데이터 분석 워크플로우를 크게 개선했습니다.

7.1 주요 내용 요약

- Jupyter Notebook의 강점: 대화형 실행, 다양한 언어 지원, Rich Output, 확장성 등

- Google Colab의 이점: 클라우드 기반, 무료 GPU/TPU 제공, 쉬운 공유 및 협업 기능 등

- 실제 프로젝트 적용: 데이터 로딩부터 모델링, 결과 해석까지 전체 데이터 분석 과정에 활용 가능

- Best Practices: 코드 구조화, 메모리 관리, 버전 관리, 보안 주의사항 등

- 미래 전망: AI 통합, 확장된 시각화, 클라우드 네이티브 환경으로의 발전 등

7.2 Jupyter Notebook과 Google Colab의 의의

이 도구들의 가장 큰 의의는 데이터 과학을 '민주화'했다는 점입니다. 복잡한 환경 설정 없이도 누구나 쉽게 데이터 분석을 시작할 수 있게 되었고, 이는 더 많은 사람들이 데이터의 힘을 활용할 수 있게 만들었습니다. 마치 재능넷이 다양한 분야의 전문가들을 연결하여 지식과 기술의 교류를 촉진하는 것처럼, Jupyter Notebook과 Google Colab은 데이터 과학 커뮤니티의 성장과 협력을 가속화했습니다.

7.3 효과적인 활용을 위한 최종 조언

- 지속적인 학습: 데이터 과학 분야는 빠르게 발전하고 있습니다. Jupyter Notebook과 Google Colab의 새로운 기능과 최신 데이터 과학 기술을 지속적으로 학습하세요.

- 실험과 탐색: 이 도구들의 다양한 기능을 두려워하지 말고 적극적으로 실험해보세요. 때로는 실험을 통해 가장 큰 인사이트를 얻을 수 있습니다.

- 협업의 힘 활용: 노트북 공유 기능을 활용하여 동료들과 적극적으로 협업하세요. 다양한 관점은 더 나은 결과를 만들어냅니다.

- 체계적인 접근: 프로젝트를 시작할 때 명확한 목표를 설정하고, 체계적으로 노트북을 구성하세요. 이는 프로젝트의 재현성과 유지보수성을 높입니다.

- 버전 관리 습관화: Git 등의 버전 관리 시스템을 활용하여 작업의 이력을 관리하세요. 이는 실수를 방지하고 협업을 용이하게 합니다.

- 보안 의식: 특히 Google Colab 사용 시 민감한 데이터 처리에 주의하세요. 필요한 경우 로컬 Jupyter 환경을 사용하는 것도 고려해보세요.

- 최적화 고려: 대규모 데이터셋을 다룰 때는 메모리 사용과 실행 시간 최적화에 신경 쓰세요. 이는 효율적인 작업 수행의 핵심입니다.

- 문서화의 중요성: 코드뿐만 아니라 분석 과정과 결과에 대한 설명을 충실히 기록하세요. 이는 나중에 프로젝트를 리뷰하거나 공유할 때 큰 도움이 됩니다.

- 윤리적 고려: 데이터 처리와 AI 모델 개발 시 윤리적 측면을 항상 고려하세요. 편향성 검사, 공정성 평가 등을 습관화하는 것이 중요합니다.

- 커뮤니티 참여: Jupyter와 Colab 관련 커뮤니티에 참여하여 지식을 공유하고 최신 트렌드를 파악하세요. 이는 개인의 성장뿐만 아니라 전체 생태계의 발전에도 기여합니다.

7.4 마무리

Jupyter Notebook과 Google Colab은 데이터 과학의 현재를 대표하는 도구이며, 동시에 미래를 열어가는 열쇠이기도 합니다. 이 도구들은 단순한 코딩 환경을 넘어, 아이디어를 실험하고, 데이터에서 인사이트를 추출하며, 복잡한 문제를 해결하는 강력한 플랫폼으로 진화하고 있습니다.

그러나 도구의 힘은 그것을 사용하는 사람의 능력에 달려 있습니다. 따라서 이 도구들을 효과적으로 활용하기 위해서는 지속적인 학습과 실천이 필요합니다. 데이터 과학의 기본 원리를 이해하고, 최신 기술 트렌드를 따라가며, 동시에 윤리적 고려사항을 항상 염두에 두어야 합니다.

마지막으로, Jupyter Notebook과 Google Colab은 그저 도구일 뿐이며, 진정한 가치는 여러분이 이를 통해 만들어내는 인사이트와 솔루션에 있다는 점을 기억하세요. 이 도구들을 발판 삼아 데이터의 세계를 탐험하고, 혁신적인 아이디어를 실현하며, 세상을 변화시킬 수 있는 프로젝트를 만들어 나가시기 바랍니다.

여러분의 데이터 과학 여정에 Jupyter Notebook과 Google Colab이 믿음직한 동반자가 되기를 바랍니다. 끊임없는 호기심과 열정으로 데이터의 바다를 항해하세요. 그 여정에서 발견할 놀라운 인사이트들이 여러분을 기다리고 있을 것입니다. 행운을 빕니다! 🚀🌟