BeagleBone Black: Linux 기반 로봇 제어 시스템 개발 🤖💻

로봇 공학과 임베디드 시스템의 세계에 오신 것을 환영합니다! 이 전자책에서는 BeagleBone Black을 활용한 Linux 기반 로봇 제어 시스템 개발에 대해 심도 있게 알아보겠습니다. BeagleBone Black은 강력하고 유연한 싱글 보드 컴퓨터로, 로봇 공학 프로젝트에 이상적인 플랫폼입니다.

우리는 하드웨어 설정부터 소프트웨어 개발, 센서 통합, 모터 제어, 그리고 고급 로봇 알고리즘 구현까지 전 과정을 다룰 예정입니다. 이 여정을 통해 여러분은 실제 작동하는 로봇 시스템을 구축하는 데 필요한 지식과 기술을 습득하게 될 것입니다.

이 글은 재능넷의 '지식인의 숲' 메뉴에 등록되는 컨텐츠로, 프로그램 개발 카테고리의 '프로그램/소스' 섹션에 속합니다. 재능넷은 다양한 분야의 전문가들이 지식과 기술을 공유하는 플랫폼으로, 이 글을 통해 로봇 공학에 관심 있는 많은 분들께 가치 있는 정보를 전달하고자 합니다.

그럼 이제 BeagleBone Black과 Linux를 이용한 로봇 제어 시스템의 세계로 뛰어들어 볼까요? 🚀

1. BeagleBone Black 소개 📘

BeagleBone Black은 Texas Instruments의 AM335x 1GHz ARM Cortex-A8 프로세서를 탑재한 저전력, 오픈소스 싱글 보드 컴퓨터입니다. 이 강력한 소형 디바이스는 다음과 같은 특징을 가지고 있습니다:

- 512MB DDR3 RAM

- 4GB 8-bit eMMC 온보드 플래시 스토리지

- USB 클라이언트(전원 및 통신용) 및 USB 호스트

- HDMI 출력

- 2x 46핀 헤더(GPIO, I2C, SPI, UART 등)

이러한 특성들은 BeagleBone Black을 로봇 제어 시스템 개발에 이상적인 플랫폼으로 만듭니다. 고성능 프로세서와 다양한 입출력 옵션을 통해 복잡한 로봇 알고리즘을 실행하고 다양한 센서 및 액추에이터와 상호작용할 수 있습니다.

BeagleBone Black의 이러한 하드웨어 구성은 로봇 제어 시스템에 필요한 다양한 기능을 제공합니다. 고성능 CPU는 복잡한 연산을 처리하고, 충분한 RAM은 실시간 데이터 처리를 가능하게 합니다. eMMC 스토리지는 운영 체제와 프로그램을 저장하며, 다양한 I/O 옵션들은 센서와 액추에이터 연결에 활용됩니다.

이제 BeagleBone Black의 기본 구조를 이해했으니, 다음 섹션에서는 이 플랫폼에 Linux를 설치하고 개발 환경을 구축하는 방법에 대해 알아보겠습니다. 🛠️

2. Linux 운영 체제 설치 및 환경 구성 🐧

BeagleBone Black에 Linux를 설치하고 개발 환경을 구성하는 것은 로봇 제어 시스템 개발의 첫 단계입니다. 여기서는 Debian Linux를 사용할 것인데, 이는 BeagleBone Black에 가장 널리 사용되는 Linux 배포판 중 하나입니다.

2.1 Debian Linux 이미지 다운로드 및 설치

1. BeagleBoard.org 공식 웹사이트에서 최신 Debian 이미지를 다운로드합니다.

2. 다운로드한 이미지를 microSD 카드에 플래싱합니다. 이를 위해 Etcher나 DD 명령어를 사용할 수 있습니다.

sudo dd if=debian-image.img of=/dev/mmcblk0 bs=1M3. microSD 카드를 BeagleBone Black에 삽입하고 전원을 켭니다.

4. 시리얼 콘솔이나 SSH를 통해 BeagleBone Black에 접속합니다.

2.2 기본 시스템 설정

BeagleBone Black에 접속한 후, 다음과 같은 기본 설정을 수행합니다:

- 시스템 업데이트 및 업그레이드

sudo apt update sudo apt upgrade - 필요한 개발 도구 설치

sudo apt install build-essential git python3 python3-pip - 네트워크 설정 (필요한 경우)

sudo nano /etc/network/interfaces

2.3 GPIO 및 하드웨어 인터페이스 설정

BeagleBone Black의 GPIO 핀을 사용하기 위해 다음 단계를 수행합니다:

- Device Tree Overlay 설정

- 사용자 권한 설정

- Python용 Adafruit_BBIO 라이브러리 설치

sudo pip3 install Adafruit_BBIO

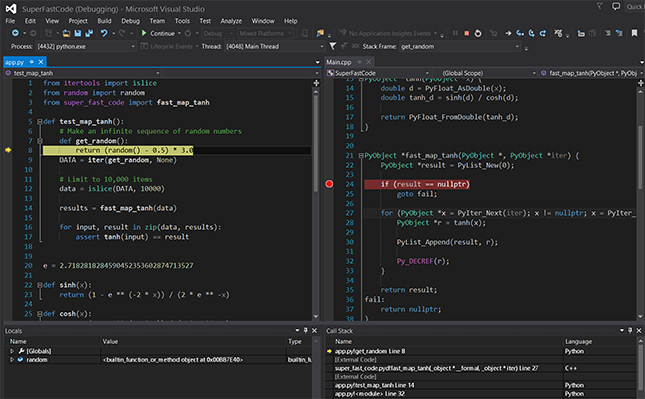

2.4 개발 환경 구축

로봇 제어 시스템 개발을 위한 IDE와 도구를 설치합니다:

- Visual Studio Code (원격 개발용)

sudo apt install code - ROS (Robot Operating System) 설치 (선택사항)

sudo sh -c 'echo "deb http://packages.ros.org/ros/ubuntu $(lsb_release -sc) main" > /etc/apt/sources.list.d/ros-latest.list' sudo apt-key adv --keyserver 'hkp://keyserver.ubuntu.com:80' --recv-key C1CF6E31E6BADE8868B172B4F42ED6FBAB17C654 sudo apt update sudo apt install ros-melodic-desktop-full

이제 BeagleBone Black에 Linux 운영 체제를 설치하고 기본적인 개발 환경을 구축했습니다. 이 환경은 로봇 제어 시스템을 개발하고 테스트하는 데 필요한 모든 도구와 라이브러리를 제공합니다.

다음 섹션에서는 이 환경을 활용하여 실제 로봇 제어 시스템을 개발하는 방법에 대해 알아보겠습니다. 센서 데이터 수집, 모터 제어, 그리고 고급 로봇 알고리즘 구현 등 흥미진진한 주제들이 기다리고 있습니다! 🤖💻

3. 센서 인터페이싱 및 데이터 수집 📊

로봇 제어 시스템에서 센서는 매우 중요한 역할을 합니다. 센서를 통해 로봇은 주변 환경을 인식하고 적절히 반응할 수 있습니다. 이 섹션에서는 BeagleBone Black에 다양한 센서를 연결하고 데이터를 수집하는 방법을 알아보겠습니다.

3.1 GPIO를 이용한 디지털 센서 연결

BeagleBone Black의 GPIO 핀을 사용하여 간단한 디지털 센서(예: 버튼, 적외선 센서)를 연결할 수 있습니다.

import Adafruit_BBIO.GPIO as GPIO

import time

sensor_pin = "P8_11"

GPIO.setup(sensor_pin, GPIO.IN)

while True:

if GPIO.input(sensor_pin):

print("Sensor activated!")

time.sleep(0.1)

3.2 I2C를 이용한 아날로그 센서 연결

I2C 프로토콜을 사용하여 더 복잡한 센서(예: 가속도계, 자이로스코프)를 연결할 수 있습니다.

import Adafruit_BBIO.I2C as I2C

import time

# MPU-6050 가속도계/자이로스코프 센서 예제

device_address = 0x68

i2c = I2C.get_i2c_device(device_address)

def read_word(adr):

high = i2c.readU8(adr)

low = i2c.readU8(adr+1)

val = (high << 8) + low

return val

while True:

accel_x = read_word(0x3B)

accel_y = read_word(0x3D)

accel_z = read_word(0x3F)

print(f"Accelerometer: X={accel_x}, Y={accel_y}, Z={accel_z}")

time.sleep(0.5)

3.3 아날로그 입력을 이용한 센서 연결

BeagleBone Black의 아날로그 입력 핀을 사용하여 아날로그 센서(예: 포텐셔미터, 광센서)의 데이터를 읽을 수 있습니다.

import Adafruit_BBIO.ADC as ADC

import time

ADC.setup()

while True:

value = ADC.read("P9_39")

voltage = value * 1.8 # ADC reference voltage is 1.8V

print(f"Sensor voltage: {voltage:.2f}V")

time.sleep(0.5)

3.4 센서 데이터 처리 및 필터링

센서에서 읽은 원시 데이터는 노이즈나 오차를 포함할 수 있습니다. 이를 처리하고 필터링하는 것이 중요합니다.

import numpy as np

class LowPassFilter:

def __init__(self, alpha):

self.alpha = alpha

self.value = None

def update(self, measurement):

if self.value is None:

self.value = measurement

else:

self.value = self.alpha * measurement + (1 - self.alpha) * self.value

return self.value

# 사용 예

lpf = LowPassFilter(alpha=0.2)

filtered_data = []

for raw_value in raw_sensor_data:

filtered_value = lpf.update(raw_value)

filtered_data.append(filtered_value)

이 섹션에서는 BeagleBone Black을 사용하여 다양한 유형의 센서를 연결하고 데이터를 수집하는 방법을 살펴보았습니다. 또한 수집된 데이터를 처리하고 필터링하는 기본적인 기법도 알아보았습니다.

센서 데이터는 로봇의 '눈'과 '귀'역할을 합니다. 이 데이터를 효과적으로 수집하고 처리하는 능력은 로봇 제어 시스템의 성능을 크게 좌우합니다. 재능넷의 '프로그램 개발' 카테고리에서는 이러한 센서 데이터 처리 기술에 대한 더 많은 정보와 예제를 찾아볼 수 있습니다.

다음 섹션에서는 이렇게 수집하고 처리한 센서 데이터를 바탕으로 로봇의 모터를 제어하는 방법에 대해 알아보겠습니다. 센서 데이터와 모터 제어를 결합하면, 우리의 로봇은 환경에 반응하고 자율적으로 움직일 수 있게 됩니다! 🚀

4. 모터 제어 및 액추에이터 인터페이싱 🔧

로봇 제어 시스템에서 모터와 액추에이터는 로봇이 실제로 움직이고 작업을 수행하는 데 필수적인 요소입니다. 이 섹션에서는 BeagleBone Black을 사용하여 다양한 유형의 모터를 제어하는 방법을 알아보겠습니다.

4.1 DC 모터 제어

DC 모터는 로봇 공학에서 가장 흔히 사용되는 모터 유형 중 하나입니다. H-브릿지 회로와 PWM(Pulse Width Modulation)을 사용하여 DC 모터의 속도와 방향을 제어할 수 있습니다.

import Adafruit_BBIO.PWM as PWM

import time

motor_pin = "P9_14"

PWM.start(motor_pin, 0, 1000)

try:

while True:

for duty_cycle in range(0, 101, 5):

PWM.set_duty_cycle(motor_pin, duty_cycle)

time.sleep(0.1)

for duty_cycle in range(100, -1, -5):

PWM.set_duty_cycle(motor_pin, duty_cycle)

time.sleep(0.1)

except KeyboardInterrupt:

PWM.stop(motor_pin)

PWM.cleanup()

4.2 서보 모터 제어

서보 모터는 정밀한 각도 제어가 필요한 경우에 사용됩니다. PWM 신호를 사용하여 서보 모터의 각도를 제어할 수 있습니다.

import Adafruit_BBIO.PWM as PWM

import time

servo_pin = "P9_14"

PWM.start(servo_pin, 5, 50) # 50Hz PWM frequency

def set_angle(angle):

duty_cycle = (angle / 18) + 2.5

PWM.set_duty_cycle(servo_pin, duty_cycle)

try:

while True:

set_angle(0)

time.sleep(1)

set_angle(90)

time.sleep(1)

set_angle(180)

time.sleep(1)

except KeyboardInterrupt:

PWM.stop(servo_pin)

PWM.cleanup()

4.3 스테퍼 모터 제어

스테퍼 모터는 정밀한 위치 제어가 필요한 경우에 사용됩니다. 각 스텝마다 정확한 각도로 회전할 수 있습니다.

import Adafruit_BBIO.GPIO as GPIO

import time

# 스테퍼 모터 핀 설정

coil_A_1_pin = "P8_10"

coil_A_2_pin = "P8_12"

coil_B_1_pin = "P8_14"

coil_B_2_pin = "P8_16"

GPIO.setup(coil_A_1_pin, GPIO.OUT)

GPIO.setup(coil_A_2_pin, GPIO.OUT)

GPIO.setup(coil_B_1_pin, GPIO.OUT)

GPIO.setup(coil_B_2_pin, GPIO.OUT)

# 스테퍼 모터 시퀀스

step_sequence = [

[1,0,0,0],

[1,1,0,0],

[0,1,0,0],

[0,1,1,0],

[0,0,1,0],

[0,0,1,1],

[0,0,0,1],

[1,0,0,1]

]

def set_step(w1, w2, w3, w4):

GPIO.output(coil_A_1_pin, w1)

GPIO.output(coil_A_2_pin, w2)

GPIO.output(coil_B_1_pin, w3)

GPIO.output(coil_B_2_pin, w4)

def step_forward(steps, delay):

for i in range(steps):

for step in step_sequence:

set_step(*step)

time.sleep(delay)

try:

while True:

step_forward(512, 0.001) # 360도 회전 (512 스텝)

time.sleep(1)

except KeyboardInterrupt:

GPIO.cleanup()

4.4 모터 제어기 설계

실제 로봇 시스템에서는 단순히 모터를 구동하는 것 이상의 제어가 필요합니다. PID(비례-적분-미분) 제어기는 정확하고 안정적인 모터 제어를 위해 널리 사용되는 기법입니다.

class PIDController:

def __init__(self, kp, ki, kd):

self.kp = kp

self.ki = ki

self.kd = kd

self.prev_error = 0

self.integral = 0

def update(self, error, dt):

self.integral += error * dt

derivative = (error - self.prev_error) / dt

output = self.kp * error + self.ki * self.integral + self.kd * derivative

self.prev_error = error

return output

# PID 제어기 사용 예

pid = PIDController(kp=1.0, ki=0.1, kd=0.05)

target_position = 90 # 목표 위치 (도)

while True:

current_position = read_motor_position() # 현재 모터 위치 읽기 함수

error = target_position - current_position

control_signal = pid.update(error, dt=0.1)

# 제어 신호를 모터에 적용

apply_motor_control(control_signal)

time.sleep(0.1)

이 섹션에서는 BeagleBone Black을 사용하여 다양한 유형의 모터를 제어하는 방법을 살펴보았습니다. DC 모터, 서보 모터, 스테퍼 모터 등 각각의 모터 유형에 맞는 제어 방법을 학습했으며, PID 제어기를 통해 더욱 정밀한 모터 제어 방법도 알아보았습니다.

모터 제어는 로봇 공학에서 매우 중요한 부분입니다. 정확하고 효율적인 모터 제어는 로봇의 전반적인 성능과 기능성을 크게 향상시킵니다. 재능넷의 '프로그램 개발' 카테고리에서는 이러한 모터 제어 기술에 대한 더 많은 정보와 고급 기법들을 찾아볼 수 있습니다.

다음 섹션에서는 지금까지 학습한 센서 데이터 수집과 모터 제어 기술을 결합하여 실제 로봇 제어 알고리즘을 구현하는 방법에 대해 알아보겠습니다. 이를 통해 우리의 로봇은 환경을 인식하고 자율적으로 행동할 수 있게 될 것입니다! 🤖🚀

5. 로봇 제어 알고리즘 구현 🧠

이제 센서 데이터 수집과 모터 제어 기술을 익혔으니, 이를 결합하여 실제 로봇 제어 알고리즘을 구현해 보겠습니다. 이 섹션에서는 간단한 장애물 회피 알고리즘부터 시작하여 더 복잡한 경로 계획 및 자율 주행 알고리즘까지 살펴보겠습니다.

5.1 간단한 장애물 회피 알고리즘

먼저, 초음파 센서를 사용하여 장애물을 감지하고 회피하는 간단한 알고리즘을 구현해 보겠습니다.

import Adafruit_BBIO.GPIO as GPIO

import Adafruit_BBIO.PWM as PWM

import time

# 초음파 센서 설정

TRIG = "P8_11"

ECHO = "P8_12"

# 모터 설정

LEFT_MOTOR = "P9_14"

RIGHT_MOTOR = "P9_16"

GPIO.setup(TRIG, GPIO.OUT)

GPIO.setup(ECHO, GPIO.IN)

PWM.start(LEFT_MOTOR, 0, 1000)

PWM.start(RIGHT_MOTOR, 0, 1000)

def get_distance():

GPIO.output(TRIG, True)

time.sleep(0.00001)

GPIO.output(TRIG, False)

while GPIO.input(ECHO) == 0:

pulse_start = time.time()

while GPIO.input(ECHO) == 1:

pulse_end = time.time()

pulse_duration = pulse_end - pulse_start

distance = pulse_duration * 17150

return round(distance, 2)

def move_forward():

PWM.set_duty_cycle(LEFT_MOTOR, 50)

PWM.set_duty_cycle(RIGHT_MOTOR, 50)

def turn_right():

PWM.set_duty_cycle(LEFT_MOTOR, 50)

PWM.set_duty_cycle(RIGHT_MOTOR, 0)

try:

while True:

distance = get_distance()

if distance > 20: # 장애물이 20cm 이상 떨어져 있으면

move_forward()

else:

turn_right()

time.sleep(0.1)

except KeyboardInterrupt:

PWM.stop(LEFT_MOTOR)

PWM.stop(RIGHT_MOTOR)

PWM.cleanup()

GPIO.cleanup()

5.2 PID 제어를 이용한 라인 추적 알고리즘

다음으로, PID 제어기를 사용하여 더 정교한 라인 추적 알고리즘을 구현해 보겠습니다.

import Adafruit_BBIO.ADC as ADC

import Adafruit_BBIO.PWM as PWM

import time

# 라인 센서 설정

LEFT_SENSOR = "P9_39"

RIGHT_SENSOR = "P9_40"

# 모터 설정

LEFT_MOTOR = "P9_14"

RIGHT_MOTOR = "P9_16"

ADC.setup()

PWM.start(LEFT_MOTOR, 0, 1000)

PWM.start(RIGHT_MOTOR, 0, 1000)

class PIDController:

def __init__(self, kp, ki, kd):

self.kp = kp

self.ki = ki

self.kd = kd

self.prev_error = 0

self.integral = 0

def update(self, error, dt):

self.integral += error * dt

derivative = (error - self.prev_error) / dt

output = self.kp * error + self.ki * self.integral + self.kd * derivative

self.prev_error = error

return output

pid = PIDController(kp=1.0, ki=0.1, kd=0.05)

try:

while True:

left_value = ADC.read(LEFT_SENSOR)

right_value = ADC.read(RIGHT_SENSOR)

error = left_value - right_value

correction = pid.update(error, dt=0.1)

left_speed = 50 + correction

right_speed = 50 - correction

PWM.set_duty_cycle(LEFT_MOTOR, max(0, min(100, left_speed)))

PWM.set_duty_cycle(RIGHT_MOTOR, max(0, min(100, right_speed)))

time.sleep(0.1)

except KeyboardInterrupt:

PWM.stop(LEFT_MOTOR)

PWM.stop(RIGHT_MOTOR)

PWM.cleanup()

5.3 A* 알고리즘을 이용한 경로 계획

마지막으로, 더 복잡한 환경에서의 자율 주행을 위해 A* 알고리즘을 사용한 경로 계획을 구현해 보겠습니다.

import heapq

class Node:

def __init__(self, position, g=0, h=0, parent=None):

self.position = position

self.g = g

self.h = h

self.f = g + h

self.parent = parent

def __lt__(self, other):

return self.f < other.f

def heuristic(a, b):

return abs(b[0] - a[0]) + abs(b[1] - a[1])

def get_neighbors(node, grid):

neighbors = []

for dx, dy in [(0, 1), (1, 0), (0, -1), (-1, 0)]:

new_position = (node.position[0] + dx, node.position[1] + dy)

if 0 <= new_position[0] < len(grid) and 0 <= new_position[1] < len(grid[0]) and grid[new_position[0]][new_position[1]] == 0:

neighbors.append(new_position)

return neighbors

def a_star(start, goal, grid):

start_node = Node(start, h=heuristic(start, goal))

open_list = [start_node]

closed_set = set()

while open_list:

current_node = heapq.heappop(open_list)

if current_node.position == goal:

path = []

while current_node:

path.append(current_node.position)

current_node = current_node.parent

return path[::-1]

closed_set.add(current_node.position)

for neighbor_pos in get_neighbors(current_node, grid):

if neighbor_pos in closed_set:

continue

neighbor = Node(neighbor_pos, g=current_node.g + 1, h=heuristic(neighbor_pos, goal), parent=current_node)

if neighbor not in open_list:

heapq.heappush(open_list, neighbor)

elif neighbor.g < current_node.g:

open_list.remove(neighbor)

heapq.heappush(open_list, neighbor)

return None

# 사용 예

grid = [

[0, 0, 0, 0, 1],

[1, 1, 0, 0, 0],

[0, 0, 0, 1, 0],

[0, 1, 1, 1, 0],

[0, 0, 0, 0, 0]

]

start = (0, 0)

goal = (4, 4)

path = a_star(start, goal, grid)

print("Optimal path:", path)

이 섹션에서는 BeagleBone Black을 사용하여 다양한 로봇 제어 알고리즘을 구현하는 방법을 살펴보았습니다. 간단한 장애물 회피 알고리즘부터 PID 제어를 이용한 라인 추적, 그리고 A* 알고리즘을 이용한 복잡한 경로 계획까지 다양한 수준의 알고리즘을 구현해 보았습니다.

이러한 알고리즘들은 로봇이 자율적으로 행동하고 복잡한 작업을 수행하는 데 필수적입니다. 재능넷의 '프로그램 개발' 카테고리에서는 이러한 로봇 제어 알고리즘에 대한 더 많은 정보와 고급 기법들을 찾아볼 수 있습니다.

다음 섹션에서는 지금까지 학습한 모든 내용을 종합하여 완전한 로봇 제어 시스템을 구축하는 방법에 대해 알아보겠습니다. 센서 데이터 수집, 모터 제어, 그리고 고급 알고리즘을 모두 결합하여 실제로 작동하는 자율 주행 로봇을 만들어 볼 것입니다! 🤖🚀

6. 종합 프로젝트: 자율 주행 로봇 구현 🚗

이제 지금까지 학습한 모든 내용을 종합하여 실제로 작동하는 자율 주행 로봇을 구현해 보겠습니다. 이 로봇은 초음파 센서로 장애물을 감지하고, 라인 센서로 경로를 따라가며, 카메라로 주변 환경을 인식할 수 있습니다.

6.1 하드웨어 구성

- BeagleBone Black

- DC 모터 2개 (좌우 바퀴용)

- 초음파 센서 (HC-SR04)

- 라인 센서 2개

- Pi Camera

- 모터 드라이버 (L298N)

- 배터리 팩

6.2 소프트웨어 구조

import Adafruit_BBIO.GPIO as GPIO

import Adafruit_BBIO.PWM as PWM

import Adafruit_BBIO.ADC as ADC

import cv2

import numpy as np

import time

# 핀 설정

LEFT_MOTOR_PWM = "P9_14"

RIGHT_MOTOR_PWM = "P9_16"

LEFT_MOTOR_DIR = "P8_13"

RIGHT_MOTOR_DIR = "P8_19"

ULTRASONIC_TRIG = "P8_11"

ULTRASONIC_ECHO = "P8_12"

LEFT_LINE_SENSOR = "P9_39"

RIGHT_LINE_SENSOR = "P9_40"

# GPIO 및 PWM 설정

GPIO.setup(LEFT_MOTOR_DIR, GPIO.OUT)

GPIO.setup(RIGHT_MOTOR_DIR, GPIO.OUT)

GPIO.setup(ULTRASONIC_TRIG, GPIO.OUT)

GPIO.setup(ULTRASONIC_ECHO, GPIO.IN)

PWM.start(LEFT_MOTOR_PWM, 0, 1000)

PWM.start(RIGHT_MOTOR_PWM, 0, 1000)

ADC.setup()

# 카메라 설정

camera = cv2.VideoCapture(0)

class Robot:

def __init__(self):

self.speed = 50

self.direction = 0 # -1: 왼쪽, 0: 직진, 1: 오른쪽

def move(self, left_speed, right_speed):

PWM.set_duty_cycle(LEFT_MOTOR_PWM, abs(left_speed))

PWM.set_duty_cycle(RIGHT_MOTOR_PWM, abs(right_speed))

GPIO.output(LEFT_MOTOR_DIR, GPIO.HIGH if left_speed >= 0 else GPIO.LOW)

GPIO.output(RIGHT_MOTOR_DIR, GPIO.HIGH if right_speed >= 0 else GPIO.LOW)

def get_distance(self):

GPIO.output(ULTRASONIC_TRIG, True)

time.sleep(0.00001)

GPIO.output(ULTRASONIC_TRIG, False)

while GPIO.input(ULTRASONIC_ECHO) == 0:

pulse_start = time.time()

while GPIO.input(ULTRASONIC_ECHO) == 1:

pulse_end = time.time()

pulse_duration = pulse_end - pulse_start

distance = pulse_duration * 17150

return round(distance, 2)

def follow_line(self):

left_value = ADC.read(LEFT_LINE_SENSOR)

right_value = ADC.read(RIGHT_LINE_SENSOR)

if left_value > right_value:

self.direction = -1

elif right_value > left_value:

self.direction = 1

else:

self.direction = 0

def detect_objects(self):

ret, frame = camera.read()

if not ret:

return

# 객체 감지 로직 (예: 색상 기반 감지)

hsv = cv2.cvtColor(frame, cv2.COLOR_BGR2HSV)

lower_red = np.array([0, 50, 50])

upper_red = np.array([10, 255, 255])

mask = cv2.inRange(hsv, lower_red, upper_red)

contours, _ = cv2.findContours(mask, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

if contours:

print("Object detected!")

def run(self):

try:

while True:

distance = self.get_distance()

if distance < 20: # 장애물이 20cm 이내에 있으면

self.move(-self.speed, self.speed) # 제자리 회전

else:

self.follow_line()

if self.direction == -1:

self.move(self.speed * 0.5, self.speed)

elif self.direction == 1:

self.move(self.speed, self.speed * 0.5)

else:

self.move(self.speed, self.speed)

self.detect_objects()

time.sleep(0.1)

except KeyboardInterrupt:

self.move(0, 0)

PWM.cleanup()

GPIO.cleanup()

camera.release()

if __name__ == "__main__":

robot = Robot()

robot.run()

6.3 주요 기능 설명

- 장애물 회피: 초음파 센서를 사용하여 전방 장애물을 감지하고, 20cm 이내에 장애물이 감지되면 제자리에서 회전합니다.

- 라인 추적: 두 개의 라인 센서를 사용하여 검은 선을 따라 이동합니다. 센서 값의 차이에 따라 로봇의 방향을 조정합니다.

- 객체 감지: Pi Camera를 사용하여 실시간으로 이미지를 캡처하고, 간단한 색상 기반 객체 감지를 수행합니다. 이 예제에서는 빨간색 객체를 감지합니다.

- 모터 제어: PWM을 사용하여 DC 모터의 속도를 제어하고, GPIO를 사용하여 모터의 방향을 제어합니다.

이 종합 프로젝트는 BeagleBone Black을 사용한 Linux 기반 로봇 제어 시스템의 모든 핵심 요소를 포함하고 있습니다. 센서 데이터 수집, 모터 제어, 그리고 고급 알고리즘을 결합하여 실제로 작동하는 자율 주행 로봇을 구현했습니다.

이 프로젝트를 기반으로 더 복잡한 기능을 추가할 수 있습니다 . 예를 들어: - GPS 모듈을 추가하여 실외 내비게이션 기능 구현 - 머신러닝 알고리즘을 통한 더 정교한 객체 인식 및 분류 - 음성 인식 모듈을 추가하여 음성 명령으로 로봇 제어 - 무선 통신 모듈을 이용한 원격 모니터링 및 제어 시스템 구축 이러한 확장은 로봇의 기능을 크게 향상시키고, 더 복잡한 작업을 수행할 수 있게 해줍니다.

7. 결론 및 향후 발전 방향 🚀

이 전자책을 통해 우리는 BeagleBone Black을 사용한 Linux 기반 로봇 제어 시스템의 개발 과정을 상세히 살펴보았습니다. 하드웨어 설정부터 센서 데이터 수집, 모터 제어, 그리고 고급 알고리즘 구현까지 로봇 공학의 핵심 요소들을 다루었습니다.

이러한 지식과 기술은 다양한 분야에서 활용될 수 있습니다:

- 산업용 로봇: 공장 자동화, 물류 시스템 등

- 서비스 로봇: 가정용 청소 로봇, 안내 로봇 등

- 탐사 로봇: 우주 탐사, 해저 탐사 등

- 의료 로봇: 수술 보조 로봇, 재활 치료 로봇 등

로봇 공학 분야는 빠르게 발전하고 있으며, 앞으로 더 많은 혁신이 예상됩니다. 향후 발전 방향으로는 다음과 같은 것들이 있습니다:

- 인공지능과의 결합: 딥러닝을 활용한 더 정교한 환경 인식 및 의사결정 능력

- 스웜 로보틱스: 다수의 소형 로봇이 협력하여 복잡한 작업을 수행

- 소프트 로보틱스: 유연한 재료를 사용한 안전하고 적응력 높은 로봇 개발

- 인간-로봇 상호작용: 더 자연스럽고 직관적인 인터페이스 개발

- 에너지 효율성: 저전력 하드웨어와 효율적인 알고리즘을 통한 에너지 소비 최적화

이 전자책에서 학습한 내용은 이러한 미래 기술의 기반이 됩니다. BeagleBone Black과 Linux를 사용한 로봇 제어 시스템 개발 경험은 더 복잡하고 고급한 로봇 시스템을 개발하는 데 큰 도움이 될 것입니다.

로봇 공학은 끊임없이 발전하는 분야입니다. 지속적인 학습과 실험을 통해 여러분만의 혁신적인 로봇 시스템을 개발해 보시기 바랍니다. 이 전자책이 여러분의 로봇 공학 여정에 유용한 가이드가 되었기를 희망합니다.

로봇 공학의 미래는 여러분의 손에 달려있습니다. 창의성을 발휘하여 세상을 변화시킬 새로운 로봇 기술을 만들어 나가세요! 🤖🌟