데이터 과학을 위한 파이썬: Pandas로 데이터 다루기 완전 정복 가이드 (2025년 최신 버전)

안녕, 데이터 분석에 관심 있는 친구들! 🚀 오늘은 데이터 과학의 필수 도구인 Pandas에 대해 함께 알아볼 거야. 2025년 3월 기준 최신 트렌드와 기능을 모두 담았으니 끝까지 함께해줘!

Pandas는 파이썬에서 데이터 분석을 위한 가장 강력한 라이브러리로, 데이터 과학자부터 개발자까지 모두가 사랑하는 도구야.

📚 목차

- Pandas 소개와 기본 개념

- 데이터 구조: Series와 DataFrame

- 데이터 불러오기와 내보내기

- 데이터 탐색 및 전처리

- 데이터 변환 및 집계

- 데이터 시각화 기초

- 고급 Pandas 기능과 팁

- 실전 프로젝트: 데이터 분석 워크플로우

- 2025년 Pandas 최신 기능

- 다음 단계와 학습 자원

1. Pandas 소개와 기본 개념 🐼

Pandas는 2008년 웨스 맥키니(Wes McKinney)가 개발한 오픈소스 데이터 분석 라이브러리야. 이름은 'Panel Data'에서 따왔고, 귀여운 판다 🐼 마스코트로도 유명하지!

2025년 현재 Pandas는 버전 2.2.x로 업데이트되어 더욱 강력한 성능과 새로운 기능들을 제공하고 있어.

Pandas를 사용하는 이유

엑셀이나 SQL 같은 도구도 있는데 왜 Pandas를 배워야 할까? 🤔

- 대용량 데이터 처리 가능 (수백만 행의 데이터도 빠르게!)

- 강력한 데이터 조작 및 분석 기능

- 다양한 형식의 데이터 파일 지원 (CSV, Excel, SQL, JSON 등)

- 데이터 시각화와의 원활한 통합

- 파이썬 생태계의 다른 도구들과 완벽한 호환

특히 데이터 과학 분야에서 일하고 싶다면 Pandas는 필수 스킬이라고 할 수 있어. 재능넷에서도 데이터 분석 관련 재능을 공유하는 분들이 Pandas를 많이 활용한다고 해!

Pandas 설치하기

시작하기 전에 Pandas를 설치해야겠지? 터미널이나 명령 프롬프트에서 아래 명령어를 실행해봐:

pip install pandas아나콘다(Anaconda)를 사용한다면:

conda install pandas2025년 최신 버전을 설치하려면:

pip install pandas==2.2.02. 데이터 구조: Series와 DataFrame 📊

Pandas의 핵심은 두 가지 데이터 구조야. Series와 DataFrame이 바로 그것!

Series: 1차원 배열

Series는 1차원 배열과 같은 구조로, 인덱스가 있는 데이터의 시퀀스야. 넘파이 배열이나 파이썬 리스트와 비슷하지만, 각 요소에 레이블(인덱스)을 붙일 수 있다는 점이 특별해!

import pandas as pd

import numpy as np

# Series 생성하기

s = pd.Series([1, 3, 5, np.nan, 6, 8])

print(s)

# 인덱스 지정하기

s2 = pd.Series([10, 20, 30, 40], index=['a', 'b', 'c', 'd'])

print(s2)결과는 이렇게 나와:

0 1.0

1 3.0

2 5.0

3 NaN

4 6.0

5 8.0

dtype: float64

a 10

b 20

c 30

d 40

dtype: int64DataFrame: 2차원 테이블

DataFrame은 Pandas의 진짜 주인공! 엑셀 스프레드시트나 SQL 테이블과 같은 2차원 데이터 구조로, 여러 개의 Series가 모여 만들어진다고 생각하면 돼.

# DataFrame 생성하기

df = pd.DataFrame({

'이름': ['김데이터', '박분석', '이파이썬', '최판다스'],

'나이': [25, 30, 28, 22],

'직업': ['데이터 과학자', '개발자', '분석가', '학생']

})

print(df)결과:

이름 나이 직업

0 김데이터 25 데이터 과학자

1 박분석 30 개발자

2 이파이썬 28 분석가

3 최판다스 22 학생DataFrame은 다양한 방법으로 생성할 수 있어:

- 딕셔너리로부터 생성

- 리스트의 리스트로부터 생성

- 다른 DataFrame으로부터 생성

- 외부 파일(CSV, Excel 등)에서 데이터 읽어오기

# 날짜 범위로 DataFrame 만들기

dates = pd.date_range('20250301', periods=6)

df2 = pd.DataFrame(np.random.randn(6, 4), index=dates, columns=list('ABCD'))

print(df2)이렇게 날짜를 인덱스로 사용하면 시계열 데이터를 다루기 정말 편리해져! 🕒

3. 데이터 불러오기와 내보내기 📂

실제 데이터 분석에서는 외부 파일에서 데이터를 불러오는 경우가 대부분이야. Pandas는 다양한 형식의 파일을 쉽게 처리할 수 있어!

CSV 파일 다루기

CSV(Comma-Separated Values)는 가장 흔한 데이터 형식 중 하나야.

# CSV 파일 읽기

df = pd.read_csv('data.csv')

# CSV 파일로 저장하기

df.to_csv('output.csv', index=False)💡 index=False 옵션을 사용하면 인덱스 열을 저장하지 않아서 더 깔끔한 CSV 파일을 만들 수 있어!

Excel 파일 다루기

엑셀 파일도 쉽게 처리할 수 있어. 단, openpyxl 또는 xlrd 패키지를 먼저 설치해야 해.

# Excel 파일 읽기

df = pd.read_excel('data.xlsx', sheet_name='Sheet1')

# Excel 파일로 저장하기

df.to_excel('output.xlsx', sheet_name='Results')JSON 파일 다루기

웹에서 데이터를 가져올 때 자주 사용하는 JSON 형식도 지원해:

# JSON 파일 읽기

df = pd.read_json('data.json')

# JSON 파일로 저장하기

df.to_json('output.json')SQL 데이터베이스 연결하기

2025년에는 데이터베이스 연결이 더욱 간편해졌어! SQLAlchemy를 사용하면 다양한 데이터베이스에 쉽게 연결할 수 있지.

from sqlalchemy import create_engine

# 데이터베이스 연결

engine = create_engine('sqlite:///mydatabase.db')

# SQL 쿼리 실행하여 DataFrame으로 가져오기

df = pd.read_sql("SELECT * FROM users", engine)

# DataFrame을 데이터베이스 테이블로 저장하기

df.to_sql('new_table', engine, if_exists='replace')재능넷에서 데이터 분석 서비스를 제공하는 전문가들은 이런 다양한 데이터 소스를 능숙하게 다루는 능력이 필수적이라고 해. 특히 클라이언트마다 다른 형식의 데이터를 제공하기 때문에 이런 유연성이 중요하지! 🔄

2025년 새로운 데이터 형식 지원

최신 Pandas 버전에서는 더 많은 데이터 형식을 지원해:

- Parquet 파일 (빅데이터 환경에서 자주 사용)

- HDF5 파일 (대용량 과학 데이터)

- Feather 파일 (빠른 읽기/쓰기)

- Google BigQuery 직접 연결

- Apache Arrow 통합

# Parquet 파일 예시

df.to_parquet('data.parquet', compression='snappy')

df2 = pd.read_parquet('data.parquet')4. 데이터 탐색 및 전처리 🔍

데이터를 불러왔다면 이제 탐색하고 전처리할 차례야! 이 단계는 데이터 분석의 핵심이라고 할 수 있어.

기본 정보 확인하기

데이터셋의 기본 정보를 확인하는 방법들이야:

# 상위 5개 행 보기

print(df.head())

# 하위 5개 행 보기

print(df.tail())

# DataFrame의 기본 정보 보기

print(df.info())

# 수치형 데이터의 기본 통계량 보기

print(df.describe())

# 데이터 크기 확인

print(df.shape) # (행 수, 열 수)

# 열 이름 확인

print(df.columns)데이터를 처음 받았을 때는 항상 이런 기본 정보부터 확인하는 습관을 들이는 게 좋아!

결측치(Missing Values) 처리하기

실제 데이터에는 항상 빈 값(NaN)이 있기 마련이야. 이런 결측치를 어떻게 처리하는지 알아보자:

# 결측치 확인하기

print(df.isnull().sum()) # 각 열의 결측치 개수

# 결측치가 있는 행 제거하기

df_cleaned = df.dropna()

# 결측치 채우기

df_filled = df.fillna(0) # 0으로 채우기

df_filled2 = df.fillna(method='ffill') # 앞의 값으로 채우기

df_filled3 = df.fillna(df.mean()) # 평균값으로 채우기⚠️ 결측치를 무조건 제거하는 것은 좋지 않아! 데이터의 특성과 결측 패턴을 이해하고 적절한 방법을 선택해야 해.

중복 데이터 처리하기

중복된 행이 있는지 확인하고 제거하는 방법이야:

# 중복 행 확인하기

print(df.duplicated().sum()) # 중복 행 개수

# 중복 행 제거하기

df_unique = df.drop_duplicates()데이터 타입 변환하기

때로는 데이터 타입을 변환해야 할 필요가 있어:

# 데이터 타입 확인

print(df.dtypes)

# 특정 열의 데이터 타입 변환

df['age'] = df['age'].astype(int)

df['date'] = pd.to_datetime(df['date']) # 문자열을 날짜로 변환이상치(Outliers) 처리하기

데이터에는 종종 극단적인 값들이 존재해. 이런 이상치를 찾고 처리하는 방법을 알아보자:

# 박스플롯으로 이상치 시각적으로 확인

import matplotlib.pyplot as plt

df.boxplot(column=['salary'])

plt.show()

# IQR 방법으로 이상치 찾기

Q1 = df['salary'].quantile(0.25)

Q3 = df['salary'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

# 이상치 필터링

outliers = df[(df['salary'] < lower_bound) | (df['salary'] > upper_bound)]

df_no_outliers = df[(df['salary'] >= lower_bound) & (df['salary'] <= upper_bound)]5. 데이터 변환 및 집계 🔄

이제 데이터를 변환하고 집계하는 방법을 알아볼 차례야. Pandas의 진짜 강력한 기능들이 여기 있어!

열 선택 및 필터링

필요한 열만 선택하거나 조건에 맞는 데이터를 필터링하는 방법이야:

# 특정 열 선택하기

df_selected = df[['name', 'age', 'salary']]

# 조건에 맞는 행 필터링하기

high_salary = df[df['salary'] > 50000]

young_devs = df[(df['age'] < 30) & (df['job'] == '개발자')]

# query 메서드 사용하기 (2025년에 더 최적화됨)

experienced = df.query('experience > 5 and job == "데이터 과학자"')새로운 열 추가하기

기존 데이터를 기반으로 새로운 열을 만들 수 있어:

# 간단한 계산으로 새 열 추가

df['bonus'] = df['salary'] * 0.1

# apply 함수로 복잡한 로직 적용

def calculate_tax(salary):

if salary < 30000:

return salary * 0.15

else:

return salary * 0.25

df['tax'] = df['salary'].apply(calculate_tax)

# lambda 함수 사용

df['age_group'] = df['age'].apply(lambda x: '청년' if x < 30 else '중년' if x < 50 else '장년')2025년 Pandas는 apply 함수의 성능이 크게 개선되었어. 하지만 여전히 대용량 데이터에서는 벡터화된 연산을 사용하는 것이 더 빠르다는 점을 기억해!

데이터 정렬하기

데이터를 특정 열을 기준으로 정렬할 수 있어:

# 단일 열로 정렬

df_sorted = df.sort_values('salary', ascending=False) # 내림차순

# 여러 열로 정렬

df_multi_sorted = df.sort_values(['department', 'salary'], ascending=[True, False])그룹화 및 집계

그룹화는 Pandas의 가장 강력한 기능 중 하나야! SQL의 GROUP BY와 비슷하게 데이터를 그룹화하고 집계할 수 있어:

# 부서별 평균 급여 계산

dept_salary = df.groupby('department')['salary'].mean()

# 여러 열로 그룹화하고 다양한 집계 함수 적용

summary = df.groupby(['department', 'job']).agg({

'salary': ['mean', 'min', 'max', 'count'],

'age': ['mean', 'min', 'max'],

'experience': 'mean'

})

# 2025년 새로운 기능: 그룹화 결과에 직접 필터 적용

large_depts = df.groupby('department').filter(lambda x: len(x) > 10)피벗 테이블

엑셀의 피벗 테이블처럼 데이터를 재구성할 수 있어:

# 피벗 테이블 만들기

pivot = df.pivot_table(

values='salary',

index='department',

columns='job',

aggfunc='mean',

fill_value=0

)

print(pivot)데이터 병합하기

여러 데이터프레임을 합치는 방법이야:

# 두 데이터프레임 병합 (SQL JOIN과 유사)

merged = pd.merge(df1, df2, on='employee_id', how='inner')

# 다양한 조인 방식

left_join = pd.merge(df1, df2, on='employee_id', how='left')

right_join = pd.merge(df1, df2, on='employee_id', how='right')

outer_join = pd.merge(df1, df2, on='employee_id', how='outer')

# 데이터프레임 연결하기 (행 방향)

concatenated = pd.concat([df1, df2, df3], axis=0)

# 데이터프레임 연결하기 (열 방향)

wide_df = pd.concat([df1, df2, df3], axis=1)이런 데이터 변환 기술들은 재능넷에서 데이터 분석 서비스를 제공하는 전문가들이 자주 사용하는 기법들이야. 실제 프로젝트에서는 이런 기술들을 조합해서 복잡한 데이터 파이프라인을 구축하게 될 거야! 🛠️

6. 데이터 시각화 기초 📊

데이터를 분석했다면 이제 시각화할 차례야! Pandas는 Matplotlib과 연동되어 기본적인 시각화 기능을 제공해.

Pandas 내장 시각화 기능

복잡한 코드 없이도 기본적인 차트를 그릴 수 있어:

# 선 그래프

df['salary'].plot(kind='line')

# 막대 그래프

df['department'].value_counts().plot(kind='bar')

# 히스토그램

df['age'].plot(kind='hist', bins=10)

# 산점도

df.plot.scatter(x='experience', y='salary')

# 박스 플롯

df.boxplot(column='salary', by='department')2025년 Pandas는 더 다양한 시각화 옵션과 스타일을 지원해. 특히 인터랙티브 차트 기능이 크게 향상되었어!

Matplotlib과 Seaborn 활용하기

더 복잡하고 아름다운 시각화를 위해 외부 라이브러리를 활용할 수 있어:

import matplotlib.pyplot as plt

import seaborn as sns

# Matplotlib으로 그래프 그리기

plt.figure(figsize=(10, 6))

plt.plot(df['date'], df['value'])

plt.title('시간에 따른 값의 변화')

plt.xlabel('날짜')

plt.ylabel('값')

plt.grid(True)

plt.show()

# Seaborn으로 고급 시각화

plt.figure(figsize=(12, 8))

sns.heatmap(df.corr(), annot=True, cmap='coolwarm')

plt.title('변수 간 상관관계')

plt.show()

# 페어플롯

sns.pairplot(df[['age', 'salary', 'experience', 'satisfaction']])

plt.show()데이터 시각화는 분석 결과를 효과적으로 전달하는 핵심 스킬이야. 특히 비전문가에게 데이터 인사이트를 설명할 때 시각화는 필수적이지! 📈

7. 고급 Pandas 기능과 팁 🔥

이제 Pandas의 더 고급 기능들을 살펴볼 차례야. 이 기능들을 마스터하면 데이터 분석 작업이 훨씬 효율적이고 강력해질 거야!

다중 인덱스(MultiIndex)

복잡한 데이터를 계층적으로 구성할 수 있는 다중 인덱스 기능이야:

# 다중 인덱스 생성

arrays = [

['서울', '서울', '부산', '부산', '인천', '인천'],

['남성', '여성', '남성', '여성', '남성', '여성']

]

index = pd.MultiIndex.from_arrays(arrays, names=('지역', '성별'))

df_multi = pd.DataFrame({'인구수': [1000, 1200, 800, 900, 700, 750]}, index=index)

print(df_multi)

# 다중 인덱스 선택

seoul_data = df_multi.loc['서울']

male_data = df_multi.xs('남성', level='성별')다중 인덱스는 복잡한 데이터를 효율적으로 구조화할 수 있게 해주는 강력한 기능이야. 특히 그룹화된 데이터를 다룰 때 유용해!

시계열 데이터 처리

Pandas는 시계열 데이터 처리에 특화된 기능들을 제공해:

# 날짜 범위 생성

dates = pd.date_range(start='2025-01-01', end='2025-12-31', freq='D')

# 시계열 데이터 리샘플링

monthly_data = df.resample('M', on='date').mean() # 월별 평균

weekly_data = df.resample('W', on='date').sum() # 주별 합계

# 시프트 및 롤링 연산

df['previous_day'] = df['value'].shift(1) # 이전 날짜 값

df['rolling_mean'] = df['value'].rolling(window=7).mean() # 7일 이동 평균범주형(Categorical) 데이터

메모리 사용량을 줄이고 성능을 향상시키는 범주형 데이터 타입이야:

# 범주형 데이터 변환

df['department'] = df['department'].astype('category')

# 순서가 있는 범주형 데이터

df['size'] = pd.Categorical(df['size'], categories=['소', '중', '대'], ordered=True)

# 범주형 데이터 비교

large_items = df[df['size'] > '중']💡 범주형 데이터는 반복되는 문자열 값이 많은 열에 사용하면 메모리 사용량을 크게 줄일 수 있어! 특히 대용량 데이터셋에서 효과적이지.

성능 최적화 팁

대용량 데이터를 다룰 때 성능을 향상시키는 방법들이야:

- 적절한 데이터 타입 사용: int64 대신 int32, float64 대신 float32 사용

- 불필요한 열 제거: 분석에 필요한 열만 선택해서 메모리 사용량 줄이기

- 청크 단위 처리: 대용량 파일을 청크 단위로 읽고 처리하기

- 벡터화된 연산 사용: 반복문 대신 벡터화된 연산 활용

- 인플레이스 연산 활용: inplace=True 옵션으로 메모리 효율성 높이기

# 청크 단위로 대용량 CSV 파일 처리하기

chunks = []

for chunk in pd.read_csv('huge_file.csv', chunksize=10000):

# 각 청크 처리

processed = chunk[chunk['value'] > 0].copy()

chunks.append(processed)

# 처리된 청크 합치기

result = pd.concat(chunks)

# 벡터화된 연산 예시

# 느린 방법:

for i in range(len(df)):

df.loc[i, 'new_col'] = df.loc[i, 'col1'] + df.loc[i, 'col2']

# 빠른 방법:

df['new_col'] = df['col1'] + df['col2']Pandas 확장 기능

2025년에는 Pandas 생태계가 더욱 확장되어 다양한 확장 기능을 제공해:

# pandas-profiling: 자동 데이터 프로파일링

from pandas_profiling import ProfileReport

profile = ProfileReport(df, title="데이터셋 프로파일 리포트")

profile.to_file("report.html")

# pandarallel: 병렬 처리로 성능 향상

from pandarallel import pandarallel

pandarallel.initialize()

df['complex_calc'] = df['value'].parallel_apply(complex_function)

# GeoPandas: 지리 데이터 처리

import geopandas as gpd

world = gpd.read_file(gpd.datasets.get_path('naturalearth_lowres'))

cities = gpd.GeoDataFrame(

df, geometry=gpd.points_from_xy(df.longitude, df.latitude)

)이런 고급 기능들은 재능넷에서 데이터 분석 서비스를 제공하는 전문가들이 복잡한 프로젝트를 효율적으로 처리하는 데 큰 도움이 돼. 특히 대용량 데이터를 다루는 프로젝트에서는 이런 최적화 기법이 필수적이지! 🚀

8. 실전 프로젝트: 데이터 분석 워크플로우 🛠️

지금까지 배운 내용을 종합해서 실제 데이터 분석 프로젝트를 진행해보자! 여기서는 가상의 전자상거래 데이터를 분석하는 예제를 살펴볼 거야.

1단계: 데이터 로드 및 탐색

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

# 데이터 로드

sales_df = pd.read_csv('ecommerce_sales_2025.csv')

# 기본 정보 확인

print(sales_df.info())

print(sales_df.describe())

# 처음 몇 행 확인

print(sales_df.head())

# 결측치 확인

print(sales_df.isnull().sum())2단계: 데이터 전처리

# 날짜 열을 datetime 타입으로 변환

sales_df['order_date'] = pd.to_datetime(sales_df['order_date'])

# 결측치 처리

sales_df['discount'] = sales_df['discount'].fillna(0)

sales_df['customer_age'] = sales_df['customer_age'].fillna(sales_df['customer_age'].median())

# 이상치 처리

Q1 = sales_df['order_amount'].quantile(0.25)

Q3 = sales_df['order_amount'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

sales_df = sales_df[(sales_df['order_amount'] >= lower_bound) &

(sales_df['order_amount'] <= upper_bound)]

# 새로운 특성 생성

sales_df['year_month'] = sales_df['order_date'].dt.to_period('M')

sales_df['day_of_week'] = sales_df['order_date'].dt.day_name()

sales_df['is_weekend'] = sales_df['day_of_week'].isin(['Saturday', 'Sunday'])

sales_df['net_amount'] = sales_df['order_amount'] * (1 - sales_df['discount'])3단계: 데이터 분석 및 시각화

# 월별 매출 추이 분석

monthly_sales = sales_df.groupby('year_month')['net_amount'].sum().reset_index()

monthly_sales['year_month'] = monthly_sales['year_month'].astype(str)

plt.figure(figsize=(12, 6))

sns.barplot(x='year_month', y='net_amount', data=monthly_sales)

plt.title('월별 매출 추이')

plt.xlabel('연월')

plt.ylabel('순 매출액')

plt.xticks(rotation=45)

plt.tight_layout()

plt.show()

# 카테고리별 매출 분석

category_sales = sales_df.groupby('product_category')['net_amount'].sum().sort_values(ascending=False)

plt.figure(figsize=(10, 6))

category_sales.plot(kind='pie', autopct='%1.1f%%')

plt.title('카테고리별 매출 비중')

plt.ylabel('')

plt.show()

# 요일별 주문 패턴

day_order = ['Monday', 'Tuesday', 'Wednesday', 'Thursday', 'Friday', 'Saturday', 'Sunday']

day_counts = sales_df['day_of_week'].value_counts().reindex(day_order)

plt.figure(figsize=(10, 6))

sns.barplot(x=day_counts.index, y=day_counts.values)

plt.title('요일별 주문 건수')

plt.xlabel('요일')

plt.ylabel('주문 건수')

plt.show()

# 고객 연령대별 분석

sales_df['age_group'] = pd.cut(sales_df['customer_age'],

bins=[0, 18, 25, 35, 45, 55, 65, 100],

labels=['0-18', '19-25', '26-35', '36-45', '46-55', '56-65', '65+'])

age_sales = sales_df.groupby('age_group')['net_amount'].sum()

plt.figure(figsize=(10, 6))

age_sales.plot(kind='bar')

plt.title('연령대별 매출액')

plt.xlabel('연령대')

plt.ylabel('순 매출액')

plt.show()4단계: 고급 분석 - 고객 세그먼트 및 RFM 분석

# RFM(Recency, Frequency, Monetary) 분석

# 데이터 기준일 설정

today = sales_df['order_date'].max() + pd.Timedelta(days=1)

# 고객별 RFM 지표 계산

rfm = sales_df.groupby('customer_id').agg({

'order_date': lambda x: (today - x.max()).days, # Recency

'order_id': 'nunique', # Frequency

'net_amount': 'sum' # Monetary

}).rename(columns={

'order_date': 'recency',

'order_id': 'frequency',

'net_amount': 'monetary'

})

# RFM 점수 계산 (1-5점)

rfm['r_score'] = pd.qcut(rfm['recency'], q=5, labels=[5, 4, 3, 2, 1])

rfm['f_score'] = pd.qcut(rfm['frequency'].rank(method='first'), q=5, labels=[1, 2, 3, 4, 5])

rfm['m_score'] = pd.qcut(rfm['monetary'], q=5, labels=[1, 2, 3, 4, 5])

# 종합 RFM 점수

rfm['rfm_score'] = rfm['r_score'].astype(int) + rfm['f_score'].astype(int) + rfm['m_score'].astype(int)

# 고객 세그먼트 정의

def segment_customer(row):

if row['rfm_score'] >= 13:

return '최우수 고객'

elif row['rfm_score'] >= 10:

return '우수 고객'

elif row['rfm_score'] >= 7:

return '일반 고객'

else:

return '관리 필요 고객'

rfm['customer_segment'] = rfm.apply(segment_customer, axis=1)

# 세그먼트별 고객 수 시각화

segment_counts = rfm['customer_segment'].value_counts()

plt.figure(figsize=(10, 6))

sns.barplot(x=segment_counts.index, y=segment_counts.values)

plt.title('고객 세그먼트 분포')

plt.xlabel('고객 세그먼트')

plt.ylabel('고객 수')

plt.show()5단계: 인사이트 도출 및 보고서 작성

# 주요 인사이트 요약

insights = {

'매출 추이': '2025년 3월부터 매출이 꾸준히 상승하는 추세를 보임',

'인기 카테고리': '전자제품(35%)과 의류(28%)가 전체 매출의 63%를 차지',

'구매 패턴': '주말(토, 일)에 전체 주문의 45%가 집중됨',

'고객 세그먼트': '전체 고객 중 15%가 최우수 고객이며, 이들이 전체 매출의 55%를 차지'

}

# 마케팅 제안

recommendations = [

'최우수 고객 대상 VIP 프로그램 강화',

'주말 특별 프로모션을 통한 매출 극대화',

'전자제품과 의류 카테고리의 교차 판매 전략 수립',

'관리 필요 고객 대상 재활성화 캠페인 실시'

]

# 보고서 출력

print("===== 전자상거래 데이터 분석 보고서 =====")

print("\n[주요 인사이트]")

for key, value in insights.items():

print(f"- {key}: {value}")

print("\n[마케팅 제안]")

for i, rec in enumerate(recommendations, 1):

print(f"{i}. {rec}")이런 실전 프로젝트는 재능넷에서 데이터 분석 서비스를 제공하는 전문가들이 실제로 수행하는 작업과 유사해. 고객의 데이터를 분석하고 유용한 인사이트를 도출하여 비즈니스 의사결정에 도움을 주는 것이 데이터 분석가의 핵심 역할이지! 📊

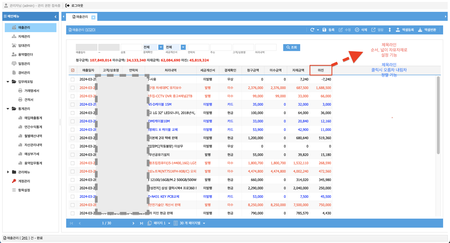

실제 프로젝트에서는 이런 분석 결과를 대시보드로 시각화하거나 자동화된 보고서로 만들어 정기적으로 업데이트하는 경우가 많아. Pandas와 함께 Dash, Streamlit 같은 도구를 활용하면 인터랙티브한 대시보드를 쉽게 만들 수 있어!

9. 2025년 Pandas 최신 기능 🚀

2025년 3월 기준으로 Pandas에 추가된 최신 기능들을 살펴보자! 이 기능들은 데이터 분석 작업을 더욱 효율적으로 만들어줄 거야.

PyArrow 통합 강화

Pandas 2.0부터 시작된 PyArrow 통합이 2025년에는 더욱 강화되었어. 이로 인해 대용량 데이터 처리 성능이 크게 향상되었지!

# PyArrow 백엔드 사용

import pandas as pd

pd.options.mode.dtype_backend = 'pyarrow'

# 대용량 CSV 파일 빠르게 읽기

df = pd.read_csv('large_file.csv', engine='pyarrow')향상된 문자열 처리

문자열 데이터 처리 성능이 크게 개선되었어:

# 새로운 문자열 메서드

df['clean_text'] = df['text'].str.remove_diacritics() # 발음 구별 기호 제거

df['normalized'] = df['text'].str.normalize('NFKC') # 유니코드 정규화

# 정규식 성능 향상

df['has_email'] = df['text'].str.contains(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b', regex=True)병렬 처리 내장 지원

외부 라이브러리 없이도 Pandas 자체적으로 병렬 처리를 지원해:

# 병렬 처리 활성화

pd.options.compute.use_parallel = True

pd.options.compute.n_threads = 8 # 사용할 스레드 수 지정

# 병렬 처리로 그룹화 연산 수행

result = df.groupby('category').parallel_apply(complex_function)메모리 사용량 최적화

대용량 데이터셋을 더 효율적으로 처리할 수 있는 기능이 추가되었어:

# 메모리 사용량 모니터링

print(df.memory_usage(deep=True))

# 자동 데이터 타입 최적화

df_optimized = pd.optimize_dtypes(df) # 새로운 함수!

# 지연 평가(Lazy Evaluation) 지원

with pd.eval_mode():

result = (df['A'] + df['B']) * (df['C'] - df['D'])향상된 그룹화 및 집계 기능

그룹화 및 집계 작업이 더 유연하고 강력해졌어:

# 새로운 집계 함수

df.groupby('category').agg({

'sales': ['mean', 'median', 'skew', 'kurtosis'], # 새로운 통계 함수

'quantity': ['sum', 'nunique', 'sem'] # 표준 오차 계산

})

# 롤링 윈도우 개선

df['rolling_3d'] = df.groupby('id')['value'].rolling('3D', min_periods=1).mean()향상된 시각화 기능

내장 시각화 기능이 더욱 강력해졌어:

# 인터랙티브 시각화 지원

df.plot(kind='line', backend='plotly') # Plotly 백엔드 사용

# 새로운 차트 유형

df.plot(kind='ridgeline') # 릿지라인 플롯

df.plot(kind='violin') # 바이올린 플롯SQL과의 통합 강화

SQL 쿼리와 Pandas의 통합이 더욱 강화되었어:

# DataFrame에서 직접 SQL 쿼리 실행

result = pd.sql_query("SELECT category, SUM(sales) as total_sales FROM df GROUP BY category", locals())이런 최신 기능들은 재능넷에서 데이터 분석 서비스를 제공하는 전문가들이 더 효율적으로 작업할 수 있게 도와줘. 특히 대용량 데이터를 다루는 프로젝트에서 성능 향상은 매우 중요하지! 🔄

⚠️ 최신 기능을 사용하려면 Pandas 버전을 최신으로 유지하는 것이 중요해! 특히 프로덕션 환경에서는 호환성 문제를 고려해서 업그레이드 계획을 세워야 해.

10. 다음 단계와 학습 자원 📚

Pandas를 더 깊이 배우고 싶다면 다음 자원들을 참고해봐!

추천 학습 자원

- 공식 문서: Pandas 공식 문서는 가장 정확하고 최신 정보를 제공해

- 온라인 강좌: Coursera, Udemy, DataCamp 등에서 제공하는 데이터 분석 강좌

- 책: "Python for Data Analysis"(Wes McKinney 저) - Pandas 창시자가 직접 쓴 책!

- GitHub: 다양한 Pandas 프로젝트와 예제 코드

- 블로그: 데이터 과학 블로그와 튜토리얼

다음 단계로 배울 만한 기술

- 데이터 시각화 심화: Matplotlib, Seaborn, Plotly 등

- 머신러닝: Scikit-learn, TensorFlow, PyTorch

- 빅데이터 처리: Dask, PySpark, Vaex

- 웹 대시보드: Dash, Streamlit, Gradio

- 통계 분석: StatsModels, SciPy

데이터 과학은 계속 발전하는 분야야. 지속적인 학습과 실습이 성공의 열쇠야!

실전 프로젝트 아이디어

배운 내용을 활용할 수 있는 프로젝트 아이디어를 소개할게:

- 개인 재무 분석: 자신의 지출 데이터를 분석하고 시각화하기

- 주식 시장 데이터 분석: 주가 데이터를 분석하고 트렌드 파악하기

- 코로나19 데이터 분석: 공개된 코로나19 데이터셋으로 트렌드 분석하기

- 영화/음악 추천 시스템: 사용자 평점 데이터를 기반으로 추천 시스템 만들기

- 소셜 미디어 감성 분석: 트위터 등의 데이터를 수집하고 감성 분석하기

재능넷에서는 이런 데이터 분석 프로젝트를 의뢰하거나, 반대로 데이터 분석 전문가로 활동할 수도 있어. 실제 프로젝트 경험은 스킬을 향상시키는 가장 좋은 방법이지! 🚀

📚 목차

- Pandas 소개와 기본 개념

- 데이터 구조: Series와 DataFrame

- 데이터 불러오기와 내보내기

- 데이터 탐색 및 전처리

- 데이터 변환 및 집계

- 데이터 시각화 기초

- 고급 Pandas 기능과 팁

- 실전 프로젝트: 데이터 분석 워크플로우

- 2025년 Pandas 최신 기능

- 다음 단계와 학습 자원

1. Pandas 소개와 기본 개념 🐼

Pandas는 2008년 웨스 맥키니(Wes McKinney)가 개발한 오픈소스 데이터 분석 라이브러리야. 이름은 'Panel Data'에서 따왔고, 귀여운 판다 🐼 마스코트로도 유명하지!

2025년 현재 Pandas는 버전 2.2.x로 업데이트되어 더욱 강력한 성능과 새로운 기능들을 제공하고 있어.

Pandas를 사용하는 이유

엑셀이나 SQL 같은 도구도 있는데 왜 Pandas를 배워야 할까? 🤔

- 대용량 데이터 처리 가능 (수백만 행의 데이터도 빠르게!)

- 강력한 데이터 조작 및 분석 기능

- 다양한 형식의 데이터 파일 지원 (CSV, Excel, SQL, JSON 등)

- 데이터 시각화와의 원활한 통합

- 파이썬 생태계의 다른 도구들과 완벽한 호환

특히 데이터 과학 분야에서 일하고 싶다면 Pandas는 필수 스킬이라고 할 수 있어. 재능넷에서도 데이터 분석 관련 재능을 공유하는 분들이 Pandas를 많이 활용한다고 해!

Pandas 설치하기

시작하기 전에 Pandas를 설치해야겠지? 터미널이나 명령 프롬프트에서 아래 명령어를 실행해봐:

pip install pandas아나콘다(Anaconda)를 사용한다면:

conda install pandas2025년 최신 버전을 설치하려면:

pip install pandas==2.2.02. 데이터 구조: Series와 DataFrame 📊

Pandas의 핵심은 두 가지 데이터 구조야. Series와 DataFrame이 바로 그것!

Series: 1차원 배열

Series는 1차원 배열과 같은 구조로, 인덱스가 있는 데이터의 시퀀스야. 넘파이 배열이나 파이썬 리스트와 비슷하지만, 각 요소에 레이블(인덱스)을 붙일 수 있다는 점이 특별해!

import pandas as pd

import numpy as np

# Series 생성하기

s = pd.Series([1, 3, 5, np.nan, 6, 8])

print(s)

# 인덱스 지정하기

s2 = pd.Series([10, 20, 30, 40], index=['a', 'b', 'c', 'd'])

print(s2)결과는 이렇게 나와:

0 1.0

1 3.0

2 5.0

3 NaN

4 6.0

5 8.0

dtype: float64

a 10

b 20

c 30

d 40

dtype: int64DataFrame: 2차원 테이블

DataFrame은 Pandas의 진짜 주인공! 엑셀 스프레드시트나 SQL 테이블과 같은 2차원 데이터 구조로, 여러 개의 Series가 모여 만들어진다고 생각하면 돼.

# DataFrame 생성하기

df = pd.DataFrame({

'이름': ['김데이터', '박분석', '이파이썬', '최판다스'],

'나이': [25, 30, 28, 22],

'직업': ['데이터 과학자', '개발자', '분석가', '학생']

})

print(df)결과:

이름 나이 직업

0 김데이터 25 데이터 과학자

1 박분석 30 개발자

2 이파이썬 28 분석가

3 최판다스 22 학생DataFrame은 다양한 방법으로 생성할 수 있어:

- 딕셔너리로부터 생성

- 리스트의 리스트로부터 생성

- 다른 DataFrame으로부터 생성

- 외부 파일(CSV, Excel 등)에서 데이터 읽어오기

# 날짜 범위로 DataFrame 만들기

dates = pd.date_range('20250301', periods=6)

df2 = pd.DataFrame(np.random.randn(6, 4), index=dates, columns=list('ABCD'))

print(df2)이렇게 날짜를 인덱스로 사용하면 시계열 데이터를 다루기 정말 편리해져! 🕒

3. 데이터 불러오기와 내보내기 📂

실제 데이터 분석에서는 외부 파일에서 데이터를 불러오는 경우가 대부분이야. Pandas는 다양한 형식의 파일을 쉽게 처리할 수 있어!

CSV 파일 다루기

CSV(Comma-Separated Values)는 가장 흔한 데이터 형식 중 하나야.

# CSV 파일 읽기

df = pd.read_csv('data.csv')

# CSV 파일로 저장하기

df.to_csv('output.csv', index=False)💡 index=False 옵션을 사용하면 인덱스 열을 저장하지 않아서 더 깔끔한 CSV 파일을 만들 수 있어!

Excel 파일 다루기

엑셀 파일도 쉽게 처리할 수 있어. 단, openpyxl 또는 xlrd 패키지를 먼저 설치해야 해.

# Excel 파일 읽기

df = pd.read_excel('data.xlsx', sheet_name='Sheet1')

# Excel 파일로 저장하기

df.to_excel('output.xlsx', sheet_name='Results')JSON 파일 다루기

웹에서 데이터를 가져올 때 자주 사용하는 JSON 형식도 지원해:

# JSON 파일 읽기

df = pd.read_json('data.json')

# JSON 파일로 저장하기

df.to_json('output.json')SQL 데이터베이스 연결하기

2025년에는 데이터베이스 연결이 더욱 간편해졌어! SQLAlchemy를 사용하면 다양한 데이터베이스에 쉽게 연결할 수 있지.

from sqlalchemy import create_engine

# 데이터베이스 연결

engine = create_engine('sqlite:///mydatabase.db')

# SQL 쿼리 실행하여 DataFrame으로 가져오기

df = pd.read_sql("SELECT * FROM users", engine)

# DataFrame을 데이터베이스 테이블로 저장하기

df.to_sql('new_table', engine, if_exists='replace')재능넷에서 데이터 분석 서비스를 제공하는 전문가들은 이런 다양한 데이터 소스를 능숙하게 다루는 능력이 필수적이라고 해. 특히 클라이언트마다 다른 형식의 데이터를 제공하기 때문에 이런 유연성이 중요하지! 🔄

2025년 새로운 데이터 형식 지원

최신 Pandas 버전에서는 더 많은 데이터 형식을 지원해:

- Parquet 파일 (빅데이터 환경에서 자주 사용)

- HDF5 파일 (대용량 과학 데이터)

- Feather 파일 (빠른 읽기/쓰기)

- Google BigQuery 직접 연결

- Apache Arrow 통합

# Parquet 파일 예시

df.to_parquet('data.parquet', compression='snappy')

df2 = pd.read_parquet('data.parquet')4. 데이터 탐색 및 전처리 🔍

데이터를 불러왔다면 이제 탐색하고 전처리할 차례야! 이 단계는 데이터 분석의 핵심이라고 할 수 있어.

기본 정보 확인하기

데이터셋의 기본 정보를 확인하는 방법들이야:

# 상위 5개 행 보기

print(df.head())

# 하위 5개 행 보기

print(df.tail())

# DataFrame의 기본 정보 보기

print(df.info())

# 수치형 데이터의 기본 통계량 보기

print(df.describe())

# 데이터 크기 확인

print(df.shape) # (행 수, 열 수)

# 열 이름 확인

print(df.columns)데이터를 처음 받았을 때는 항상 이런 기본 정보부터 확인하는 습관을 들이는 게 좋아!

결측치(Missing Values) 처리하기

실제 데이터에는 항상 빈 값(NaN)이 있기 마련이야. 이런 결측치를 어떻게 처리하는지 알아보자:

# 결측치 확인하기

print(df.isnull().sum()) # 각 열의 결측치 개수

# 결측치가 있는 행 제거하기

df_cleaned = df.dropna()

# 결측치 채우기

df_filled = df.fillna(0) # 0으로 채우기

df_filled2 = df.fillna(method='ffill') # 앞의 값으로 채우기

df_filled3 = df.fillna(df.mean()) # 평균값으로 채우기⚠️ 결측치를 무조건 제거하는 것은 좋지 않아! 데이터의 특성과 결측 패턴을 이해하고 적절한 방법을 선택해야 해.

중복 데이터 처리하기

중복된 행이 있는지 확인하고 제거하는 방법이야:

# 중복 행 확인하기

print(df.duplicated().sum()) # 중복 행 개수

# 중복 행 제거하기

df_unique = df.drop_duplicates()데이터 타입 변환하기

때로는 데이터 타입을 변환해야 할 필요가 있어:

# 데이터 타입 확인

print(df.dtypes)

# 특정 열의 데이터 타입 변환

df['age'] = df['age'].astype(int)

df['date'] = pd.to_datetime(df['date']) # 문자열을 날짜로 변환이상치(Outliers) 처리하기

데이터에는 종종 극단적인 값들이 존재해. 이런 이상치를 찾고 처리하는 방법을 알아보자:

# 박스플롯으로 이상치 시각적으로 확인

import matplotlib.pyplot as plt

df.boxplot(column=['salary'])

plt.show()

# IQR 방법으로 이상치 찾기

Q1 = df['salary'].quantile(0.25)

Q3 = df['salary'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

# 이상치 필터링

outliers = df[(df['salary'] < lower_bound) | (df['salary'] > upper_bound)]

df_no_outliers = df[(df['salary'] >= lower_bound) & (df['salary'] <= upper_bound)]5. 데이터 변환 및 집계 🔄

이제 데이터를 변환하고 집계하는 방법을 알아볼 차례야. Pandas의 진짜 강력한 기능들이 여기 있어!

열 선택 및 필터링

필요한 열만 선택하거나 조건에 맞는 데이터를 필터링하는 방법이야:

# 특정 열 선택하기

df_selected = df[['name', 'age', 'salary']]

# 조건에 맞는 행 필터링하기

high_salary = df[df['salary'] > 50000]

young_devs = df[(df['age'] < 30) & (df['job'] == '개발자')]

# query 메서드 사용하기 (2025년에 더 최적화됨)

experienced = df.query('experience > 5 and job == "데이터 과학자"')새로운 열 추가하기

기존 데이터를 기반으로 새로운 열을 만들 수 있어:

# 간단한 계산으로 새 열 추가

df['bonus'] = df['salary'] * 0.1

# apply 함수로 복잡한 로직 적용

def calculate_tax(salary):

if salary < 30000:

return salary * 0.15

else:

return salary * 0.25

df['tax'] = df['salary'].apply(calculate_tax)

# lambda 함수 사용

df['age_group'] = df['age'].apply(lambda x: '청년' if x < 30 else '중년' if x < 50 else '장년')2025년 Pandas는 apply 함수의 성능이 크게 개선되었어. 하지만 여전히 대용량 데이터에서는 벡터화된 연산을 사용하는 것이 더 빠르다는 점을 기억해!

데이터 정렬하기

데이터를 특정 열을 기준으로 정렬할 수 있어:

# 단일 열로 정렬

df_sorted = df.sort_values('salary', ascending=False) # 내림차순

# 여러 열로 정렬

df_multi_sorted = df.sort_values(['department', 'salary'], ascending=[True, False])그룹화 및 집계

그룹화는 Pandas의 가장 강력한 기능 중 하나야! SQL의 GROUP BY와 비슷하게 데이터를 그룹화하고 집계할 수 있어:

# 부서별 평균 급여 계산

dept_salary = df.groupby('department')['salary'].mean()

# 여러 열로 그룹화하고 다양한 집계 함수 적용

summary = df.groupby(['department', 'job']).agg({

'salary': ['mean', 'min', 'max', 'count'],

'age': ['mean', 'min', 'max'],

'experience': 'mean'

})

# 2025년 새로운 기능: 그룹화 결과에 직접 필터 적용

large_depts = df.groupby('department').filter(lambda x: len(x) > 10)피벗 테이블

엑셀의 피벗 테이블처럼 데이터를 재구성할 수 있어:

# 피벗 테이블 만들기

pivot = df.pivot_table(

values='salary',

index='department',

columns='job',

aggfunc='mean',

fill_value=0

)

print(pivot)데이터 병합하기

여러 데이터프레임을 합치는 방법이야:

# 두 데이터프레임 병합 (SQL JOIN과 유사)

merged = pd.merge(df1, df2, on='employee_id', how='inner')

# 다양한 조인 방식

left_join = pd.merge(df1, df2, on='employee_id', how='left')

right_join = pd.merge(df1, df2, on='employee_id', how='right')

outer_join = pd.merge(df1, df2, on='employee_id', how='outer')

# 데이터프레임 연결하기 (행 방향)

concatenated = pd.concat([df1, df2, df3], axis=0)

# 데이터프레임 연결하기 (열 방향)

wide_df = pd.concat([df1, df2, df3], axis=1)이런 데이터 변환 기술들은 재능넷에서 데이터 분석 서비스를 제공하는 전문가들이 자주 사용하는 기법들이야. 실제 프로젝트에서는 이런 기술들을 조합해서 복잡한 데이터 파이프라인을 구축하게 될 거야! 🛠️

- 지식인의 숲 - 지적 재산권 보호 고지

지적 재산권 보호 고지

- 저작권 및 소유권: 본 컨텐츠는 재능넷의 독점 AI 기술로 생성되었으며, 대한민국 저작권법 및 국제 저작권 협약에 의해 보호됩니다.

- AI 생성 컨텐츠의 법적 지위: 본 AI 생성 컨텐츠는 재능넷의 지적 창작물로 인정되며, 관련 법규에 따라 저작권 보호를 받습니다.

- 사용 제한: 재능넷의 명시적 서면 동의 없이 본 컨텐츠를 복제, 수정, 배포, 또는 상업적으로 활용하는 행위는 엄격히 금지됩니다.

- 데이터 수집 금지: 본 컨텐츠에 대한 무단 스크래핑, 크롤링, 및 자동화된 데이터 수집은 법적 제재의 대상이 됩니다.

- AI 학습 제한: 재능넷의 AI 생성 컨텐츠를 타 AI 모델 학습에 무단 사용하는 행위는 금지되며, 이는 지적 재산권 침해로 간주됩니다.

재능넷은 최신 AI 기술과 법률에 기반하여 자사의 지적 재산권을 적극적으로 보호하며,

무단 사용 및 침해 행위에 대해 법적 대응을 할 권리를 보유합니다.

© 2025 재능넷 | All rights reserved.

댓글 0개