🐍 Python 데이터 클리닝: 깨끗한 데이터로 정확한 분석하기 🧹

안녕, 파이썬 데이터 클리닝에 관심 있는 친구들! 오늘은 우리가 데이터 분석할 때 정말 중요한 데이터 클리닝에 대해 재미있게 얘기해볼 거야. 😊 데이터 클리닝이 뭐냐고? 간단히 말하면 더러운 데이터를 깨끗하게 만드는 과정이라고 할 수 있어. 마치 우리가 방 청소를 하는 것처럼 말이야! 🧼

데이터 분석은 요즘 정말 핫한 분야지? 그런데 아무리 좋은 분석 기술을 가지고 있어도, 데이터가 엉망이면 제대로 된 결과를 얻을 수 없어. 그래서 데이터 클리닝이 꼭 필요한 거야. 마치 요리할 때 신선한 재료가 중요한 것처럼 말이야! 🥕🍅

이 글에서는 Python을 사용해서 데이터를 클리닝하는 방법을 자세히 알아볼 거야. Python은 데이터 분석에 정말 강력한 도구인데, 특히 데이터 클리닝에도 아주 유용해. 마치 만능 청소 도구 같은 거지! 🧰

그리고 말이야, 우리가 이렇게 데이터 클리닝 스킬을 익히면 어떤 점이 좋을까? 바로 재능넷같은 플랫폼에서 우리의 실력을 뽐낼 수 있다는 거야! 데이터 분석 전문가로 활동하면서 다른 사람들의 데이터 문제를 해결해줄 수 있겠지? 😎

자, 그럼 이제 본격적으로 Python으로 데이터 클리닝하는 방법을 알아보자. 준비됐니? Let's go! 🚀

1. 데이터 클리닝이 왜 중요할까? 🤔

친구야, 잠깐 상상해봐. 네가 맛있는 케이크를 만들려고 하는데, 재료들이 다 상했다고 생각해봐. 아무리 네가 요리 실력이 뛰어나도 맛있는 케이크를 만들 수 있을까? 절대 안 되겠지? 데이터 분석도 마찬가지야. 아무리 뛰어난 분석 기술을 가지고 있어도, 데이터가 엉망이면 좋은 결과를 얻을 수 없어. 바로 이 때문에 데이터 클리닝이 정말 중요한 거야! 🍰🔍

데이터 클리닝의 중요성:

- 정확한 분석 결과 도출 👉 깨끗한 데이터 = 신뢰할 수 있는 결과

- 시간과 비용 절약 💰 클리닝된 데이터로 분석 시간 단축

- 의사결정 품질 향상 🧠 정확한 데이터로 더 나은 결정

- 데이터 품질 개선 🌟 지속적인 클리닝으로 전반적인 데이터 품질 향상

- 법적 규정 준수 ⚖️ 개인정보 보호법 등 관련 법규 준수 용이

자, 이제 데이터 클리닝이 얼마나 중요한지 알겠지? 그럼 이제 Python으로 어떻게 데이터를 클리닝하는지 자세히 알아보자. 우리가 배울 내용들은 실제로 재능넷같은 플랫폼에서 데이터 분석 전문가로 활동할 때 정말 유용하게 쓸 수 있을 거야. 준비됐니? 😊

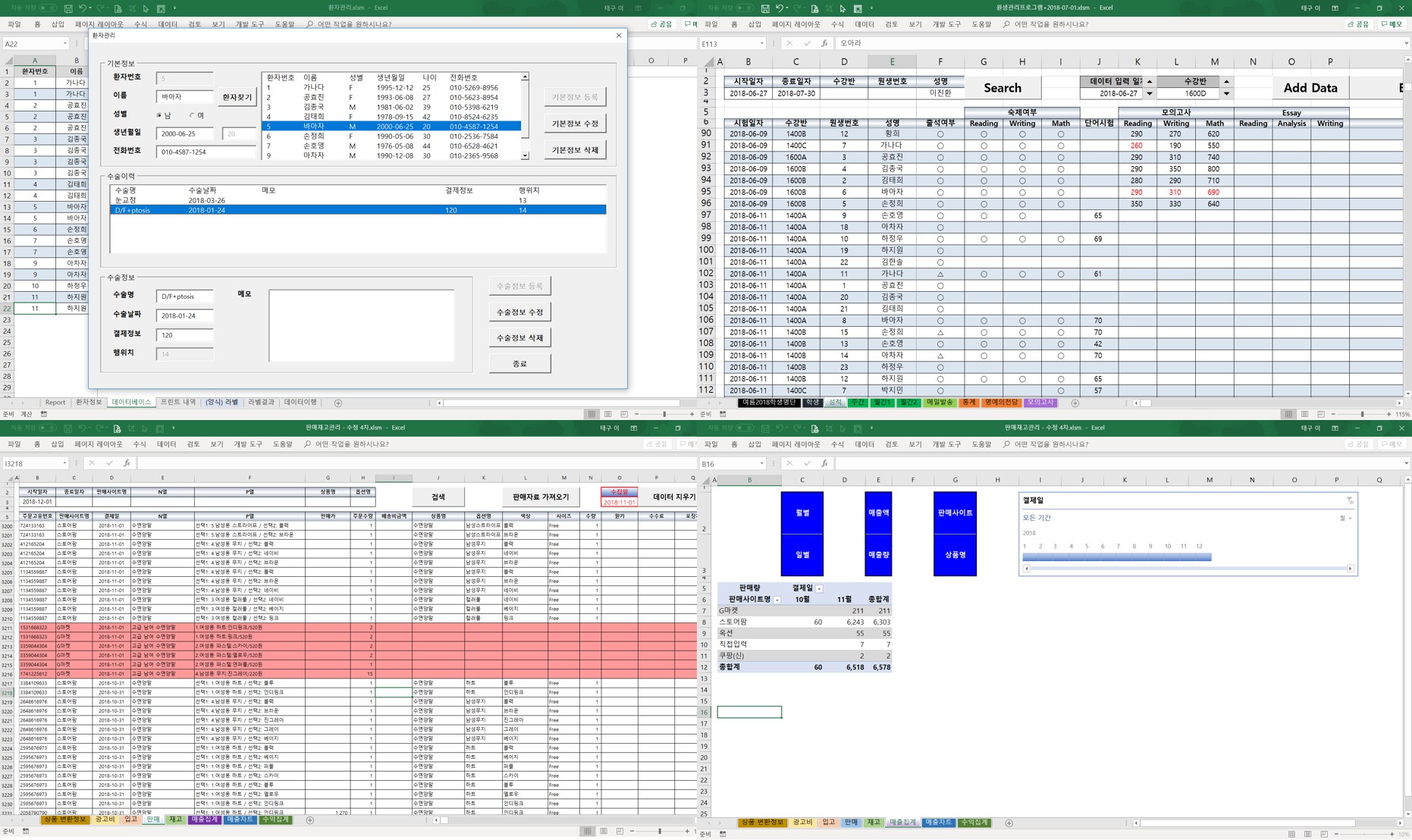

위의 그림을 보면 데이터 클리닝이 얼마나 중요한지 한눈에 알 수 있지? 정확성, 효율성, 신뢰성. 이 세 가지가 바로 데이터 클리닝의 핵심이야. 이제 우리가 Python으로 어떻게 이런 깨끗하고 신뢰할 수 있는 데이터를 만들 수 있는지 자세히 알아보자! 🕵️♂️💻

2. Python 데이터 클리닝의 기본: Pandas 라이브러리 소개 🐼

자, 이제 본격적으로 Python으로 데이터 클리닝을 시작해볼 거야. 그 전에 먼저 우리의 든든한 조력자를 소개할게. 바로 Pandas라는 라이브러리야! 🐼

Pandas는 데이터 분석과 조작을 위한 Python 라이브러리로, 특히 데이터 클리닝에 정말 유용해. 마치 데이터 청소를 위한 만능 도구 상자 같은 거지! 😊

Pandas의 주요 특징:

- 데이터프레임(DataFrame) 제공 📊 엑셀 시트와 비슷한 2차원 데이터 구조

- 강력한 데이터 조작 기능 🛠️ 필터링, 그룹화, 병합 등 다양한 기능

- 다양한 파일 형식 지원 📁 CSV, Excel, SQL 데이터베이스 등

- 결측치 처리 기능 🕳️ NaN 값 쉽게 처리

- 시계열 데이터 처리 ⏰ 날짜, 시간 데이터 다루기 쉬움

Pandas를 사용하려면 먼저 설치해야 해. 터미널이나 명령 프롬프트에서 다음 명령어를 입력하면 돼:

pip install pandas설치가 완료되면, Python 스크립트에서 다음과 같이 Pandas를 임포트할 수 있어:

import pandas as pd여기서 as pd는 Pandas를 pd라는 별칭으로 사용하겠다는 뜻이야. 이렇게 하면 코드를 작성할 때 매번 pandas를 전부 치지 않고 pd만 써도 돼서 편리해.

자, 이제 Pandas의 기본을 알았으니 실제로 어떻게 사용하는지 예제를 통해 알아보자! 🚀

Pandas로 CSV 파일 읽기

CSV(Comma-Separated Values) 파일은 데이터 분석에서 자주 사용되는 파일 형식이야. Pandas를 사용하면 이런 CSV 파일을 아주 쉽게 읽을 수 있어. 예를 들어보자:

import pandas as pd

# CSV 파일 읽기

df = pd.read_csv('data.csv')

# 데이터 확인

print(df.head())

이 코드는 'data.csv'라는 파일을 읽어서 데이터프레임으로 만들고, 그 중 앞부분 몇 행을 출력해. head() 함수는 기본적으로 처음 5행을 보여주지만, 괄호 안에 숫자를 넣어서 원하는 만큼의 행을 볼 수 있어.

데이터 기본 정보 확인하기

데이터를 클리닝하기 전에 먼저 데이터의 기본 정보를 확인하는 게 중요해. Pandas는 이를 위한 여러 유용한 함수를 제공해:

# 데이터프레임의 기본 정보 확인

print(df.info())

# 수치형 데이터의 기본 통계량 확인

print(df.describe())

# 각 열의 데이터 타입 확인

print(df.dtypes)

이런 함수들을 사용하면 데이터의 크기, 각 열의 데이터 타입, 결측치 여부, 기본 통계량 등을 한눈에 볼 수 있어. 이렇게 데이터의 전반적인 상태를 파악하고 나면, 어떤 부분을 클리닝해야 할지 감이 올 거야.

재능넷에서 데이터 분석 프로젝트를 진행할 때도 이런 기본적인 데이터 확인 과정은 정말 중요해. 클라이언트에게 받은 데이터의 상태를 빠르게 파악하고, 어떤 클리닝 작업이 필요한지 결정할 수 있거든.

간단한 데이터 클리닝 예제

자, 이제 정말 간단한 데이터 클리닝 예제를 하나 해볼게. 예를 들어, 우리가 다음과 같은 데이터프레임을 가지고 있다고 해보자:

import pandas as pd

data = {

'Name': ['John', 'Anna', 'Peter', 'Linda'],

'Age': [28, 34, None, 32],

'City': ['New York', 'Paris', 'Berlin', 'London']

}

df = pd.DataFrame(data)

print(df)

이 데이터에서 Peter의 나이(Age)가 None, 즉 결측치야. 이걸 평균 나이로 채워넣는 간단한 클리닝을 해보자:

# 평균 나이 계산 (결측치 제외)

mean_age = df['Age'].mean()

# 결측치를 평균 나이로 채우기

df['Age'] = df['Age'].fillna(mean_age)

print(df)

이렇게 하면 Peter의 나이가 다른 사람들의 평균 나이로 채워지게 돼. 물론 이건 아주 간단한 예제고, 실제 데이터 클리닝에서는 더 복잡하고 다양한 상황을 다뤄야 해.

여기까지 Pandas의 기본과 간단한 사용법을 알아봤어. 이제 너도 Pandas가 얼마나 강력하고 유용한 도구인지 알겠지? 😊 다음 섹션에서는 더 구체적인 데이터 클리닝 기법들을 자세히 알아볼 거야. 준비됐니? 계속 가보자! 🚀

위 그림은 Pandas를 이용한 기본적인 데이터 클리닝 과정을 보여줘. 데이터를 로드하고, 확인하고, 정제하는 과정이 순차적으로 이뤄지는 걸 볼 수 있지? 이제 우리는 이 과정을 더 자세히 살펴볼 거야. 다음 섹션에서 계속해서 알아보자! 💪😄

3. 결측치 처리하기: NaN 값과 싸우기 🥊

자, 이제 본격적으로 데이터 클리닝의 핵심 작업 중 하나인 결측치 처리에 대해 알아볼 거야. 결측치란 뭘까? 간단히 말해서 데이터에 빈 곳이 있는 거야. 예를 들어, 설문 조사에서 어떤 사람이 특정 질문에 대답을 안 했다면 그 부분이 결측치가 되는 거지. Python에서는 이런 결측치를 보통 NaN(Not a Number)이라고 표현해.

결측치는 데이터 분석에 큰 방해가 될 수 있어. 왜냐하면 대부분의 분석 함수들은 결측치가 있으면 제대로 작동하지 않거든. 그래서 우리는 이 결측치들을 적절하게 처리해줘야 해. 어떻게 처리하냐고? 자, 지금부터 하나씩 알아보자! 🕵️♂️

1. 결측치 확인하기

먼저 우리 데이터에 결측치가 얼마나 있는지 확인해야 해. Pandas에서는 이를 위한 편리한 함수들을 제공해:

# 결측치 개수 확인

print(df.isnull().sum())

# 결측치 비율 확인

print(df.isnull().mean())

이 코드를 실행하면 각 열마다 결측치가 몇 개인지, 그리고 전체 데이터 중 결측치의 비율이 얼마나 되는지 알 수 있어. 이렇게 결측치의 현황을 파악하고 나면, 어떤 방식으로 처리할지 결정할 수 있지.

2. 결측치 제거하기

결측치를 처리하는 가장 간단한 방법은 그냥 제거해버리는 거야. 하지만 이 방법은 데이터의 양이 많이 줄어들 수 있다는 단점이 있어. 그래도 결측치가 적은 경우에는 유용할 수 있지:

# 결측치가 있는 행 제거

df_cleaned = df.dropna()

# 특정 열에 결측치가 있는 행만 제거

df_cleaned = df.dropna(subset=['Age', 'Salary'])

dropna() 함수를 사용하면 결측치가 있는 행을 쉽게 제거할 수 있어. subset 파라미터를 사용하면 특정 열에 결측치가 있는 행만 선택적으로 제거할 수도 있지.

3. 결측치 채우기

결측치를 제거하는 대신 다른 값으로 채울 수도 있어. 이 방법은 데이터의 양을 유지할 수 있다는 장점이 있지:

# 평균값으로 채우기

df['Age'].fillna(df['Age'].mean(), inplace=True)

# 중앙값으로 채우기

df['Salary'].fillna(df['Salary'].median(), inplace=True)

# 가장 빈번한 값(최빈값)으로 채우기

df['City'].fillna(df['City'].mode()[0], inplace=True)

# 이전 값으로 채우기 (시계열 데이터에 유용)

df['Date'].fillna(method='ffill', inplace=True)

fillna() 함수를 사용하면 결측치를 다양한 방식으로 채울 수 있어. 평균값, 중앙값, 최빈값 등을 사용할 수 있고, 시계열 데이터의 경우 이전 값이나 이후 값으로 채우는 것도 가능해.

여기서 inplace=True라는 파라미터는 원본 데이터프레임을 직접 수정한다는 뜻이야. 이걸 사용하지 않으면 새로운 데이터프레임을 반환하게 돼.

4. 보간법(Interpolation) 사용하기

결측치를 주변 값들을 이용해 추정하는 방법도 있어. 이걸 보간법이라고 해:

# 선형 보간법 사용

df['Height'].interpolate(method='linear', inplace=True)

이 방법은 특히 시계열 데이터나 연속적인 수치 데이터에 유용해. 결측치 주변의 값들을 이용해 적절한 값을 추정하는 거지.

5. 고급 기법: 예측 모델 사용하기

더 복잡하지만 정확한 방법으로는 머신러닝 모델을 사용해 결측치를 예측하는 방법이 있어. 예를 들어, 다른 특성들을 이용해 나이를 예측하는 모델을 만들 수 있지:

from sklearn.impute import SimpleImputer

from sklearn.ensemble import RandomForestRegressor

# 결측치가 없는 특성들 선택

features = ['Height', 'Weight', 'Salary']

X = df[features]

y = df['Age']

# 결측치가 있는 행 제외

mask = ~X.isnull().any(axis=1) & ~y.isnull()

X_train, y_train = X[mask], y[mask]

# 랜덤 포레스트 모델 학습

model = RandomForestRegressor()

model.fit(X_train, y_train)

# 결측치 예측

X_missing = X[df['Age'].isnull()]

age_predicted = model.predict(X_missing)

# 예측값으로 결측치 채우기

df.loc[df['Age'].isnull(), 'Age'] = age_predicted

이 방법은 좀 복잡해 보일 수 있지만, 다른 특성들과의 관계를 고려해 결측치를 채우기 때문에 더 정확한 결과를 얻을 수 있어.

자, 여기까지 결측치를 처리하는 다양한 방법들을 알아봤어. 어떤 방법을 선택할지는 데이터의 특성과 분석의 목적에 따라 달라질 수 있어. 중요한 건 결측치를 그냥 무시하지 않고 적절히 처리해주는 거야. 그래야 더 정확하고 신뢰할 수 있는 분석 결과를 얻을 수 있거든! 😊

이런 결측치 처리 기술은 재능넷같은 플랫폼에서 데이터 분석 프로젝트를 할 때 정말 유용하게 쓰일 거야. 클라이언트의 데이터에 결측치가 있더라도 너는 이제 자신 있게 처리할 수 있을 거야! 💪

위 그림은 우리가 배운 결측치 처리 방법들을 한눈에 보여주고 있어. 제거, 채우기, 예측, 보간법 등 다양한 방법이 있다는 걸 기억하고, 상황에 맞는 적절한 방법을 선택하는 게 중요해. 다음 섹션에서 는 또 다른 중요한 데이터 클리닝 기법에 대해 알아볼 거야. 준비됐니? 가보자! 🚀

4. 이상치(Outlier) 처리하기: 데이터의 특이점 다루기 🎯

이번에는 이상치(Outlier)에 대해 알아볼 거야. 이상치란 다른 데이터들과 현저하게 다른 값을 가진 데이터 포인트를 말해. 예를 들어, 사람들의 키 데이터에서 300cm라는 값이 있다면 이건 아마도 이상치일 거야. 이런 이상치들은 분석 결과를 왜곡시킬 수 있기 때문에 적절히 처리해줘야 해.

1. 이상치 탐지하기

이상치를 처리하기 전에 먼저 찾아내야겠지? 이상치를 탐지하는 방법에는 여러 가지가 있어:

시각화를 통한 탐지

import matplotlib.pyplot as plt

import seaborn as sns

# 박스플롯 그리기

plt.figure(figsize=(10, 6))

sns.boxplot(x=df['Height'])

plt.title('Height Distribution')

plt.show()

# 산점도 그리기

plt.figure(figsize=(10, 6))

plt.scatter(df.index, df['Height'])

plt.title('Height Scatter Plot')

plt.ylabel('Height')

plt.show()

박스플롯이나 산점도를 그려보면 이상치를 시각적으로 쉽게 확인할 수 있어. 박스플롯에서 박스 바깥에 찍히는 점들이 바로 이상치야.

IQR(Interquartile Range) 방법

Q1 = df['Height'].quantile(0.25)

Q3 = df['Height'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

outliers = df[(df['Height'] < lower_bound) | (df['Height'] > upper_bound)]

print(outliers)

IQR 방법은 데이터의 사분위수를 이용해 이상치를 탐지해. 보통 1.5 * IQR을 넘어가는 값들을 이상치로 간주해.

Z-score 방법

from scipy import stats

z_scores = stats.zscore(df['Height'])

outliers = df[abs(z_scores) > 3]

print(outliers)

Z-score 방법은 데이터의 평균과 표준편차를 이용해 각 데이터 포인트의 z-score를 계산하고, 보통 절대값이 3을 넘는 경우를 이상치로 간주해.

2. 이상치 처리하기

이상치를 발견했다면 이제 처리해야 해. 처리 방법에는 여러 가지가 있어:

제거하기

# IQR 방법으로 이상치 제거

df = df[(df['Height'] >= lower_bound) & (df['Height'] <= upper_bound)]

# Z-score 방법으로 이상치 제거

df = df[abs(z_scores) <= 3]

이상치를 단순히 제거하는 방법이야. 하지만 이 방법은 데이터의 손실을 가져올 수 있어서 신중하게 사용해야 해.

대체하기

# 상한값, 하한값으로 대체 (Capping)

df['Height'] = df['Height'].clip(lower=lower_bound, upper=upper_bound)

# 평균값으로 대체

mean_height = df['Height'].mean()

df.loc[abs(z_scores) > 3, 'Height'] = mean_height

이상치를 다른 값으로 대체하는 방법이야. 상한값이나 하한값, 또는 평균값 등으로 대체할 수 있어.

변환하기

import numpy as np

# 로그 변환

df['Height_log'] = np.log(df['Height'])

# 제곱근 변환

df['Height_sqrt'] = np.sqrt(df['Height'])

데이터를 변환하면 이상치의 영향을 줄일 수 있어. 로그 변환이나 제곱근 변환 등이 자주 사용돼.

3. 주의사항

이상치 처리할 때 주의해야 할 점들이 있어:

- 모든 이상치가 잘못된 데이터는 아니야. 때로는 중요한 정보를 담고 있을 수 있어.

- 도메인 지식이 중요해. 예를 들어, 의료 데이터에서는 극단적인 값이 중요한 의미를 가질 수 있어.

- 이상치 처리 전후로 분석 결과가 어떻게 변하는지 확인해봐야 해.

이상치 처리는 재능넷에서 데이터 분석 프로젝트를 할 때 정말 중요한 스킬이야. 클라이언트의 데이터에 이상치가 있을 때, 너는 이제 자신 있게 처리할 수 있을 거야! 😊

위 그림은 이상치 처리의 전체적인 과정을 보여주고 있어. 탐지부터 처리, 그리고 결과 확인까지의 과정이 순차적으로 이뤄지는 걸 볼 수 있지? 그리고 이상치를 다룰 때는 시각화, 통계적 방법, 도메인 지식 등 다양한 접근 방식을 활용해야 한다는 것도 기억해!

자, 이제 우리는 결측치와 이상치 처리 방법에 대해 알아봤어. 이 두 가지는 데이터 클리닝에서 정말 중요한 부분이야. 하지만 아직 더 배울 게 있어! 다음 섹션에서는 데이터의 형식을 정리하고 일관성을 유지하는 방법에 대해 알아볼 거야. 준비됐니? 계속 가보자! 🚀

5. 데이터 형식 정리하기: 일관성은 힘이다! 💪

데이터 클리닝의 또 다른 중요한 부분은 바로 데이터 형식을 정리하는 거야. 데이터의 형식이 일관되지 않으면 분석할 때 큰 문제가 될 수 있어. 예를 들어, 날짜 데이터가 어떤 곳에서는 'YYYY-MM-DD'로, 다른 곳에서는 'MM/DD/YYYY'로 되어 있다면? 아주 혼란스럽겠지? 그래서 우리는 데이터의 형식을 일관되게 만들어줘야 해.

1. 문자열 데이터 정리하기

문자열 데이터는 특히 형식이 일정하지 않은 경우가 많아. 대소문자가 섞여 있거나, 앞뒤에 불필요한 공백이 있거나, 특수문자가 들어가 있을 수 있지. 이런 것들을 정리해보자:

# 대소문자 통일

df['Name'] = df['Name'].str.lower() # 모두 소문자로

df['Name'] = df['Name'].str.upper() # 모두 대문자로

df['Name'] = df['Name'].str.title() # 각 단어의 첫 글자만 대문자로

# 앞뒤 공백 제거

df['Name'] = df['Name'].str.strip()

# 특정 문자 제거

df['Phone'] = df['Phone'].str.replace('-', '') # 하이픈 제거

# 정규 표현식 사용

import re

df['Text'] = df['Text'].apply(lambda x: re.sub('[^a-zA-Z0-9]', '', x)) # 알파벳과 숫자만 남기기

이렇게 하면 문자열 데이터의 형식을 깔끔하게 정리할 수 있어.

2. 날짜/시간 데이터 정리하기

날짜와 시간 데이터는 특히 형식이 중요해. Pandas에서는 to_datetime() 함수를 사용해 쉽게 날짜 형식을 변환할 수 있어:

# 문자열을 날짜로 변환

df['Date'] = pd.to_datetime(df['Date'])

# 특정 형식의 문자열을 날짜로 변환

df['Date'] = pd.to_datetime(df['Date'], format='%Y-%m-%d')

# 날짜에서 년, 월, 일 추출

df['Year'] = df['Date'].dt.year

df['Month'] = df['Date'].dt.month

df['Day'] = df['Date'].dt.day

이렇게 하면 날짜 데이터를 일관된 형식으로 만들 수 있고, 필요한 정보도 쉽게 추출할 수 있어.

3. 수치형 데이터 정리하기

수치형 데이터도 형식을 통일해야 해. 예를 들어, 소수점 자릿수를 맞추거나, 단위를 통일하는 작업이 필요할 수 있어:

# 소수점 자릿수 맞추기

df['Price'] = df['Price'].round(2)

# 단위 변환 (예: 미터를 킬로미터로)

df['Distance_km'] = df['Distance_m'] / 1000

# 백분율을 소수로 변환

df['Rate'] = df['Rate'].str.rstrip('%').astype('float') / 100

이런 방식으로 수치형 데이터의 형식을 일관되게 만들 수 있어.

4. 범주형 데이터 정리하기

범주형 데이터는 같은 의미인데 다르게 표현된 경우가 많아. 이런 경우 매핑을 통해 통일시킬 수 있어:

# 범주 매핑

gender_map = {'M': 'Male', 'F': 'Female', 'Male': 'Male', 'Female': 'Female'}

df['Gender'] = df['Gender'].map(gender_map)

# 범주 합치기

df['Age_Group'] = pd.cut(df['Age'], bins=[0, 18, 35, 60, 100], labels=['Child', 'Young Adult', 'Adult', 'Senior'])

이렇게 하면 범주형 데이터를 일관성 있게 만들 수 있어.

5. 데이터 타입 변환하기

때로는 데이터의 타입을 변환해야 할 때가 있어. Pandas에서는 astype() 함수를 사용해 쉽게 데이터 타입을 변환할 수 있어:

# 문자열을 정수로 변환

df['Age'] = df['Age'].astype(int)

# 문자열을 실수로 변환

df['Price'] = df['Price'].astype(float)

# 불리언 타입으로 변환

df['Is_Active'] = df['Is_Active'].astype(bool)

이렇게 하면 각 열의 데이터 타입을 원하는 대로 변환할 수 있어.

데이터 형식을 정리하는 작업은 재능넷에서 데이터 분석 프로젝트를 할 때 정말 중요해. 클라이언트의 데이터가 여러 소스에서 온 경우, 형식이 제각각일 수 있거든. 이때 너의 데이터 클리닝 스킬이 빛을 발할 거야! 😎

위 그림은 데이터 형식을 정리하는 전체적인 과정을 보여주고 있어. 문자열, 날짜/시간, 수치형 데이터를 각각 정리하고, 필요한 경우 데이터 타입을 변환해서 최종적으로 일관된 데이터 형식을 만드는 과정이야. 이렇게 정리된 데이터는 분석하기가 훨씬 쉬워질 거야!

자, 이제 우리는 데이터 클리닝의 주요 기법들을 모두 살펴봤어. 결측치 처리, 이상치 처리, 그리고 데이터 형식 정리까지. 이 기술들을 잘 활용하면 어떤 더러운 데이터라도 깨끗하게 만들 수 있을 거야. 다음 섹션에서는 이 모든 기법들을 종합해서 실제 데이터 클리닝 프로세스를 어떻게 진행하는지 알아볼 거야. 준비됐니? 계속 가보자! 🚀

6. 실전 데이터 클리닝: 모든 것을 종합해보자! 🧩

자, 이제 우리가 배운 모든 기법들을 종합해서 실제 데이터 클리닝 프로세스를 진행해볼 거야. 가상의 고객 데이터를 예로 들어볼게. 이 데이터에는 고객의 이름, 나이, 이메일, 구매 금액, 구매 날짜 등의 정보가 있어. 하지만 이 데이터는 꽤 지저분해서 우리의 클리닝 스킬이 필요해!

1단계: 데이터 불러오기 및 확인

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

# 데이터 불러오기

df = pd.read_csv('messy_customer_data.csv')

# 데이터 확인

print(df.head())

print(df.info())

print(df.describe())

먼저 데이터를 불러오고 기본적인 정보를 확인해. 이를 통해 어떤 열이 있는지, 각 열의 데이터 타입은 무엇인지, 결측치는 얼마나 있는지 등을 파악할 수 있어.

2단계: 결측치 처리

# 결측치 확인

print(df.isnull().sum())

# 이메일 결측치 제거

df = df.dropna(subset=['Email'])

# 나이 결측치 평균으로 대체

df['Age'].fillna(df['Age'].mean(), inplace=True)

# 구매금액 결측치 중앙값으로 대체

df['Purchase_Amount'].fillna(df['Purchase_Amount'].median(), inplace=True)

각 열의 특성에 따라 적절한 결측치 처리 방법을 선택해. 이메일은 중요한 정보이므로 결측치가 있는 행을 제거하고, 나이와 구매금액은 각각 평균과 중앙값으로 대체했어.

3단계: 이상치 처리

# 나이 이상치 확인 및 처리

Q1 = df['Age'].quantile(0.25)

Q3 = df['Age'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

df['Age'] = df['Age'].clip(lower=lower_bound, upper=upper_bound)

# 구매금액 이상치 시각화

plt.figure(figsize=(10, 6))

sns.boxplot(x=df['Purchase_Amount'])

plt.title('Purchase Amount Distribution')

plt.show()

# 구매금액 로그 변환

df['Purchase_Amount_Log'] = np.log1p(df['Purchase_Amount'])

나이의 경우 IQR 방법을 사용해 이상치를 처리했고, 구매금액의 경우 로그 변환을 통해 분포를 조정했어. 이상치 처리 전후로 시각화를 통해 분포 변화를 확인하는 것이 좋아.

4단계: 데이터 형식 정리

# 이름 형식 정리

df['Name'] = df['Name'].str.title().str.strip()

# 이메일 소문자로 변환

df['Email'] = df['Email'].str.lower()

# 구매날짜 datetime 형식으로 변환

df['Purchase_Date'] = pd.to_datetime(df['Purchase_Date'])

# 연도와 월 추출

df['Purchase_Year'] = df['Purchase_Date'].dt.year

df['Purchase_Month'] = df['Purchase_Date'].dt.month

각 열의 데이터 형식을 일관되게 만들어줘. 이름은 각 단어의 첫 글자만 대문자로, 이메일은 모두 소문자로 변환했어. 구매날짜는 datetime 형식으로 변환하고, 추가로 연도와 월 정보를 추출했어.

5단계: 데이터 검증 및 최종 확인

# 중복 데이터 확인 및 제거

duplicates = df.duplicated().sum()

print(f"중복된 행의 수: {duplicates}")

df = df.drop_duplicates()

# 최종 데이터 확인

print(df.info())

print(df.describe())

# 상관관계 확인

plt.figure(figsize=(10, 8))

sns.heatmap(df.corr(), annot=True, cmap='coolwarm')

plt.title('Correlation Heatmap')

plt.show()

마지막으로 중복 데이터를 제거하고, 클리닝된 데이터의 기본 정보와 통계량을 다시 확인해. 또한 변수들 간의 상관관계를 시각화해서 전체적인 데이터의 특성을 파악해.

자, 이렇게 해서 우리의 데이터 클리닝 과정이 완료됐어! 이제 이 깨끗해진 데이터로 원하는 분석을 진행할 수 있게 됐지. 😊

이런 종합적인 데이터 클리닝 능력은 재능넷에서 데이터 분석 프로젝트를 수행할 때 정말 큰 강점이 될 거야. 클라이언트들은 깨끗하고 분석하기 좋은 형태의 데이터를 원하거든. 네가 이런 스킬을 가지고 있다면, 많은 프로젝트에서 높은 평가를 받을 수 있을 거야! 💪

위 그림은 우리가 방금 수행한 데이터 클리닝 프로세스를 시각화한 거야. 데이터 불러오기부터 시작해서 결측치 처리, 이상치 처리, 형식 정리, 데이터 검증, 그리고 최종 확인까지의 과정을 한눈에 볼 수 있지? 이런 체계적인 프로세스를 따르면 어떤 복잡한 데이터라도 깔끔하게 정리할 수 있어!

자, 이제 우리는 Python을 이용한 데이터 클리닝의 A to Z를 모두 살펴봤어. 결측치 처리부터 이상치 처리, 데이터 형식 정리, 그리고 전체 프로세스까지. 이 모든 기술들을 마스터하면, 너는 진정한 데이터 클리닝 전문가가 될 수 있을 거야! 🏆

마무리: 데이터 클리닝의 중요성

데이터 클리닝은 단순히 데이터를 깨끗하게 만드는 것 이상의 의미가 있어. 이는 신뢰할 수 있는 분석 결과를 얻기 위한 필수적인 과정이야. 깨끗한 데이터는 더 정확한 인사이트를 제공하고, 더 나은 의사결정을 가능하게 해줘.

특히 재능넷과 같은 플랫폼에서 데이터 분석 프로젝트를 수행할 때, 이런 데이터 클리닝 능력은 정말 중요해. 클라이언트들은 종종 '더러운' 데이터를 가져오고, 그걸 의미 있는 정보로 변환해달라고 요청하거든. 네가 이런 데이터 클리닝 스킬을 가지고 있다면, 많은 프로젝트에서 높은 평가를 받을 수 있을 거야.

마지막으로, 데이터 클리닝은 끊임없이 발전하는 분야야. 새로운 도구와 기술이 계속해서 나오고 있어. 그러니 항상 최신 트렌드를 따라가고, 새로운 기술을 배우는 것을 두려워하지 마. 계속해서 공부하고 실습해보면, 너의 데이터 클리닝 스킬은 점점 더 발전할 거야.

자, 이제 너는 Python으로 데이터 클리닝을 하는 방법을 모두 배웠어. 이 지식을 가지고 실제 프로젝트에 적용해보면서 더 많은 경험을 쌓아가길 바라. 데이터 세계는 너무나 넓고 흥미로워. 계속해서 탐험하고 배워나가자! 화이팅! 💪😄

- 지식인의 숲 - 지적 재산권 보호 고지

지적 재산권 보호 고지

- 저작권 및 소유권: 본 컨텐츠는 재능넷의 독점 AI 기술로 생성되었으며, 대한민국 저작권법 및 국제 저작권 협약에 의해 보호됩니다.

- AI 생성 컨텐츠의 법적 지위: 본 AI 생성 컨텐츠는 재능넷의 지적 창작물로 인정되며, 관련 법규에 따라 저작권 보호를 받습니다.

- 사용 제한: 재능넷의 명시적 서면 동의 없이 본 컨텐츠를 복제, 수정, 배포, 또는 상업적으로 활용하는 행위는 엄격히 금지됩니다.

- 데이터 수집 금지: 본 컨텐츠에 대한 무단 스크래핑, 크롤링, 및 자동화된 데이터 수집은 법적 제재의 대상이 됩니다.

- AI 학습 제한: 재능넷의 AI 생성 컨텐츠를 타 AI 모델 학습에 무단 사용하는 행위는 금지되며, 이는 지적 재산권 침해로 간주됩니다.

재능넷은 최신 AI 기술과 법률에 기반하여 자사의 지적 재산권을 적극적으로 보호하며,

무단 사용 및 침해 행위에 대해 법적 대응을 할 권리를 보유합니다.

© 2025 재능넷 | All rights reserved.

댓글 0개