딥 Q-네트워크(DQN)의 변형과 개선 기법 🚀

안녕하세요, 인공지능과 강화학습의 세계로 여러분을 초대합니다! 오늘은 특별히 흥미진진한 주제, 바로 '딥 Q-네트워크(DQN)의 변형과 개선 기법'에 대해 깊이 있게 탐구해볼 거예요. 🤖✨

여러분, 혹시 게임을 하다가 "와, 이 AI 대단하다!"라고 생각해본 적 있나요? 아니면 자율주행 자동차의 뉴스를 보면서 "도대체 어떻게 이런 게 가능할까?"라고 궁금해한 적 있나요? 그렇다면 여러분은 이미 DQN의 마법에 빠져있었던 겁니다! 😉

DQN은 강화학습의 핵심 알고리즘 중 하나로, 복잡한 환경에서도 놀라운 성능을 보여주고 있어요. 하지만 여기서 멈추지 않고, 연구자들은 계속해서 DQN을 개선하고 변형하여 더 뛰어난 성능을 끌어내고 있답니다. 마치 재능넷에서 다양한 재능을 공유하고 발전시키는 것처럼 말이죠!

자, 이제 우리의 흥미진진한 여정을 시작해볼까요? 준비되셨나요? 그럼 출발~! 🚗💨

1. DQN의 기본 개념 복습 📚

먼저, DQN의 기본 개념부터 간단히 복습해볼까요? DQN은 'Deep Q-Network'의 약자로, Q-learning과 딥러닝을 결합한 강력한 강화학습 알고리즘이에요.

🔑 Key Point: DQN은 환경과 상호작용하면서 최적의 행동 정책을 학습하는 알고리즘입니다.

DQN의 핵심 아이디어는 다음과 같아요:

- Q-함수를 신경망으로 근사

- 경험 리플레이(Experience Replay) 사용

- 타겟 네트워크(Target Network) 도입

이 세 가지 요소가 DQN의 성능을 크게 향상시켰죠. 하지만 여기서 끝이 아닙니다! 연구자들은 이를 기반으로 더 나은 알고리즘을 개발하기 위해 노력했어요. 마치 재능넷에서 다양한 재능을 가진 사람들이 서로의 아이디어를 공유하고 발전시키는 것처럼 말이죠! 😊

이 그림에서 볼 수 있듯이, DQN은 세 가지 핵심 요소가 유기적으로 결합되어 작동합니다. 이제 이 기본 구조를 바탕으로, 어떻게 연구자들이 DQN을 개선하고 변형했는지 살펴볼까요? 🕵️♀️

2. Double DQN: 과대평가 문제 해결하기 🎭

자, 이제 DQN의 첫 번째 주요 변형인 Double DQN에 대해 알아볼까요? Double DQN은 기존 DQN의 과대평가(overestimation) 문제를 해결하기 위해 등장했어요.

🔍 과대평가 문제란? DQN이 특정 상태에서의 행동 가치(Q-value)를 실제보다 높게 평가하는 현상을 말합니다.

Double DQN의 핵심 아이디어는 정말 간단해요. 바로 행동 선택과 평가를 분리하는 것입니다. 어떻게 작동하는지 자세히 살펴볼까요?

- 행동 선택: 현재 네트워크를 사용하여 최적의 행동을 선택합니다.

- 가치 평가: 선택된 행동의 가치를 타겟 네트워크를 사용하여 평가합니다.

이렇게 하면 어떤 장점이 있을까요? 바로 과대평가 편향을 줄일 수 있다는 거예요! 마치 재능넷에서 다양한 전문가들의 의견을 종합해 더 객관적인 평가를 얻는 것과 비슷하죠. 😉

이 그림에서 볼 수 있듯이, Double DQN은 두 개의 네트워크를 사용하여 행동 선택과 가치 평가를 분리합니다. 이를 통해 더 안정적이고 정확한 학습이 가능해지죠!

Double DQN의 수학적 표현은 다음과 같아요:

Q(s,a) = r + γ Q_target(s', argmax_a Q(s',a))여기서 Q는 현재 네트워크, Q_target은 타겟 네트워크를 나타냅니다. 이 방식으로 Double DQN은 기존 DQN보다 더 정확한 Q-값을 추정할 수 있게 되었어요.

💡 Pro Tip: Double DQN을 구현할 때는 기존 DQN 코드에 약간의 수정만 하면 돼요. 주로 타겟 계산 부분만 바꾸면 됩니다!

Double DQN의 성능 향상은 여러 벤치마크 테스트에서 입증되었어요. 특히 Atari 게임에서 기존 DQN보다 훨씬 안정적이고 높은 점수를 얻을 수 있었죠. 이는 마치 재능넷에서 전문가의 조언을 받아 자신의 실력을 크게 향상시키는 것과 비슷하답니다! 🏆

하지만 여기서 끝이 아니에요. 연구자들은 계속해서 DQN을 개선하고 있죠. 다음으로는 어떤 혁신적인 아이디어가 등장했을까요? 함께 알아보러 가볼까요? 🚀

3. Dueling DQN: 가치와 장점을 분리하다 ⚖️

이번에는 DQN의 또 다른 흥미로운 변형인 Dueling DQN에 대해 알아볼까요? Dueling DQN은 상태 가치(state value)와 행동 장점(action advantage)을 분리하여 학습하는 혁신적인 방법을 제안했어요.

🔑 Key Concept: Dueling DQN은 Q-함수를 두 개의 별도 스트림으로 분해합니다: 상태 가치 함수 V(s)와 행동 장점 함수 A(s,a).

이게 무슨 말일까요? 쉽게 설명해볼게요! 😊

- 상태 가치 V(s): 특정 상태에 있는 것이 얼마나 좋은지를 나타냅니다.

- 행동 장점 A(s,a): 특정 상태에서 특정 행동을 하는 것이 다른 행동에 비해 얼마나 좋은지를 나타냅니다.

이 두 가지를 분리해서 학습하면 어떤 장점이 있을까요? 바로 각 상태의 가치를 더 정확하게 추정할 수 있고, 특정 행동의 상대적 중요성을 더 잘 파악할 수 있어요. 마치 재능넷에서 어떤 분야의 전문가가 되는 것(상태 가치)과 그 분야에서 특정 기술을 익히는 것(행동 장점)을 구분해서 생각하는 것과 비슷하죠! 🎭

이 그림에서 볼 수 있듯이, Dueling DQN은 네트워크의 출력단을 두 개의 스트림으로 나눕니다. 하나는 상태 가치 V(s)를 추정하고, 다른 하나는 행동 장점 A(s,a)를 추정하죠. 그리고 이 두 값을 결합하여 최종 Q-값을 계산합니다.

Dueling DQN의 Q-값 계산식은 다음과 같아요:

Q(s,a) = V(s) + (A(s,a) - mean(A(s,a)))여기서 mean(A(s,a))는 모든 행동에 대한 장점의 평균값입니다. 이렇게 평균을 빼주는 이유는 안정성을 높이고 학습을 더 효과적으로 만들기 위해서예요.

💡 Interesting Fact: Dueling DQN은 특히 행동의 선택이 상태의 가치에 큰 영향을 미치지 않는 상황에서 더 효과적입니다. 예를 들어, 자율주행 차량이 직선 도로를 주행할 때는 약간의 방향 조정이 큰 차이를 만들지 않죠.

Dueling DQN의 장점은 다음과 같아요:

- 상태 가치와 행동 장점을 분리함으로써 더 정확한 가치 추정이 가능합니다.

- 특정 상태에서 어떤 행동이 더 중요한지 명확하게 파악할 수 있습니다.

- 학습 속도가 향상되고, 특히 큰 행동 공간을 가진 문제에서 효과적입니다.

이런 장점들 덕분에 Dueling DQN은 여러 벤치마크 테스트에서 기존의 DQN이나 Double DQN보다 우수한 성능을 보여주었어요. 특히 Atari 게임에서 놀라운 성과를 거두었죠. 마치 재능넷에서 전문가의 조언을 받아 자신의 강점을 정확히 파악하고 발전시키는 것과 같답니다! 🌟

Dueling DQN의 아이디어는 정말 혁신적이죠? 하지만 여기서 끝이 아니에요. DQN의 세계는 계속해서 진화하고 있답니다. 다음으로는 어떤 흥미진진한 변형을 만나볼 수 있을까요? 함께 알아보러 가볼까요? 🚀

4. Prioritized Experience Replay: 중요한 경험을 더 자주 복습하기 🔍

자, 이제 우리의 여정은 DQN의 또 다른 흥미로운 변형인 Prioritized Experience Replay(PER)로 향합니다. PER는 경험 리플레이 버퍼에서 샘플링하는 방식을 개선한 알고리즘이에요. 어떻게 작동하는지 자세히 알아볼까요? 😊

🔑 Core Idea: 모든 경험이 동등하게 중요한 것은 아닙니다. 더 중요한(즉, 더 많은 정보를 제공하는) 경험을 더 자주 샘플링하여 학습 효율을 높입니다.

PER의 작동 원리는 다음과 같아요:

- 우선순위 할당: 각 경험에 우선순위를 부여합니다. 주로 TD 오차의 절대값을 사용해요.

- 확률적 샘플링: 우선순위에 비례하는 확률로 경험을 샘플링합니다.

- 중요도 가중치 보정: 샘플링 편향을 보정하기 위해 중요도 가중치를 사용합니다.

이렇게 하면 더 많은 정보를 제공하는 경험을 더 자주 학습할 수 있어요. 마치 재능넷에서 더 유익한 강의나 튜토리얼을 반복해서 학습하는 것과 비슷하죠! 📚

이 그림에서 볼 수 있듯이, PER는 경험 리플레이 버퍼에서 우선순위에 따라 샘플을 선택하고, 이를 학습에 사용합니다. 이 과정을 통해 더 효율적인 학습이 가능해지죠.

PER의 수학적 표현은 다음과 같아요:

P(i) = (|δᵢ| + ε)ᵅ / Σⱼ(|δⱼ| + ε)ᵅ여기서 P(i)는 경험 i가 선택될 확률, δᵢ는 TD 오차, ε은 작은 상수(0으로 나누는 것을 방지), α는 우선순위의 정도를 조절하는 하이퍼파라미터입니다.

💡 Pro Tip: PER를 구현할 때는 효율적인 자료구조(예: sum tree)를 사용하는 것이 중요해요. 이를 통해 대규모 버퍼에서도 빠른 샘플링이 가능합니다!

PER의 장점은 다음과 같아요:

- 학습 효율성 향상: 중요한 경험을 더 자주 학습함으로써 학습 속도가 빨라집니다.

- 샘플 효율성: 적은 수의 경험으로도 효과적인 학습이 가능합니다.

- 희귀한 경험 활용: 드물게 발생하지만 중요한 경험을 놓치지 않고 학습에 활용할 수 있습니다.

이러한 장점들 덕분에 PER는 여러 강화학습 태스크에서 기존의 균일 샘플링 방식보다 우수한 성능을 보여주었어요. 특히 복잡한 환경에서 더욱 효과적이죠. 마치 재능넷에서 자신에게 가장 도움이 되는 콘텐츠를 선별해서 집중적으로 학습하는 것과 같답니다! 🎯

하지만 PER에도 주의해야 할 점이 있어요:

- 계산 복잡성: 우선순위 계산과 샘플링 과정이 추가되어 계산 비용이 증가할 수 있습니다.

- 하이퍼파라미터 조정: α, β 등의 하이퍼파라미터를 적절히 조정해야 최적의 성능을 얻을 수 있습니다.

- 편향 문제: 중요도 가중치로 보정하지만, 여전히 약간의 편향이 남을 수 있습니다.

이러한 도전과제들에도 불구하고, PER는 DQN의 성능을 크게 향상시키는 강력한 기법이에요. 많은 연구자들이 이를 기반으로 더 발전된 알고리즘을 개발하고 있죠.

자, 여기까지 Prioritized Experience Replay에 대해 알아보았습니다. 정말 흥미진진하지 않나요? DQN의 세계는 계속해서 진화하고 있어요. 다음으로는 어떤 혁신적인 아이디어를 만나볼 수 있을까요? 함께 알아보러 가볼까요? 🚀

5. Rainbow DQN: 모든 색깔을 한데 모으다 🌈

자, 이제 우리의 여정은 DQN의 진화의 정점이라고 할 수 있는 Rainbow DQN으로 향합니다. Rainbow DQN은 지금까지 살펴본 여러 DQN 개선 기법들을 하나로 통합한 알고리즘이에요. 마치 무지개처럼 다양한 색깔(기법들)을 한데 모았다고 해서 이런 이름이 붙었죠! 🌈

🔑 Core Concept: Rainbow DQN은 여러 DQN 개선 기법들의 장점을 결합하여 더 강력하고 안정적인 성능을 제공합니다.

Rainbow DQN에 포함된 주요 기법들은 다음과 같아요:

- Double Q-learning: 과대평가 문제 해결

- Prioritized Experience Replay: 중요한 경험 우선 학습

- Dueling Networks: 상태 가치와 행동 장점 분리

- Multi-step Learning: 여러 단계의 보상을 고려한 학습

- Distributional RL: 가치의 분포를 학습

- Noisy Nets: 파라미터에 노이즈를 추가하여 탐색 강화

이 모든 기법들이 시너지 효과를 내며 함께 작동하는 거예요. 마치 재능넷에서 다양한 분야의 전문가들이 협력하여 더 나은 결과를 만들어내는 것과 같죠! 🤝

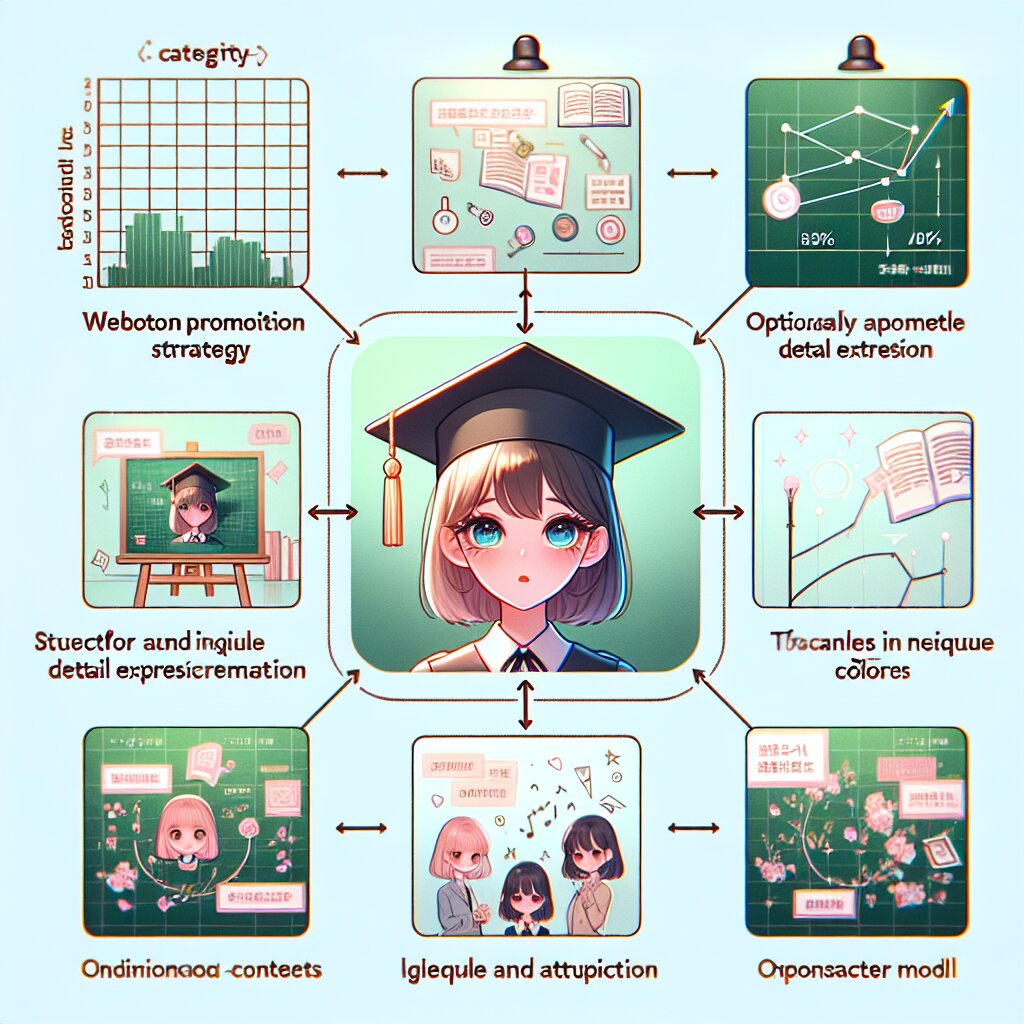

이 그림에서 볼 수 있듯이, Rainbow DQN은 여러 기법들을 하나로 통합하여 더 강력한 알고리즘을 만들어냅니다. 각 기법이 서로 다른 측면을 개선하면서 전체적인 성능을 끌어올리는 거죠.

Rainbow DQN의 장점은 다음과 같아요:

- 최고 수준의 성능: Atari 게임 등 다양한 환경에서 최고 수준의 성능을 보여줍니다.

- 안정성: 여러 기법의 조합으로 학습이 더욱 안정적입니다.

- 일반화 능력: 다양한 문제에 잘 적용될 수 있습니다.

- 샘플 효율성: 적은 수의 샘플로도 효과적인 학습이 가능합니다.

💡 Interesting Fact: Rainbow DQN은 Atari 게임 57개 중 대부분에서 인간 전문가 수준을 넘어서는 성능을 보여주었어요. 몇몇 게임에서는 인간의 최고 기록을 크게 뛰어넘기도 했죠!

하지만 Rainbow DQN에도 몇 가지 주의할 점이 있어요:

- 복잡성: 여러 기법을 결합하다 보니 알고리즘이 복잡해지고 구현이 어려울 수 있습니다.

- 계산 비용: 여러 기법을 동시에 사용하므로 계산 비용이 높아질 수 있습니다.

- 하이퍼파라미터 조정: 각 기법마다 하이퍼파라미터가 있어 최적화가 까다로울 수 있습니다.

이러한 도전과제에도 불구하고, Rainbow DQN은 현재 DQN 계열 알고리즘 중 가장 강력한 성능을 보여주고 있어요. 마치 재능넷에서 다양한 분야의 최고 전문가들이 모여 하나의 프로젝트를 완성하는 것과 같죠! 🏆

Rainbow DQN의 등장으로 DQN의 진화는 한 단계 더 도약했습니다. 하지만 여기서 끝이 아니에요. 연구자들은 계속해서 더 나은 알고리즘을 개발하기 위해 노력하고 있죠. 앞으로 어떤 혁신적인 아이디어가 등장할지 정말 기대되지 않나요? 🚀

자, 여기까지 Rainbow DQN에 대해 알아보았습니다. 정말 흥미진진한 여정이었죠? DQN의 세계는 끊임없이 발전하고 있어요. 이제 우리의 여정도 마무리 단계에 접어들었습니다. 마지막으로 이 모든 내용을 정리하고, 앞으로의 전망에 대해 이야기해볼까요? 함께 가볼까요? 😊

6. 결론 및 미래 전망: DQN의 끝없는 여정 🚀

와우! 정말 긴 여정이었죠? DQN의 기본 개념부터 시작해서 Double DQN, Dueling DQN, Prioritized Experience Replay, 그리고 마지막으로 Rainbow DQN까지, 우리는 DQN의 진화 과정을 함께 살펴보았어요. 이제 이 모든 내용을 정리하고, 앞으로의 전망에 대해 이야기해볼까요? 🌟

🔑 Key Takeaway: DQN은 끊임없는 혁신과 개선을 통해 더욱 강력하고 효율적인 알고리즘으로 진화해왔습니다. 이러한 발전은 강화학습의 실용성을 크게 높였고, 다양한 분야에서의 응용 가능성을 열었습니다.

DQN의 진화 과정을 간단히 정리해볼까요?

- DQN: Q-learning과 딥러닝의 결합, 경험 리플레이와 타겟 네트워크 도입

- Double DQN: 과대평가 문제 해결을 위한 행동 선택과 평가 분리

- Dueling DQN: 상태 가치와 행동 장점을 분리하여 학습 효율성 향상

- Prioritized Experience Replay: 중요한 경험을 우선적으로 학습

- Rainbow DQN: 여러 개선 기법들을 통합하여 최고 수준의 성능 달성

이러한 발전은 마치 재능넷에서 다양한 전문가들이 협력하여 더 나은 서비스를 만들어가는 과정과 비슷하죠! 각자의 전문성을 살려 전체적인 성능을 끌어올리는 거예요. 👥

이 그림에서 볼 수 있듯이, DQN은 지속적인 개선을 통해 성능이 크게 향상되었습니다. 각 단계마다 새로운 아이디어가 도입되어 알고리즘의 성능을 한 단계씩 끌어올렸죠.

그렇다면 DQN의 미래는 어떨까요? 🔮

- 더 큰 규모의 문제 해결: 더 복잡하고 큰 규모의 실제 문제들을 해결할 수 있는 방향으로 발전할 것입니다.

- 효율성 향상: 더 적은 데이터와 계산 자원으로 더 나은 성능을 낼 수 있는 방법들이 연구될 것입니다.

- 다른 AI 기술과의 융합: 예를 들어, 자연어 처리나 컴퓨터 비전 기술과 결합하여 더 다양한 문제를 해결할 수 있을 것입니다.

- 설명 가능한 AI: DQN의 의사결정 과정을 더 잘 이해하고 설명할 수 있는 방법들이 개발될 것입니다.

- 실제 세계 적용: 자율주행, 로봇공학, 의료 등 다양한 분야에서 DQN의 실제 적용이 더욱 확대될 것입니다.

💡 Food for Thought: DQN의 발전은 단순히 기술적인 진보를 넘어, 우리의 삶과 사회를 어떻게 변화시킬까요? 예를 들어, 자율주행 기술의 발전은 교통 시스템을 어떻게 바꿀까요?

DQN의 여정은 여기서 끝나지 않습니다. 연구자들은 계속해서 새로운 아이디어를 탐구하고, 더 나은 알고리즘을 개발하기 위해 노력하고 있어요. 마치 재능넷에서 끊임없이 새로운 재능을 발굴하고 발전시키는 것처럼 말이죠! 🌱

여러분도 이 흥미진진한 여정에 동참할 수 있어요. 강화학습과 DQN에 대해 더 깊이 공부하고, 직접 구현해보고, 새로운 아이디어를 탐구해보는 건 어떨까요? 누가 알겠어요, 여러분의 아이디어가 DQN의 다음 큰 혁신을 이끌어낼지도 모르니까요! 🚀

자, 이제 우리의 긴 여정이 끝났습니다. DQN의 세계는 정말 흥미진진하고 무한한 가능성으로 가득 차 있죠? 이 여정이 여러분에게 영감을 주고, 새로운 도전을 시작하는 계기가 되었기를 바랍니다. 함께 AI의 미래를 만들어갈 준비가 되셨나요? Let's go! 🌟