Go 언어에서의 캐싱 전략과 구현 🚀

안녕하세요, 여러분! 오늘은 Go 언어에서의 캐싱 전략과 구현에 대해 깊이 있게 파헤쳐볼 거예요. 이 주제가 좀 어렵게 들릴 수도 있겠지만, 걱정 마세요! 제가 쉽고 재미있게 설명해드릴게요. 마치 카톡으로 친구랑 얘기하듯이 편하게 읽어주세요. ㅋㅋㅋ

먼저, 캐싱이 뭔지 아시나요? 간단히 말하면, 자주 사용하는 데이터를 빠르게 접근할 수 있는 곳에 저장해두는 거예요. 마치 여러분이 자주 먹는 과자를 책상 서랍에 넣어두는 것처럼요! 🍪

Go 언어에서 캐싱을 구현하는 건 정말 중요해요. 왜냐고요? 프로그램의 성능을 엄청나게 향상시킬 수 있거든요! 마치 재능넷에서 여러분의 재능을 빠르게 찾아주는 것처럼, 캐싱은 데이터를 빠르게 찾아줘요.

💡 알고 계셨나요? 재능넷(https://www.jaenung.net)은 다양한 재능을 거래할 수 있는 플랫폼이에요. 여기서 우리가 배울 Go 언어 캐싱 기술도 하나의 재능이 될 수 있죠!

자, 이제 본격적으로 Go 언어에서의 캐싱 전략과 구현에 대해 알아볼까요? 준비되셨나요? 고고! 🚀

1. 캐싱의 기본 개념 🧠

먼저 캐싱의 기본 개념부터 확실히 잡고 가볼게요. 캐싱이란 뭘까요? 간단히 말해서, 자주 사용하는 데이터를 빠르게 접근할 수 있는 곳에 임시로 저장해두는 기술이에요.

예를 들어볼까요? 여러분이 매일 아침 학교나 회사에 갈 때 필요한 물건들이 있잖아요. 가방, 열쇠, 지갑 같은 것들요. 이런 물건들을 매일 아침 집 곳곳을 뒤져 찾는다고 생각해보세요. 엄청 귀찮고 시간도 많이 걸리겠죠?

그래서 우리는 보통 이런 물건들을 현관 옆 선반이나 책상 위 같은 곳에 모아두잖아요. 이게 바로 '캐싱'이에요! 자주 사용하는 물건들을 쉽게 찾을 수 있는 곳에 모아두는 거죠.

🎭 비유로 이해하기

캐싱은 마치 여러분의 뇌가 정보를 기억하는 것과 비슷해요. 자주 사용하는 전화번호나 주소는 쉽게 기억나지만, 오래전에 한 번 들은 정보는 기억하기 어렵죠. 우리 뇌도 일종의 캐시 시스템을 가지고 있는 셈이에요!

컴퓨터 세계에서의 캐싱도 이와 비슷해요. 프로그램이 자주 사용하는 데이터를 메모리의 특별한 영역(캐시)에 저장해두고, 필요할 때마다 빠르게 가져다 쓰는 거예요.

캐싱의 주요 목적은 뭘까요? 바로 성능 향상이에요! 데이터를 매번 원본 소스(예: 데이터베이스, 원격 서버 등)에서 가져오는 대신, 캐시에서 빠르게 가져오면 프로그램의 실행 속도가 훨씬 빨라지겠죠?

하지만 캐싱에도 주의할 점이 있어요:

- 캐시 일관성: 원본 데이터가 변경되면 캐시도 업데이트해야 해요.

- 캐시 크기: 너무 많은 데이터를 캐시에 저장하면 메모리를 과도하게 사용할 수 있어요.

- 캐시 교체 정책: 캐시가 가득 찼을 때 어떤 데이터를 제거할지 결정해야 해요.

이런 점들을 고려하면서 캐싱을 구현해야 효과적인 캐싱 시스템을 만들 수 있어요.

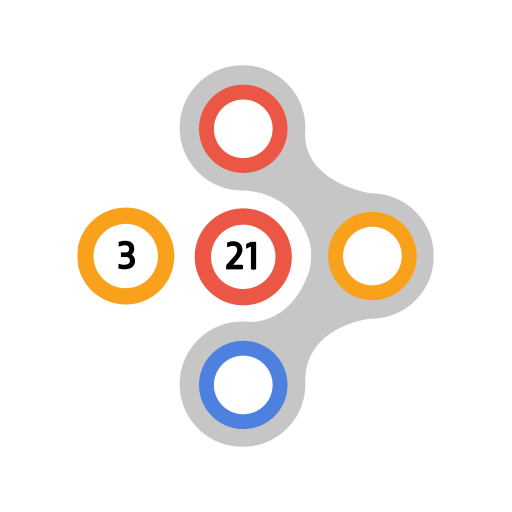

위 그림을 보면 캐싱의 기본 개념을 쉽게 이해할 수 있어요. 프로그램이 데이터를 요청하면 먼저 캐시를 확인하고, 캐시에 없을 때만 원본 데이터에서 가져오는 거죠.

자, 이제 캐싱의 기본 개념을 이해하셨나요? 다음으로 Go 언어에서 이런 캐싱을 어떻게 구현하는지 알아볼게요. Go로 캐시를 구현하는 건 정말 재밌고 유용해요. 마치 재능넷에서 새로운 재능을 발견하는 것처럼 신선한 경험이 될 거예요! 😉

2. Go 언어에서의 캐싱 구현 방법 🛠️

자, 이제 본격적으로 Go 언어에서 캐싱을 어떻게 구현하는지 알아볼까요? Go는 정말 멋진 언어예요. 간결하면서도 강력하죠. 캐싱을 구현하는 데도 아주 적합해요!

Go에서 캐싱을 구현하는 방법은 여러 가지가 있어요. 우리는 가장 기본적이고 많이 사용되는 방법부터 시작해서, 점점 더 복잡하고 강력한 방법들을 살펴볼 거예요. 마치 재능넷에서 초보자 수준의 재능부터 전문가 수준의 재능까지 다양하게 찾아볼 수 있는 것처럼요! 😊

2.1 맵(Map)을 이용한 간단한 캐시 구현

가장 간단한 방법부터 시작해볼게요. Go의 맵(map)을 사용하면 아주 기본적인 캐시를 쉽게 만들 수 있어요.

package main

import (

"fmt"

"sync"

)

type SimpleCache struct {

cache map[string]string

mutex sync.RWMutex

}

func NewSimpleCache() *SimpleCache {

return &SimpleCache{

cache: make(map[string]string),

}

}

func (c *SimpleCache) Set(key, value string) {

c.mutex.Lock()

defer c.mutex.Unlock()

c.cache[key] = value

}

func (c *SimpleCache) Get(key string) (string, bool) {

c.mutex.RLock()

defer c.mutex.RUnlock()

value, ok := c.cache[key]

return value, ok

}

func main() {

cache := NewSimpleCache()

cache.Set("name", "Gopher")

cache.Set("language", "Go")

if name, ok := cache.Get("name"); ok {

fmt.Println("Name:", name)

}

if lang, ok := cache.Get("language"); ok {

fmt.Println("Language:", lang)

}

}

이 코드를 보면, SimpleCache 구조체를 만들고 그 안에 맵을 사용해 데이터를 저장하고 있어요. Set 메서드로 데이터를 저장하고, Get 메서드로 데이터를 가져오죠.

여기서 주목할 점은 mutex를 사용하고 있다는 거예요. 이건 왜 필요할까요? Go는 동시성 프로그래밍을 아주 잘 지원하는 언어예요. 여러 고루틴(goroutine)이 동시에 캐시에 접근할 수 있기 때문에, 데이터 경쟁(race condition)을 방지하기 위해 뮤텍스를 사용하는 거죠.

🔍 Go 팁! Go에서는 sync.RWMutex를 사용해 읽기 작업과 쓰기 작업을 구분할 수 있어요. 읽기 작업은 동시에 여러 개가 가능하지만, 쓰기 작업은 하나만 가능하도록 해서 성능을 최적화할 수 있죠.

이 방식은 간단하지만 몇 가지 한계가 있어요:

- 캐시 크기 제한이 없어요. 메모리를 무한정 사용할 수 있죠.

- 캐시 만료 시간을 설정할 수 없어요.

- 캐시 교체 정책이 없어요.

이런 한계를 극복하기 위해 좀 더 복잡한 구현 방법을 살펴볼까요?

2.2 만료 시간이 있는 캐시 구현

이번에는 각 항목마다 만료 시간을 설정할 수 있는 캐시를 만들어볼게요. 이렇게 하면 일정 시간이 지난 데이터는 자동으로 삭제되니까 더 효율적이겠죠?

package main

import (

"fmt"

"sync"

"time"

)

type CacheItem struct {

Value string

Expiration time.Time

}

type TimedCache struct {

cache map[string]CacheItem

mutex sync.RWMutex

}

func NewTimedCache() *TimedCache {

cache := &TimedCache{

cache: make(map[string]CacheItem),

}

go cache.cleanupLoop()

return cache

}

func (c *TimedCache) Set(key, value string, duration time.Duration) {

c.mutex.Lock()

defer c.mutex.Unlock()

c.cache[key] = CacheItem{

Value: value,

Expiration: time.Now().Add(duration),

}

}

func (c *TimedCache) Get(key string) (string, bool) {

c.mutex.RLock()

defer c.mutex.RUnlock()

item, ok := c.cache[key]

if !ok {

return "", false

}

if time.Now().After(item.Expiration) {

return "", false

}

return item.Value, true

}

func (c *TimedCache) cleanupLoop() {

ticker := time.NewTicker(time.Minute)

for range ticker.C {

c.mutex.Lock()

for key, item := range c.cache {

if time.Now().After(item.Expiration) {

delete(c.cache, key)

}

}

c.mutex.Unlock()

}

}

func main() {

cache := NewTimedCache()

cache.Set("name", "Gopher", 5*time.Second)

cache.Set("language", "Go", 1*time.Minute)

time.Sleep(2 * time.Second)

if name, ok := cache.Get("name"); ok {

fmt.Println("Name:", name)

} else {

fmt.Println("Name not found or expired")

}

time.Sleep(4 * time.Second)

if name, ok := cache.Get("name"); ok {

fmt.Println("Name:", name)

} else {

fmt.Println("Name not found or expired")

}

if lang, ok := cache.Get("language"); ok {

fmt.Println("Language:", lang)

} else {

fmt.Println("Language not found or expired")

}

}

와! 이 코드는 좀 더 복잡해 보이죠? 하지만 천천히 살펴보면 그렇게 어렵지 않아요.

이 캐시의 핵심은 CacheItem 구조체예요. 각 항목마다 값과 만료 시간을 저장하고 있죠. Set 메서드에서는 현재 시간에 지정된 기간을 더해서 만료 시간을 설정해요.

Get 메서드에서는 항목을 가져올 때 만료 시간을 확인해요. 만료된 항목은 마치 없는 것처럼 취급하죠.

그리고 가장 재미있는 부분! cleanupLoop 메서드예요. 이 메서드는 별도의 고루틴에서 실행되면서 주기적으로 만료된 항목들을 삭제해줘요. 마치 청소부 로봇 같죠? 😄

💡 Go 꿀팁! Go의 고루틴과 채널을 이용하면 이런 백그라운드 작업을 아주 쉽게 구현할 수 있어요. 재능넷에서 여러분의 재능을 24시간 홍보해주는 것처럼, 고루틴은 24시간 열심히 일하는 작은 일꾼 같은 거예요!

이 구현은 이전 버전보다 훨씬 좋아졌어요. 하지만 아직도 개선할 점이 있어요:

- 캐시 크기에 제한이 없어요.

- 캐시 교체 정책이 없어요. 그냥 만료된 항목만 삭제할 뿐이죠.

다음 단계에서는 이런 문제들을 해결해볼게요. 준비되셨나요? 고고! 🚀

2.3 LRU(Least Recently Used) 캐시 구현

이번에는 좀 더 고급진 캐시를 만들어볼게요. LRU(Least Recently Used) 캐시라고 하는데요, 가장 오래 사용하지 않은 항목을 제거하는 방식이에요. 실제로 많이 사용되는 캐시 교체 정책이죠.

package main

import (

"container/list"

"fmt"

"sync"

)

type LRUCache struct {

capacity int

cache map[string]*list.Element

list *list.List

mutex sync.RWMutex

}

type entry struct {

key string

value interface{}

}

func NewLRUCache(capacity int) *LRUCache {

return &LRUCache{

capacity: capacity,

cache: make(map[string]*list.Element),

list: list.New(),

}

}

func (c *LRUCache) Get(key string) (interface{}, bool) {

c.mutex.Lock()

defer c.mutex.Unlock()

if elem, ok := c.cache[key]; ok {

c.list.MoveToFront(elem)

return elem.Value.(*entry).value, true

}

return nil, false

}

func (c *LRUCache) Set(key string, value interface{}) {

c.mutex.Lock()

defer c.mutex.Unlock()

if elem, ok := c.cache[key]; ok {

c.list.MoveToFront(elem)

elem.Value.(*entry).value = value

return

}

if c.list.Len() >= c.capacity {

oldest := c.list.Back()

if oldest != nil {

c.list.Remove(oldest)

delete(c.cache, oldest.Value.(*entry).key)

}

}

elem := c.list.PushFront(&entry{key, value})

c.cache[key] = elem

}

func main() {

cache := NewLRUCache(2)

cache.Set("name", "Gopher")

cache.Set("language", "Go")

if name, ok := cache.Get("name"); ok {

fmt.Println("Name:", name)

}

cache.Set("mascot", "Gopher") // This will evict "language"

if lang, ok := cache.Get("language"); ok {

fmt.Println("Language:", lang)

} else {

fmt.Println("Language not found")

}

if mascot, ok := cache.Get("mascot"); ok {

fmt.Println("Mascot:", mascot)

}

}

우와~ 이 코드는 정말 멋져요! 😎 한번 자세히 살펴볼까요?

이 LRU 캐시의 핵심은 map과 doubly linked list를 함께 사용한다는 거예요. map은 빠른 검색을 위해 사용되고, linked list는 항목들의 사용 순서를 추적하는 데 사용돼요.

Get 메서드에서는 항목을 가져올 때마다 해당 항목을 리스트의 맨 앞으로 이동시켜요. 이렇게 하면 가장 최근에 사용된 항목이 항상 리스트의 앞쪽에 위치하게 되죠.

Set 메서드는 좀 더 복잡해요:

- 이미 존재하는 키라면, 값을 업데이트하고 해당 항목을 리스트의 맨 앞으로 이동시켜요.

- 새로운 키라면, 캐시가 가득 찼는지 확인해요. 가득 찼다면 리스트의 맨 뒤에 있는 항목(가장 오래 사용하지 않은 항목)을 제거해요.

- 그리고 새 항목을 리스트의 맨 앞에 추가하고 map에도 추가해요.

🎓 Go 심화 학습! Go의 container/list 패키지는 doubly linked list를 구현하고 있어요. 이를 활용하면 LRU 캐시 같은 복잡한 자료구조도 쉽게 구현할 수 있죠. 마치 재능넷에서 복잡한 재능도 쉽게 찾을 수 있는 것처럼요!

이 LRU 캐시는 이전 버전들보다 훨씬 더 효율적이에요:

- 캐시 크기에 제한이 있어요. 메모리 사용량을 제어할 수 있죠.

- 가장 오래 사용하지 않은 항목을 제거하는 교체 정책이 있어요.

- O(1) 시간 복잡도로 항목을 추가하고 검색할 수 있어요. 엄청 빠르죠!

하지만 아직도 개선할 점이 있어요. 예를 들어, 동시성 처리를 더 효율적으로 할 수 있고, 만료 시간 기능을 추가할 수도 있죠. 그리고 더 복잡한 캐시 정책(예: LFU - Least Frequently Used)을 구현할 수도 있어요.

여러분, 지금까지 Go 언어로 캐시를 구현하는 세 가지 방법을 살펴봤어요. 간단한 맵 기반 캐시부터 시작해서, 만료 시간이 있는 캐시를 거쳐, 마지막으로 LRU 캐시까지요. 이렇게 점점 발전하는 모습이 마치 여러분이 재능넷에서 실력을 키워가는 것 같지 않나요? 😊

다음 섹션에서는 이런 캐시들을 실제 프로젝트에서 어떻게 활용할 수 있는지, 그리고 더 고급 기능들은 어떻게 구현할 수 있는지 알아볼 거예요. 준비되셨나요? 고고! 🚀

3. 실제 프로젝트에서의 캐시 활용 💼

자, 이제 우리가 만든 멋진 캐시들을 실제 프로젝트에서 어떻게 활용할 수 있는지 알아볼까요? 실제 상황에서는 단순히 캐시를 구현하는 것보다 더 많은 고려사항이 있어요. 마치 재능넷에서 여러분의 재능을 어떻게 효과적으로 홍보할지 고민하는 것처럼 말이죠! 😉

3.1 데이터베이스 쿼리 결과 캐싱

가장 흔한 캐시 사용 사례 중 하나는 데이터베이스 쿼리 결과를 캐싱하는 거예요. 데이터베이스 조회는 보통 시간이 많이 걸리는 작업이잖아요? 자주 사용되는 쿼리 결과를 캐시에 저장해두면 성능을 크게 향상시킬 수 있어요.

package main

import (

"database/sql"

"fmt"

"log"

"time"

_ "github.com/go-sql-driver/mysql"

)

type UserCache struct {

cache *TimedCache

db *sql.DB

}

func NewUserCache(db *sql.DB) *UserCache {

return &UserCache{

cache: NewTimedCache(),

db: db,

}

}

func (uc *UserCache) GetUser(id int) (string, error) {

key := fmt.Sprintf("user:%d", id)

if name, ok := uc.cache.Get(key); ok {

return name, nil

}

var name string

err := uc.db.QueryRow("SELECT name FROM users WHERE id = ?", id).Scan(&name)

if err != nil {

return "", err

}

uc.cache.Set(key, name, 5*time.Minute)

return name, nil

}

func main() {

db, err := sql.Open("mysql", "user:password@/dbname")

if err != nil {

log.Fatal(err)

}

defer db.Close()

userCache := NewUserCache(db)

// 첫 번째 호출: 데이터베이스에서 가져옴

name, err := userCache.GetUser(1)

if err != nil {

log.Println(err)

} else {

fmt.Println("User 1:", name)

}

// 두 번째 호출: 캐시에서 가져옴

name, err = userCache.GetUser(1)

if err != nil {

log.Println(err)

} else {

fmt.Println("User 1 (cached):", name)

}

}

이 예제에서는 우리가 앞서 만든 TimedCache를 사용해서 사용자 정보를 캐싱하고 있어요. GetUser 메서드는 먼저 캐시를 확인하고, 캐시에 없으면 데이터베이스에서 정보를 가져와 캐시에 저장해요. 이렇게 하면 자주 요청되는 사용자 정보를 빠르게 제공할 수 있죠.

💡 실무 팁! 실제 프로젝트에서는 캐시 무효화(invalidation)도 중요해요. 예를 들어, 사용자 정보가 변경되면 해당 캐시를 삭제하거나 업데이트해야 해요. 이런 세부사항들이 재능넷에서 여러분의 재능을 더욱 빛나게 만드는 것과 같죠!

3.2 API 응답 캐싱

웹 서비스를 개발할 때 외부 API를 호출하는 경우가 많죠? 이런 API 호출 결과도 캐싱하면 좋아요. 특히 변경이 잦지 않은 데이터라면 더욱 효과적이에요.

package main

import (

"encoding/json"

"fmt"

"io/ioutil"

"log"

"net/http"

"time"

)

type WeatherCache struct {

cache *TimedCache

}

type WeatherData struct {

Temperature float64 `json:"temperature"`

Humidity float64 `json:"humidity"`

}

func NewWeatherCache() *WeatherCache {

return &WeatherCache{

cache: NewTimedCache(),

}

}

func (wc *WeatherCache) GetWeather(city string) (*WeatherData, error) {

if data, ok := wc.cache.Get(city); ok {

return data.(*WeatherData), nil

}

url := fmt.Sprintf("https://api.example.com/weather?city=%s", city)

resp, err := http.Get(url)

if err != nil {

return nil, err

}

defer resp.Body.Close()

body, err := ioutil.ReadAll(resp.Body)

if err != nil {

return nil, err

}

var weatherData WeatherData

err = json.Unmarshal(body, &weatherData)

if err != nil {

return nil, err

}

wc.cache.Set(city, &weatherData, 30*time.Minute)

return &weatherData, nil

}

func main() {

weatherCache := NewWeatherCache()

// 첫 번째 호출: API에서 가져옴

weather, err := weatherCache.GetWeather("Seoul")

if err != nil {

log.Println(err)

} else {

fmt.Printf("Seoul Weather: %.1f°C, %.1f%%\n", weather.Temperature, weather.Humidity)

}

// 두 번째 호출: 캐시에서 가져옴

weather, err = weatherCache.GetWeather("Seoul")

if err != nil {

log.Println(err)

} else {

fmt.Printf("Seoul Weather (cached): %.1f°C, %.1f%%\n", weather.Temperature, weather.Humidity)

}

}

이 예제에서는 날씨 API 응답을 캐싱하고 있어요. GetWeather 메서드는 먼저 캐시를 확인하고, 캐시에 없으면 실제 API를 호출해요. API 응답은 30분 동안 캐시에 저장되죠. 이렇게 하면 API 호출 횟수를 줄이고 응답 시간을 크게 단축할 수 있어요.

🚀 성능 팁! API 응답을 캐싱할 때는 적절한 만료 시간을 설정하는 게 중요해요. 너무 길면 오래된 데이터를 제공할 수 있고, 너무 짧으면 캐시의 이점을 충분히 활용하지 못하죠. 마치 재능넷에서 여러분의 재능을 적절한 주기로 업데이트하는 것과 비슷해요!

3.3 분산 캐시 시스템 구현

지금까지 본 예제들은 모두 단일 서버에서 동작하는 캐시였어요. 하지만 대규모 시스템에서는 여러 서버에 걸쳐 동작하는 분산 캐시 시스템이 필요할 때가 있죠. Go로 이런 분산 캐시 시스템을 구현할 수도 있어요.

여기서는 간단한 예시로 Redis를 사용한 분산 캐시 시스템을 구현해볼게요.

package main

import (

"fmt"

"log"

"time"

"github.com/go-redis/redis"

)

type DistributedCache struct {

client *redis.Client

}

func NewDistributedCache(addr string) *DistributedCache {

client := redis.NewClient(&redis.Options{

Addr: addr,

})

return &DistributedCache{

client: client,

}

}

func (dc *DistributedCache) Set(key string, value interface{}, expiration time.Duration) error {

return dc.client.Set(key, value, expiration).Err()

}

func (dc *DistributedCache) Get(key string) (string, error) {

return dc.client.Get(key).Result()

}

func main() {

cache := NewDistributedCache("localhost:6379")

err := cache.Set("mykey", "Hello, Distributed Cache!", 5*time.Minute)

if err != nil {

log.Fatal(err)

}

value, err := cache.Get("mykey")

if err != nil {

log.Fatal(err)

}

fmt.Println("Value:", value)

}

이 예제에서는 Redis를 사용해 분산 캐시 시스템을 구현했어요. Redis는 여러 서버에서 공유할 수 있는 인메모리 데이터 저장소예요. 이렇게 하면 여러 서버에서 동일한 캐시 데이터에 접근할 수 있죠.

🌐 확장성 팁! 분산 캐시 시스템을 사용하면 애플리케이션의 확장성을 크게 높일 수 있어요. 서버를 추가하더라도 모든 서버가 동일한 캐시 데이터를 공유할 수 있죠. 마치 재능넷에서 여러분의 재능이 전국 방방곡곡으로 퍼져나가는 것과 같아요!

지금까지 Go 언어를 사용한 캐싱 전략과 실제 프로젝트에서의 활용 방법에 대해 알아봤어요. 캐싱은 정말 강력한 성능 최적화 도구예요. 하지만 항상 기억해야 할 것은, 캐시는 데이터의 일관성과 신선도를 유지하는 것과 성능 사이의 균형을 잡는 게 중요하다는 거예요.

여러분도 이제 Go로 멋진 캐시 시스템을 만들 수 있겠죠? 마치 재능넷에서 여러분의 재능을 마음껏 뽐내는 것처럼, Go의 캐싱 기능을 프로젝트에 적용해 보세요. 여러분의 애플리케이션이 더욱 빛나게 될 거예요! 😊🚀